ICML 2023 是第四十届国际机器学习会议,将于 2023 年 7 月 23 日至 29 日在美国夏威夷举行。ICML 共收到 6538 份投稿,其中 1827 份被接收,接收率约为 27.9%。作为对比,去年共收到 5630 投稿,接收 1117 篇 short oral,118 篇 long oral,录用率为 21.94%。ICML(International Conference on Machine Learning,国际机器学习大会)为国际机器学习学会主办的国际会议,被公认是人工智能、机器学习领域最顶级的国际会议之一。

来自Fiddler AI, Harvard University, Hugging Face, 研究科学家在ICML 2023教程《可信赖生成式人工智能》讲解通过人类反馈的强化学习(RLHF),非常值得关注!

人工智能(AI)基础的解决方案越来越多地部署在高风险领域,如医疗、放款、招聘、刑事司法和教育,从而改变了这些行业的运作方式,对个人、企业和整个社会产生影响。因此,确保底层的AI模型做出准确的预测、对数据的变化具有鲁棒性、不依赖于伪特征、不不当地歧视少数群体,以及更广泛地,按照负责任的AI指导原则进行开发和部署是至关重要的。

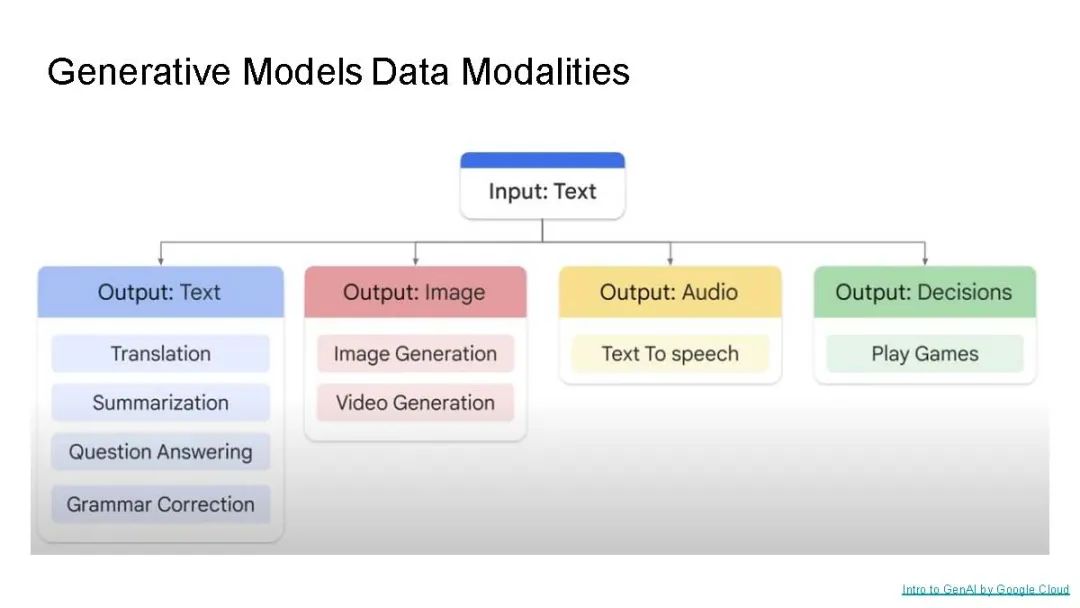

生成性AI模型和应用的快速开发和部署增加了解决上述问题的紧迫性。生成性AI指的是基于现有内容(如文本、图像、音频或视频)创建新的数字文本、图像、音频、视频、代码和其他制品的深度学习模型和系统。如GPT-4和ChatGPT的文本生成模型以及DALL-E 2和Stable Diffusion的文本到图像模型都是生成性AI模型的著名例子。生成性AI对于需要知识工作和创意工作的广泛行业和应用有重要的意义,如写作助手、图形设计、艺术生成、广告、营销和销售的文案撰写、建筑、游戏、编码和药物发现。然而,与生成性AI模型和应用相关的还有许多伦理和社会考虑因素。这些关注点包括缺乏可解释性、偏见和歧视、隐私、模型鲁棒性不足、伪造和误导性内容、版权问题、抄袭以及与生成性AI模型的训练和推断相关的环境影响。鉴于这些风险,按照负责任的AI原则开发和部署生成性AI模型和应用是至关重要的。

在本教程中,我们首先从社会、法律、客户/终端用户和模型开发者的角度,强调在开发和部署大型语言模型和其他生成性AI模型时采用负责任的AI原则的必要性,作为更广泛的AI模型治理和负责任的AI框架的一部分,并为实践中的生成性AI的负责任AI提供了一个思考路线图。我们提供了文本和图像生成模型的简短技术概述,并突出了与这些模型相关的关键负责任的AI要求。接着,我们描述了实现上述要求的技术考虑因素和挑战。我们关注现实世界的生成性AI用例,涵盖了媒体生成、写作助手、文案撰写、代码生成和对话助手等领域,提供了有效应用负责任的AI技术的实用解决方案/指导原则,讨论了在实践中部署生成性AI应用的负责任AI方法的经验教训,并突出了关键的开放研究问题。我们希望我们的教程能够为研究者和实践者提供信息,刺激在生成性AI背景下进行更多关于负责任的AI的研究,并为将来建设更可靠和值得信赖的生成性AI应用铺平道路。

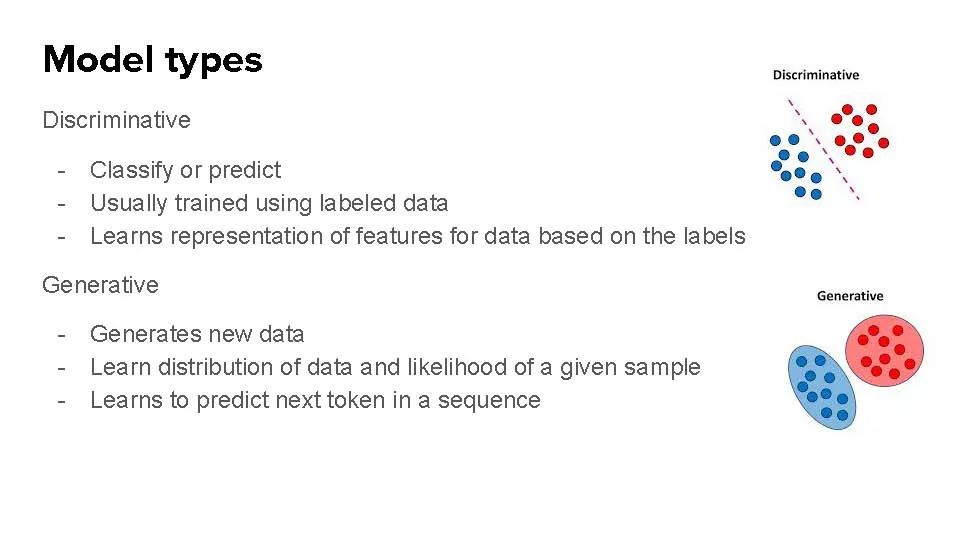

这个教程将分为两部分:(1)对生成式AI领域的技术深入探讨,包括进展、挑战和机会;(2)包括隐私、同意和负责任发布的伦理考量,以及减轻伤害和长期规划的方法。 生成式 AI 领域的介绍和概述 介绍 ML 中的生成式 AI 领域,并用一些问题激发话题。什么构成生成式 AI?为什么生成式 AI 是一个重要的话题?这个研究领域的起源是什么?

对文本生成模型和图像生成模型的技术深入探讨 (1)生成式 AI 模型的类型,它们之间的相似性和差异。 图像生成:Stable diffusion, Midjourney, Dall-E, Craiyon(前身为 Dall-E mini)、Imagen, CLIP 文本生成:GPT-4、BLOOM、InstructGPT、OPT 对话代理:ChatGPT、LaMDA、Sparrow、Claude、BlenderBot 3 代码生成:Codex、AlphaCode、CodeWhisperer 视频生成:Make-a-video 音频生成:AudioLM

(2)生成式 AI 的应用 - 图像、音乐、文本、代码、视频。

(3)模型训练:(a)预训练方法和数据集;(b)扩散方法;(c)有监督的微调;(d)指令数据集 - 自我指导、超自然指令;(e)与人类反馈的增强学习(RLHF);(f)计算成本和基础设施

(4)模型评估和审核包括:(a)指标、数据集和基准;(b)自动化 vs. 人工评估;(c)红队测试和对有害性/有毒性的评估。

(5)模型访问。

生成式 AI 的技术和伦理挑战 生成式 AI 有许多技术和伦理挑战,包括缺乏可解释性、偏见和歧视、隐私、模型的鲁棒性不足、假和误导内容、版权问题、内容审核工作者经历的心理伤害、剽窃和与生成式 AI 模型的训练和推理相关的环境影响。我们将突出以下挑战:

(1)信任和缺乏可解释性:对于 LLM 和其他生成式 AI 模型来说,这是一个重要的关注点,特别是由于它们的大尺寸和不透明的行为。这样的模型通常会显示出突现的行为,并展示出作为架构设计的一部分而未预期的能力,而这些能力也未被模型开发者预期。缺乏透明性、来源和可靠性使用户无法验证并引用由 LLM 提供的搜索和信息检索机制生成的响应。此外,LLM 和其他生成式 AI 模型可以用来生成假和误导的内容(包括深度伪造)并传播错误信息,这有严重的社会和政治后果。

(2)偏见和歧视:生成式 AI 模型通常是在大量的数据上进行训练的,这使得对训练数据进行不同类型偏见的审计变得困难。例如,已经显示出许多 LLM 有不同类型的偏见,如性别刻板印象、对残疾提及的不良偏见和宗教刻板印象。同样,像 Stable Diffusion 这样的对比性语言-视觉 AI 模型在自动收集的网页抓取数据上训练时,已经显示出学习到了性物化的偏见,这可以传播到下游应用。此外,生成式 AI 模型通常是在从互联网上爬取的数据上进行训练的,因此这些模型通常反映了最富有的社区和国家的做法。

(3)隐私和版权问题:已经显示,大型语言模型会记住训练数据中只出现一次的个人身份信息并复制这些数据,从而引发潜在的隐私问题。此外,像 DALL-E 2、Imagen 和 Stable Diffusion 这样的图像扩散模型已经显示出会记忆它们的训练数据中的个别图像,并在生成时发出它们,这有潜在的隐私和版权问题。

(4)模型的鲁棒性和安全性:大型语言模型通常没有提供不确定性估计的能力。如果没有对模型的信心(或不确定性)的知识,用户就很难决定何时可以信任模型的输出。模型安全性是生成式 AI 模型的一个关键关注点,尤其是当几个应用可能都是从同一个基础模型衍生出来的。已经显示,大型语言模型容易受到数据毒化攻击。

为缓解挑战提供的解决方案,并使用真实的使用案例和案例研究(包括在行业中的实际挑战和教训) 我们将讨论诸如水印、发布规范、红队测试和信心建设措施(CBMs)这样的解决方法,并呈现跨越不同公司、应用领域如金融服务、医疗、招聘、会话助手、在线零售、计算广告、搜索和推荐系统以及欺诈检测的案例研究。我们希望我们的教程可以告知研究人员和实践者,刺激进一步的关于生成式 AI 的负责任的 AI 方法的研究,并为将来建立更可靠的生成式 AI 模型和应用铺平道路。

这个教程是针对在学术界和工业界有着广泛兴趣和背景的参与者,包括那些对于生成式 AI 模型的负责任的 AI 技术和工具感兴趣的研究人员,以及对于各种生成式 AI 应用感兴趣的实践者。我们不会假设有任何先决知识,并通过建立直觉来介绍生成式 AI 的进展、挑战和机会,以确保材料对所有参与者都是易于访问的。

讲者:

Krishnaram Kenthapadi 是 Fiddler AI 的首席 AI 官和首席科学家,这是一家企业初创公司,构建了一个负责任的 AI 和 ML 监控平台。此前,他在 Amazon AWS AI 担任首席科学家,领导 Amazon AI 平台的公平性、可解释性、隐私和模型理解项目。在加入 Amazon 之前,他在 LinkedIn 的 AI 团队中领导了类似的工作,并在微软的 AI 和工程及研究伦理(AETHER)咨询委员会中代表 LinkedIn。之前,他是 Microsoft Research Silicon Valley Lab 的研究员。Krishnaram 于2006年从斯坦福大学获得计算机科学博士学位。他的工作在 NAACL、WWW、SODA、CIKM、ICML AutoML workshop 和 Microsoft 的 AI/ML 会议(MLADS)上获得了奖励。他发表了50多篇论文,有4500多次引用,并提交了150多个专利申请(已授权70项)。他在 KDD '18 '19、WSDM '19、WWW '19 '20 '21、FAccT '20 '21、AAAI '20 '21 和 ICML '21 等论坛上提供了关于隐私、公平、可解释 AI 和负责任 AI 的教程,并在斯坦福大学授课关于 AI 的课程。

Hima Lakkaraju 是哈佛大学的助理教授,专注于机器学习模型的可解释性、公平性和鲁棒性。她还与政策和医疗保健领域的各种专家合作,以了解可解释和公平的 ML 在现实世界中的影响。Hima 被 MIT Tech Review 和 Vanity Fair 两次评为世界35岁以下的顶级创新者之一。她的研究在 SIAM 国际数据挖掘会议(SDM)和 INFORMS 上获得了最佳论文奖,并从 NSF、Google、Amazon 和 Bayer 获得了资助。Hima 在包括 CIKM、ICML、NeurIPS、AAAI 和 CVPR 在内的各种顶级 ML 会议和研讨会上发表了主题演讲,她的研究也被 New York Times、MIT Tech Review、TIME 杂志和 Forbes 等热门媒体展示。最近,她共同创立了 Trustworthy ML Initiative,旨在简化对可信 ML 资源的访问,并构建一个致力于该主题的研究者/实践者社区。

Nazneen Rajani 是 Hugging Face 的研究负责人,这是一家以民主化 ML 为使命的初创公司,领导着鲁棒 ML 的研究方向。在 Hugging Face 之前,她在 Salesforce Research 与 Richard Socher 合作,并领导了一个研究团队,专注于基于大型语言模型(LLMs)构建鲁棒的自然语言生成系统。她从德克萨斯大学奥斯汀分校获得计算机科学博士学位,并是 LLMs 和可解释 ML 的专家。Nazneen 在 ACL、EMNLP、NAACL、NeurIPS 和 ICLR 上发表了50多篇论文,她的研究被 Quanta 杂志、VentureBeat、SiliconAngle、ZDNet 和 Datanami 等报道。她在 2022 年的 EMNLP 上进行了一个产业主题演讲,并在多个研究和产业论坛上发表了特邀演讲。

参考文献:

ACM Conference on Fairness, Accountability, and Transparency (ACM FAccT) * AAAI/ACM Conference on Artificial Intelligence, Ethics, and Society (AIES) * Symposium on Foundations of Responsible Computing (FORC) * Trustworthy ML Initiative * Sara Hajian, Francesco Bonchi, and Carlos Castillo, Algorithmic bias: From discrimination discovery to fairness-aware data mining, KDD Tutorial, 2016. * Solon Barocas and Moritz Hardt, Fairness in machine learning, NeurIPS Tutorial, 2017. * Kate Crawford, The Trouble with Bias, NeurIPS Keynote, 2017. * Arvind Narayanan, 21 fairness definitions and their politics, FAccT Tutorial, 2018. * Sam Corbett-Davies and Sharad Goel, Defining and Designing Fair Algorithms, Tutorials at EC 2018 and ICML 2018. * Ben Hutchinson and Margaret Mitchell, Translation Tutorial: A History of Quantitative Fairness in Testing, FAccT Tutorial, 2019. * Henriette Cramer, Kenneth Holstein, Jennifer Wortman Vaughan, Hal Daumé III, Miroslav Dudík, Hanna Wallach, Sravana Reddy, and Jean Garcia-Gathright, Translation Tutorial: Challenges of incorporating algorithmic fairness into industry practice, FAccT Tutorial, 2019. * Sarah Bird, Ben Hutchinson, Krishnaram Kenthapadi, Emre Kiciman, and Margaret Mitchell, Fairness-Aware Machine Learning: Practical Challenges and Lessons Learned, Tutorials at WSDM 2019, WWW 2019, and KDD 2019. * Krishna Gade, Sahin Cem Geyik, Krishnaram Kenthapadi, Varun Mithal, and Ankur Taly, Explainable AI in Industry, Tutorials at KDD 2019, FAccT 2020, and WWW 2020. * Freddy Lecue, Krishna Gade, Fosca Giannotti, Sahin Geyik, Riccardo Guidotti, Krishnaram Kenthapadi, Pasquale Minervini, Varun Mithal, and Ankur Taly, Explainable AI: Foundations, Industrial Applications, Practical Challenges, and Lessons Learned, AAAI 2020 Tutorial. * Himabindu Lakkaraju, Julius Adebayo, and Sameer Singh, Explaining Machine Learning Predictions: State-of-the-art, Challenges, and Opportunities, Tutorials at NeurIPS 2020 and AAAI 2021.