第37届国际人工智能大会(AAAI2023)于2023年2月7日-2月14日在美国华盛顿召开。AAAI是CCF推荐的A类国际学术会议,在人工智能领域享有很高的学术声誉。这次会议共收到来自8777篇投稿,录用1721篇,录用率约19.6%。来自Google等学者带来了《Transformer》教程,非常值得关注!

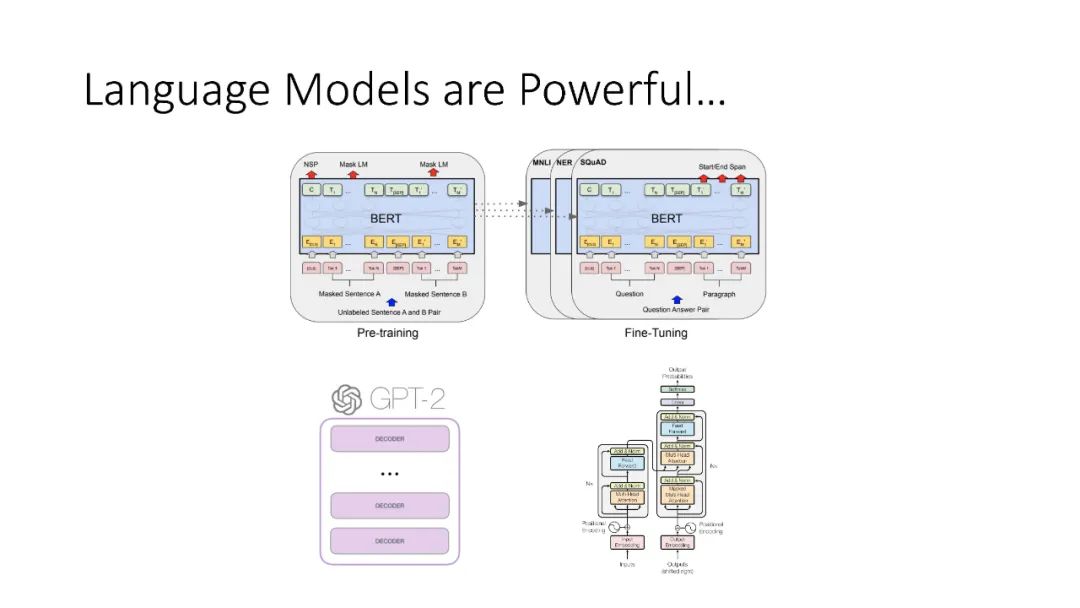

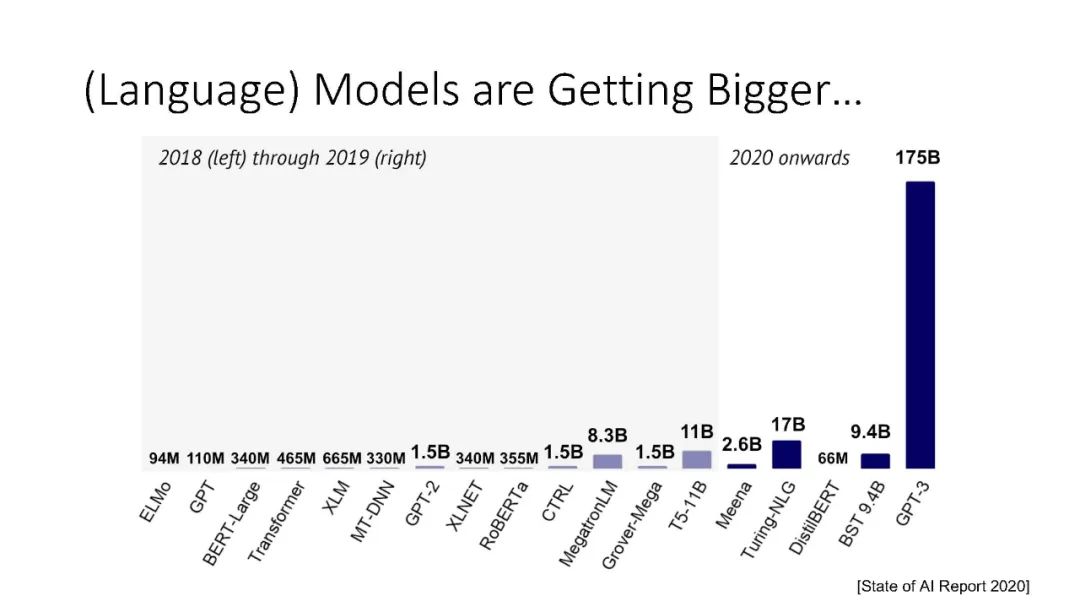

**本教程旨在从Transformer架构的角度,分享统一神经架构的令人兴奋的最新进展,这些架构可以处理不同的输入模态,并学习解决不同的任务。**其目标是让与会者“了解关于Transformers的一切”。本教程涵盖了基本架构及其最新变体(Neil Houlsby),有效的优化算法(Boqing Gong),多模态学习和机器人领域代表性和新兴的新应用(Chen Sun, Andy Zeng),以及探索和分析训练网络捕获了什么知识的工具(Ellie Pavlick)。

我们设想Transformer成功的基本原则是通用的,该教程将有益于广泛的人工智能研究人员和从业人员。最后,本教程将讨论现有基于transformer方法的局限性,并强调一些未来的研究方向。 我们希望参与者对机器学习和深度学习有基本的了解,包括常用的神经架构和学习方法。计算机视觉、语言理解或机器人研究或应用的实践经验是有帮助的,但不是必需的。

https://transformer-tutorial.github.io/aaai2023/

讲者:

Andy Zeng

Andy Zeng是谷歌的研究科学家。他的研究重点是机器人学习——使机器能够智能地与世界互动,并随着时间的推移自我改进。如今,他感兴趣的是机器人如何从互联网规模的数据中受益。

Boqing Gong是西雅图谷歌的研究科学家。他在机器学习和计算机视觉方面的研究重点是视觉模型的泛化和效率。在2019年加入谷歌之前,他在腾讯工作,并是中佛罗里达大学的终身职位助理教授。

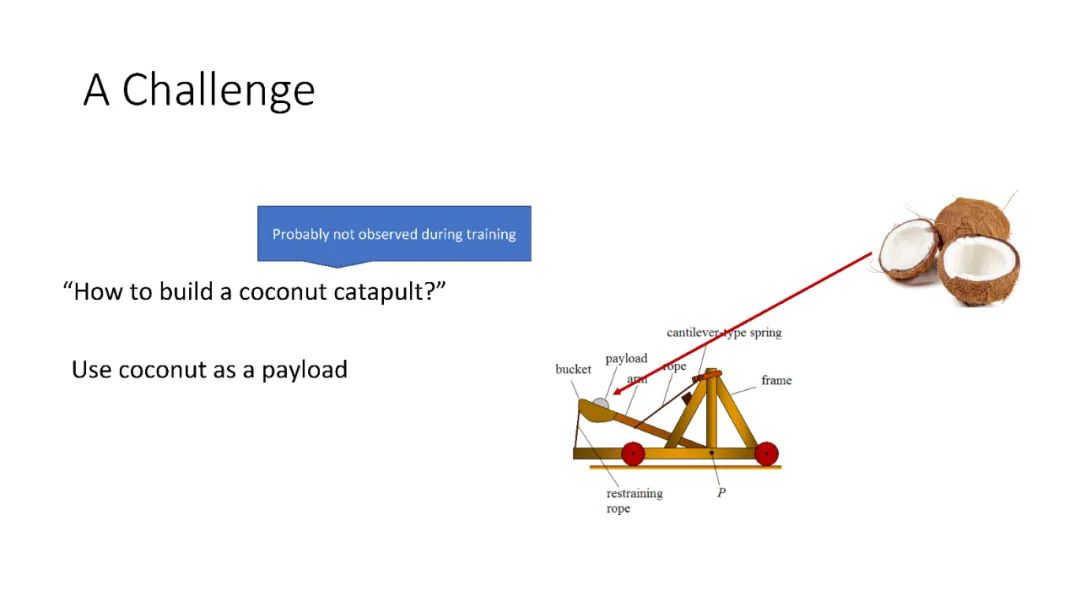

Chen Sun是布朗大学计算机科学助理教授,谷歌的研究科学家。他正在进行的研究项目涉及从无标签视频中学习多模态表示和视觉常识,以识别人类活动、物体及其随时间的交互,并将表示转移到具身智能体。2016年获得南加州大学博士学位,2011年获得清华大学学士学位。

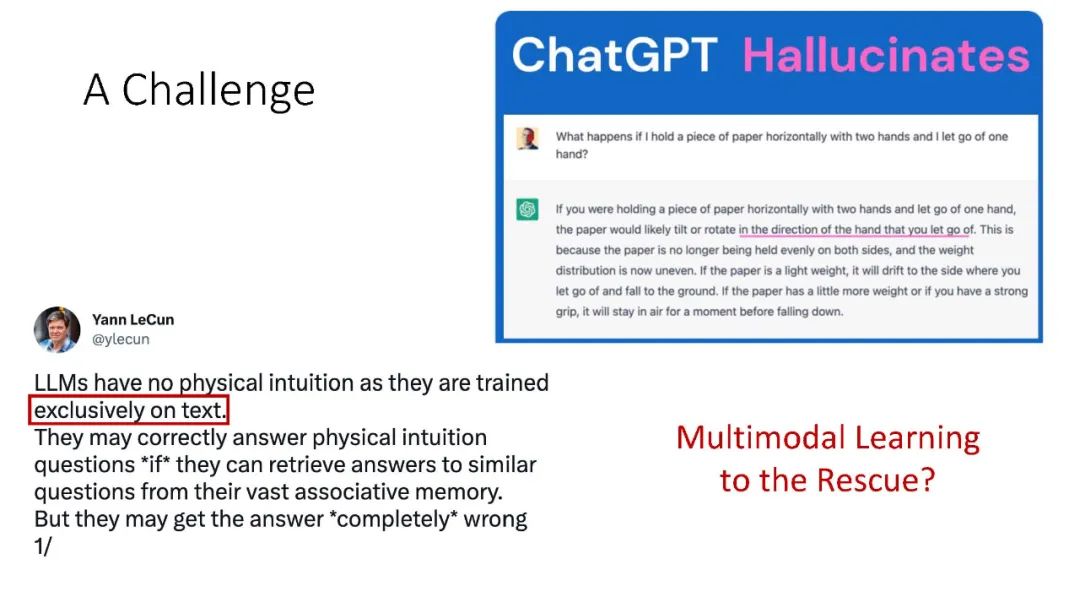

Ellie Pavlick是布朗大学计算机科学助理教授,领导语言理解和表示(LUNAR)实验室,同时也是谷歌的研究科学家。她的研究重点是建立语言的计算模型,这些模型的灵感来自人类的语言处理和/或信息。目前,她的实验室正在研究神经网络的内部工作原理,以“逆向工程”这些模型使用的概念结构和推理策略,以及探索接地(非语言)信号在单词和概念学习中的作用。

尼尔·霍尔斯比(Neil Houlsby)是谷歌研究公司Brain team网站Zürich的研究科学家。Neil对机器学习和人工智能有广泛的兴趣,尤其关注可扩展的视觉模型,自然语言处理和迁移学习。在加入谷歌之前,Neil在剑桥大学从事贝叶斯机器学习工作。