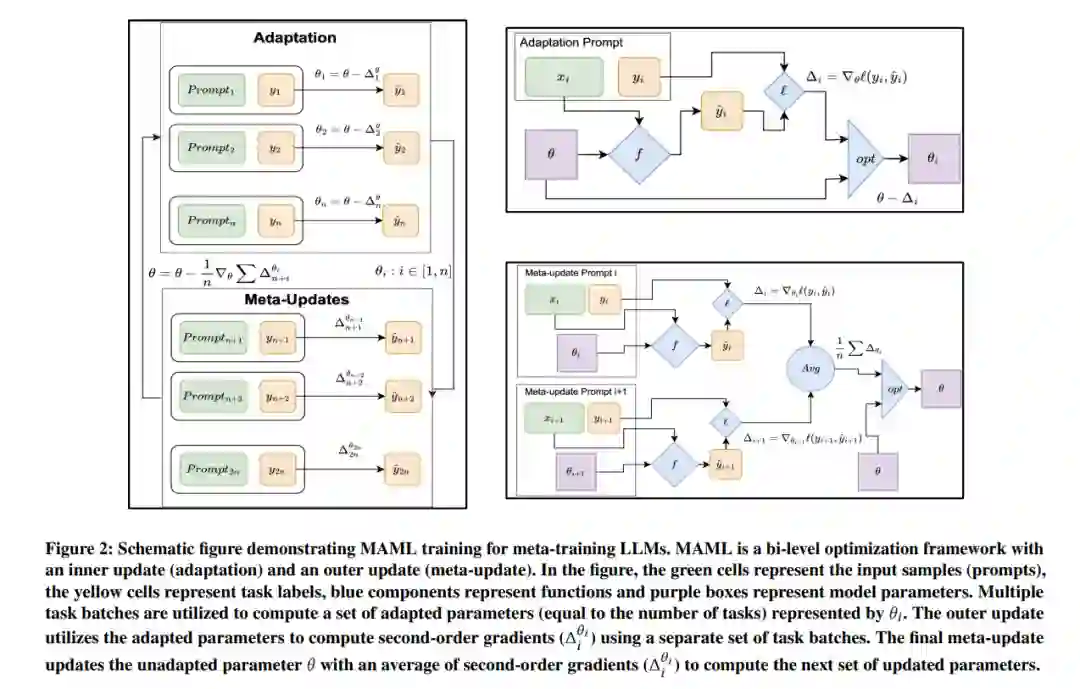

将大型语言模型(LLMs)适应未见任务,并利用上下文训练样本而无需微调,仍然是一个重要的研究问题。为了学习能够很好地适应未见任务的鲁棒LLM,已经提出了多种元训练方法,例如MetaICL和MetaICT,它们涉及在各种不同任务上对预训练的LLMs进行元训练。这些元训练方法本质上执行了上下文多任务微调,并在不相交的测试任务集上进行评估。尽管它们取得了令人印象深刻的性能,但其目标从来不是计算出真正通用的一组参数。在本文中,我们提出了一种新的LLM元训练方法——MAML-en-LLM,它能够学习真正可泛化的参数,不仅在不相交的任务上表现出色,还能适应未见任务。我们观察到在未见领域上性能平均提高了2%,而在适应性能上则大幅提高了4%。此外,我们证明了MAML-en-LLM在训练数据量有限的情况下,在已见和未见领域上均优于基线方法,平均提升了2%。最后,我们讨论了任务类型、优化器和任务复杂性的影响,这是元训练文献中几乎未被探索的领域。在7种任务设置和两种数据设置下进行的详尽实验表明,使用MAML-en-LLM训练的模型在性能上优于现有的元训练方法。

成为VIP会员查看完整内容

相关内容

Arxiv

42+阅读 · 2023年4月19日

Arxiv

224+阅读 · 2023年4月7日