【AAAI2021】知识图谱增强的预训练模型的生成式常识推理

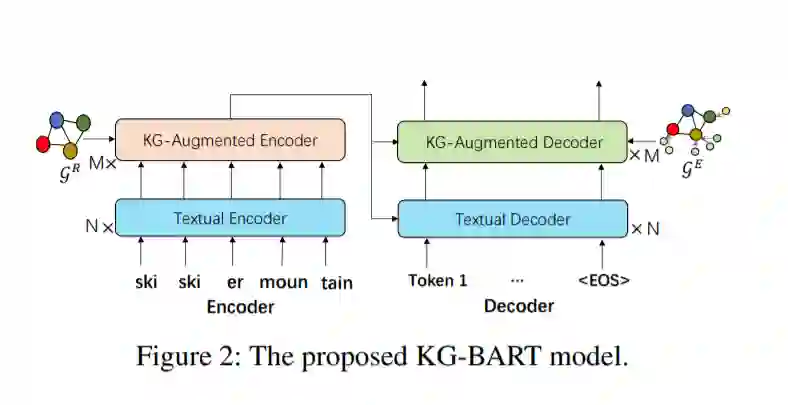

生成式常识推理是文本生成的一个关键瓶颈,它旨在使机器能够根据一组概念生成具有推理能力的句子。即使是最先进的预训练语言生成模型也难以完成这一任务,而且常常产生不合逻辑和异常的句子。其中一个原因是,他们很少考虑将知识图谱整合进来,因为知识图谱可以在常识概念之间提供丰富的关系信息。为了提高常识性推理生成文本的能力,我们提出了一种新的知识图谱增强的预训练语言生成模型KG-BART,该模型通过知识图谱包含了复杂的概念关系,并生成了更符合逻辑和自然的句子作为输出。此外,KG-BART可以利用图上的注意力来聚集丰富的概念语义,从而增强对看不见的概念集的模型泛化。在基准commonen数据集上进行的实验验证了本文方法的有效性,并与几个强的预训练语言生成模型进行了比较,特别是在BLEU - 3,4方面,KG-BART的性能比BART高出5.80、4.60。此外,我们还表明,通过我们的模型生成的上下文可以作为背景场景,从而有利于下游的常识性QA任务。

https://www.zhuanzhi.ai/paper/5478cc149a0d6a523665d68c6d3c170a

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“KGBART” 可以获取《【AAAI2021】知识图谱增强的预训练模型的生成式常识推理》专知下载链接索引

登录查看更多

相关内容

Arxiv

5+阅读 · 2019年5月20日