【KDD2020】XGNN-可解释图神经网络,从模型级解释构建可信赖GNN

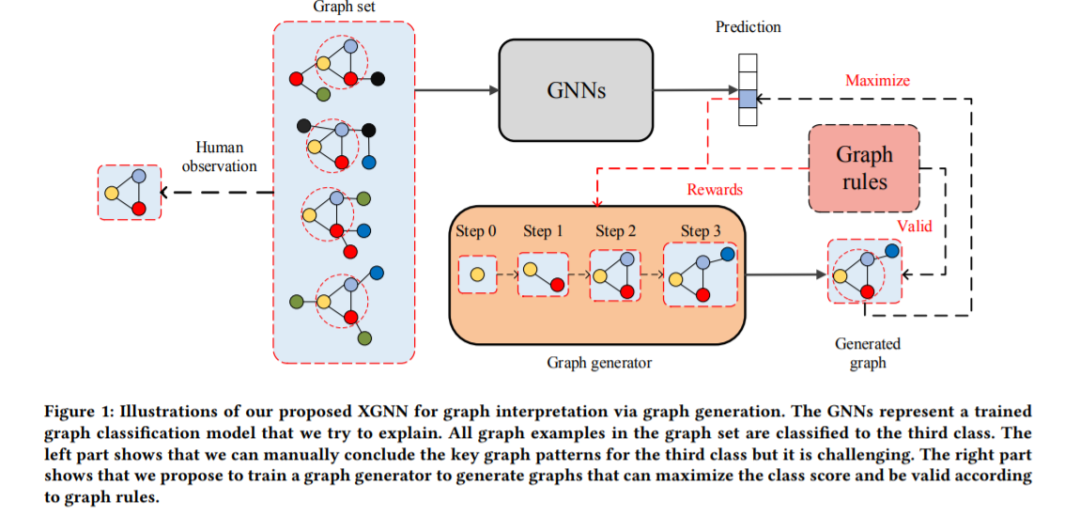

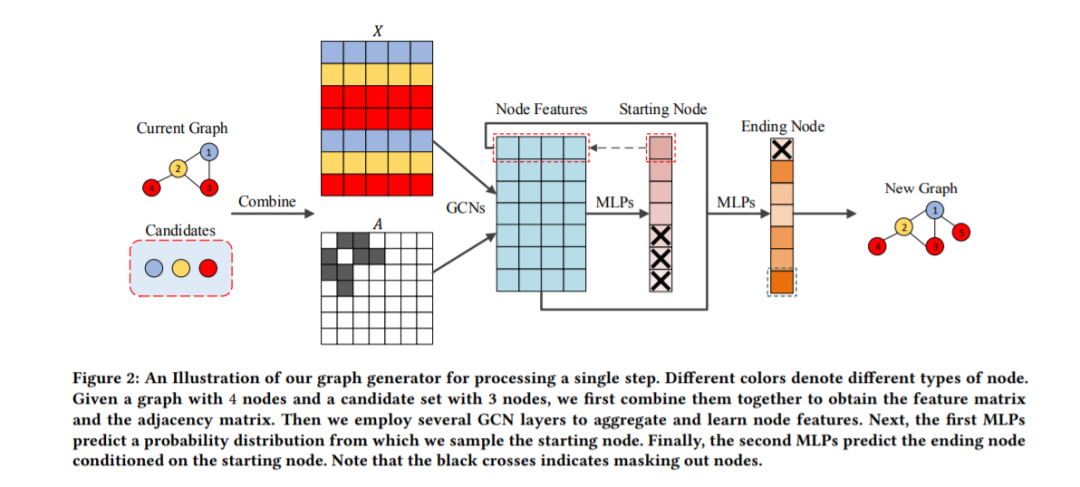

图神经网络通过聚合和结合邻居信息来学习节点特征,在许多图的任务中取得了良好的性能。然而,GNN大多被视为黑盒,缺乏人类可理解的解释。因此,如果不能解释GNN模型,就不能完全信任它们并在某些应用程序域中使用它们。在这项工作中,我们提出了一种新的方法,称为XGNN,在模型级别上解释GNN。我们的方法可以为GNNs的工作方式提供高层次的见解和一般性的理解。特别地,我们提出通过训练一个图生成器来解释GNN,使生成的图模式最大化模型的某种预测。我们将图形生成表述为一个强化学习任务,其中对于每一步,图形生成器预测如何向当前图形中添加一条边。基于训练后的GNN信息,采用策略梯度方法对图生成器进行训练。此外,我们还加入了一些图规则,以促使生成的图是有效的。在合成和真实数据集上的实验结果表明,我们提出的方法有助于理解和验证训练过的GNN。此外,我们的实验结果表明,所生成的图可以为如何改进训练的神经网络提供指导。

概述

图神经网络(GNNs)在不同的图任务(如节点分类[11,37]、图分类[39,47]和链接预测[46])上显示了其有效性并取得了最新的性能。此外,对不同的图运算进行了大量的研究,如图卷积[13,16,19]、图池化[20,44]、图注意力[10,36,37]。由于图数据广泛存在于不同的真实世界应用程序中,如社交网络、化学和生物学,GNN变得越来越重要和有用。尽管它们的性能很好,GNNs也有和其他深度学习模型一样的缺点;也就是说,它们通常被视为黑盒子,缺乏人类理解的解释。如果不理解和验证内部工作机制,就不能完全信任GNNs,这就阻碍了它们在涉及公平、隐私和安全的关键应用程序中的使用[7,40]。例如,我们可以训练一个GNN模型来预测药物的效果,我们将每种药物视为一个分子图。如果不探索其工作机理,我们就不知道分子图中是什么化学基团导致了这些预测。那么我们就无法验证GNN模型的规则是否与真实世界的化学规则一致,因此我们不能完全信任GNN模型。这就增加了开发GNN解释技术的需要。

最近,人们提出了几种解释技术来解释图像和文本数据的深度学习模型。根据所提供的解释的类型,现有的技术可以归类为实例级[5,9,29,31,32,43,45,48]或模型级[8,24,25]方法。实例级解释通过模型确定输入中的重要特征或该输入的决策过程来解释对给定输入示例的预测。这类常用技术包括基于梯度的方法[31,32,43]、中间特征图可视化[29,48]和基于遮挡的方法[5,9,45]。与提供依赖于输入的解释不同,模型级别的解释旨在通过研究哪些输入模式可以导致某种预测来解释模型的一般行为,而不考虑任何特定的输入示例。输入优化[8,24 - 26]是最常用的模型级解释方法。这两类解释方法旨在从不同的角度解释深层模型。由于解释的最终目的是验证和理解深度模型,我们需要手动检查解释结果,并得出深度模型是否按我们预期的方式工作的结论。对于示例级方法,我们可能需要探究大量示例的解释,然后才能相信模型。然而,这需要时间和专家的广泛努力。对于模型级方法,其解释更加普遍和高级,因此需要较少的人力监督。然而,与实例级的解释相比,模型级方法的解释不那么精确。总的来说,模型级和实例级方法对于解释和理解深度模型都很重要。

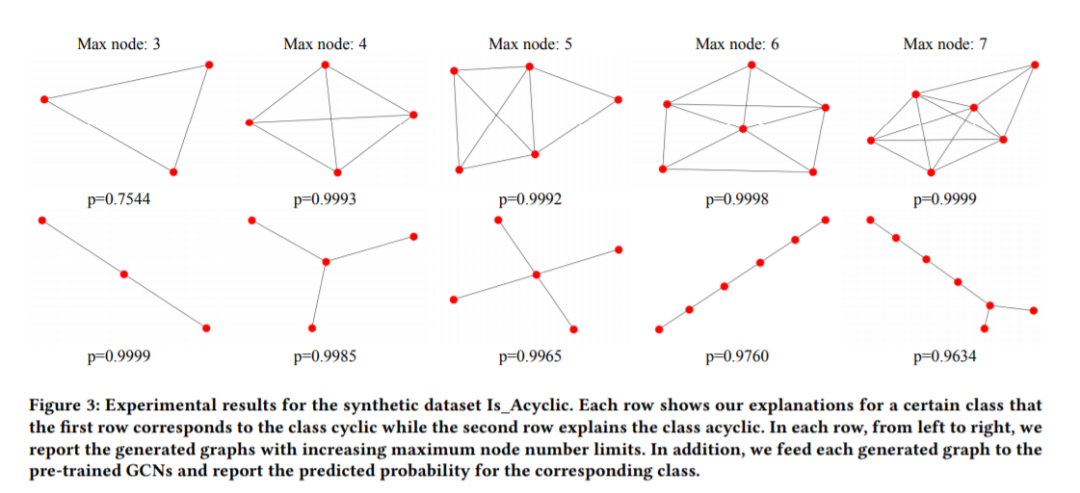

在图数据上解释深度学习模型变得越来越重要,但仍缺乏探索。就我们所知,目前还没有在模型级解释GNN的研究。现有研究[4,40]仅对图模型提供了实例层次的解释。作为对现有工作的彻底背离,我们提出了一种新的解释技术,称为XGNN,用于在模型级别上解释深层图模型。我们提出研究什么样的图模式可以最大化某个预测。具体地说,我们提出训练一个图生成器,以便生成的图模式可以用来解释深度图模型。我们把它表示为一个强化学习问题,在每一步,图生成器预测如何添加一条边到给定的图和形成一个新的图。然后根据已训练图模型的反馈,使用策略梯度[35]对生成器进行训练。我们还加入了一些图规则,以鼓励生成的图是有效的。注意,XGNN框架中的图生成部分可以推广到任何合适的图生成方法,这些方法由手边的数据集和要解释的GNN决定。最后,我们在真实数据集和合成数据集上训练了GNN模型,取得了良好的性能。然后我们使用我们提出的XGNN来解释这些训练过的模型。实验结果表明,我们提出的XGNN可以找到所需的图模式,并解释了这些模型。通过生成的图形模式,我们可以验证、理解甚至改进经过训练的GNN模型。

https://arxiv.org/abs/2006.02587

图神经网络近年来得到了广泛的研究,并在多图任务处理中表现出了良好的性能。然而,图模型仍然被视为黑盒,因此不能完全信任。提出了研究图形神经网络解释技术的必要性。它仍然是一个较少探索的领域,现有的方法只关注于图形模型的实例级解释。然而,现有的工作中没有一个研究更普遍和高层次的图模型的模型级解释。因此,在本文中,我们提出了一种新的方法XGNN,在模型层次上解释图模型。具体地说,我们提出通过图的生成来寻找能够最大化某种预测的图模式。我们将其表示为一个强化学习问题,并迭代生成图模式。我们训练一个图形生成器,对于每一步,它预测如何向当前图中添加一条边。此外,我们加入了一些图规则,以鼓励生成的图是有效的和可理解的。最后,我们在合成数据集和真实数据集上进行了实验,以证明我们提出的XGNN的有效性。实验结果表明,生成的图有助于发现哪些模式可以最大限度地预测训练后的神经网络。生成的解释有助于验证和更好地理解经过训练的GNN是否能以我们预期的方式做出预测。此外,我们的结果还表明,所产生的解释有助于改进训练的模型。

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“XGNN” 可以获取《XGNN-可解释图神经网络,从模型级解释构建可信赖GNN》专知下载链接索引