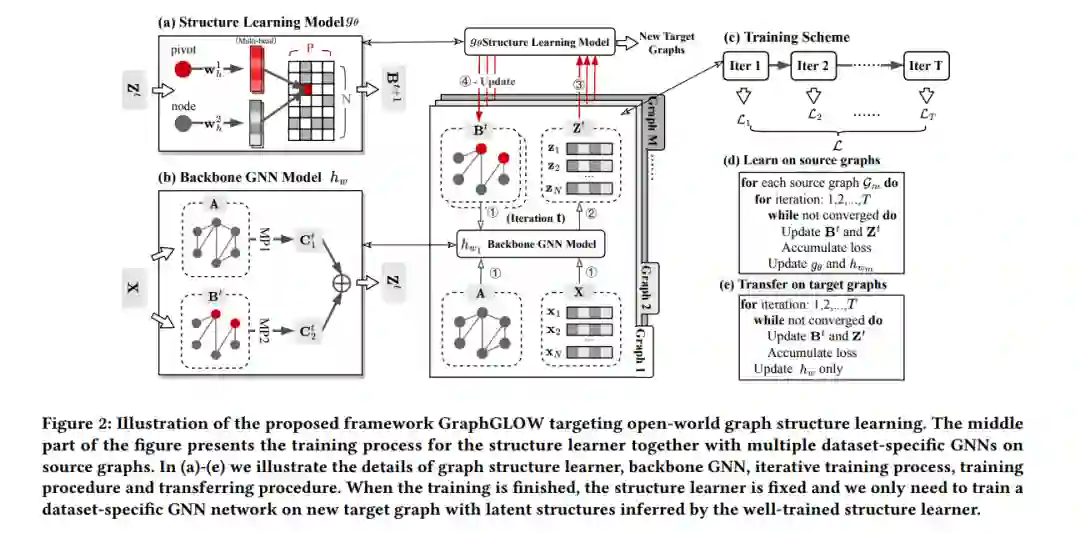

图结构学习是一个成熟的问题,旨在优化适应特定图数据集的图结构,以帮助消息传递神经网络(即GNN)产生有效且鲁棒的节点嵌入。然而,现有模型的普遍限制在于基本的封闭世界假设:测试图与训练图相同。这个前提要求对每个图数据集独立从头开始训练结构学习模型,导致计算成本过高,并可能出现严重的过拟合风险。为了缓解这些问题,本文探索了一个新的方向,即学习一个通用的结构学习模型,可以在开放世界中推广到各种图数据集。我们首先介绍这个新颖问题设置的数学定义,并从概率数据生成的角度描述模型的构建。然后,我们设计了一个通用框架,协调一个图共享的结构学习器和多个图特定的GNN,以捕捉跨数据集的可推广的最佳消息传递拓扑模式。经过良好训练的结构学习器可以直接为未见过的目标图生成适应性结构,而无需任何微调。在不同的数据集和各种具有挑战性的跨图泛化协议中,我们的实验证明,即使在目标图上没有进行训练,所提出的模型:i)显著优于在输入(非优化)拓扑上训练的表达能力强大的GNN;ii)令人惊讶地与独立优化特定目标图的最先进模型表现相当,并且在目标图上训练的速度明显加快了几个数量级。 https://arxiv.org/abs/2306.11264

成为VIP会员查看完整内容

相关内容

Arxiv

42+阅读 · 2023年4月19日

Arxiv

225+阅读 · 2023年4月7日