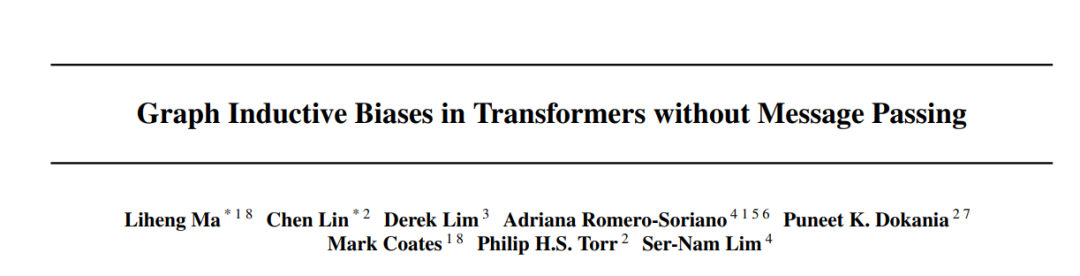

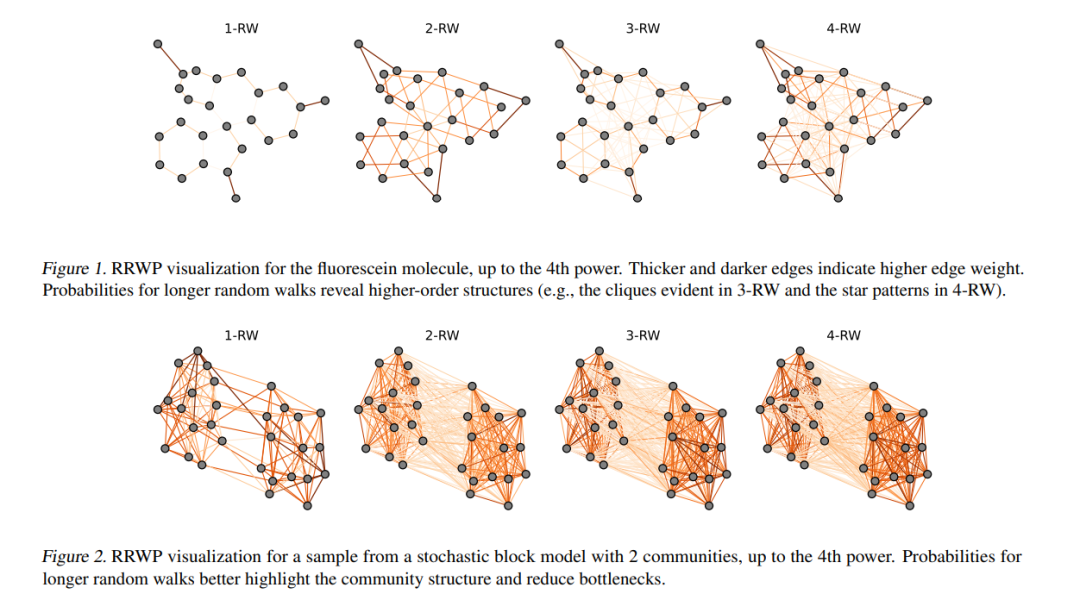

针对图数据的Transformer正在被越来越广泛地研究,并在许多学习任务中取得成功。图归纳偏差对于Graph Transformers至关重要,之前的工作通过使用信息传递模块和/或位置编码来加入这些偏差。然而,使用信息传递的Graph Transformers继承了信息传递的已知问题,并且与在其他领域中使用的Transformers显著不同,这使得研究进展的迁移变得更加困难。另一方面,没有使用信息传递的Graph Transformers在较小的数据集上的表现通常较差,在这种情况下,归纳偏差更为重要。为了弥合这个鸿沟,我们提出了Graph Inductive bias Transformer(GRIT)—一种新的Graph Transformer,它在不使用信息传递的情况下融合了图归纳偏差。GRIT基于几个从理论和实证上都得到证明的架构变化,包括:使用随机游走概率初始化的学习相对位置编码,一种可以更新节点和节点对表示的灵活的注意力机制,以及在每一层注入度信息。我们证明GRIT是有表现力的——它可以表示最短路径距离和各种图传播矩阵。GRIT在各种图数据集中实现了最新的实证性能,这显示了不使用信息传递的Graph Transformers所能够带来的强大能力。

成为VIP会员查看完整内容