【NeurIPS 2022】带有自适应节点采样的层次图Transformer

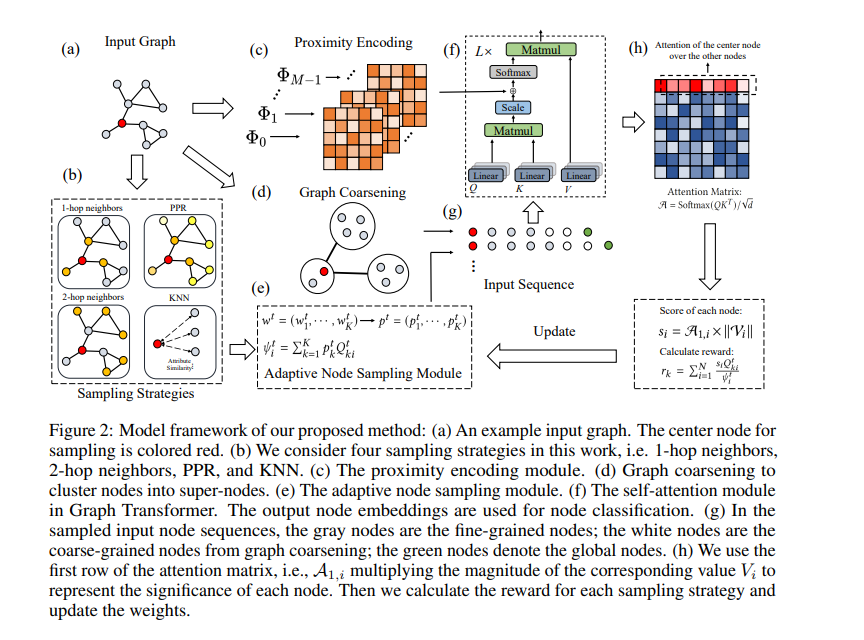

Transformer体系结构在包括自然语言处理和计算机视觉在内的许多领域都取得了显著的成功。然而,当涉及到图结构数据时,transformer没有取得具有竞争力的性能,特别是在大型图上。本文指出了当前图transformer的主要不足:(1)图transformer中现有的节点采样策略与图特征和训练过程无关。(2)大多数抽样策略只关注局部邻域,而忽略了图中的长期依赖关系。我们对合成数据集进行了实验研究,表明现有的采样策略是次优的。为了解决上述问题,我们将Graph Transformer中的节点抽样优化策略制定为对手强盗问题,其中奖励与注意力权重相关,并可以在训练过程中变化。同时,我们提出了一种具有图粗化的分层注意力方案,以捕获远程交互,同时降低计算复杂度。最后,我们在真实数据集上进行了大量的实验,以证明我们的方法优于现有的图Transformer和流行的GNN。我们的代码是开源的,网址是https://github.com/zaixizhang/ANS-GT。

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“HGTS” 就可以获取《【NeurIPS 2022】带有自适应节点采样的层次图Transformer》专知下载链接

登录查看更多

相关内容

Arxiv

12+阅读 · 2021年12月30日