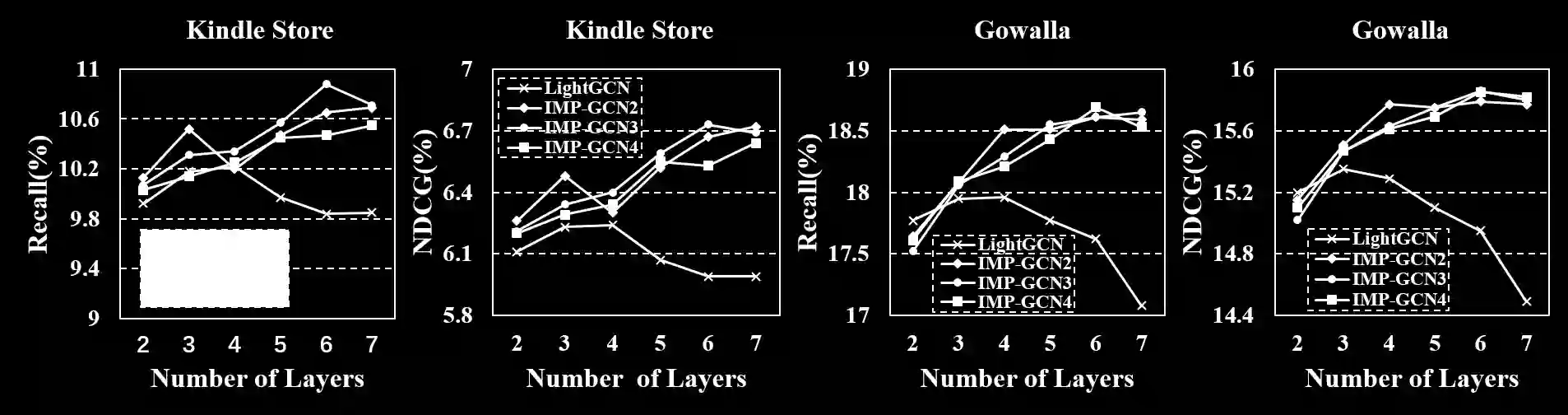

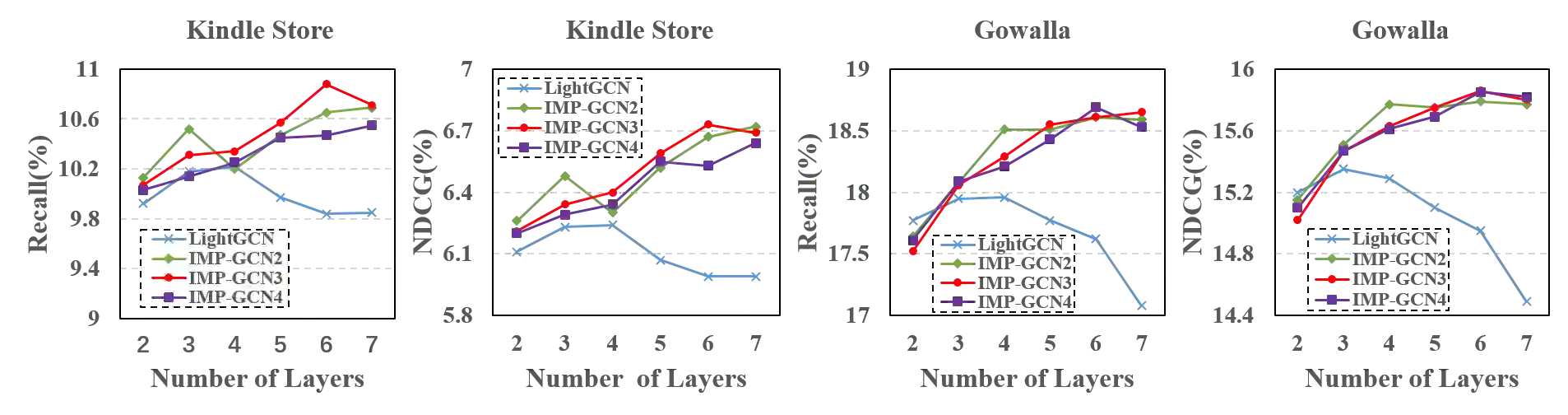

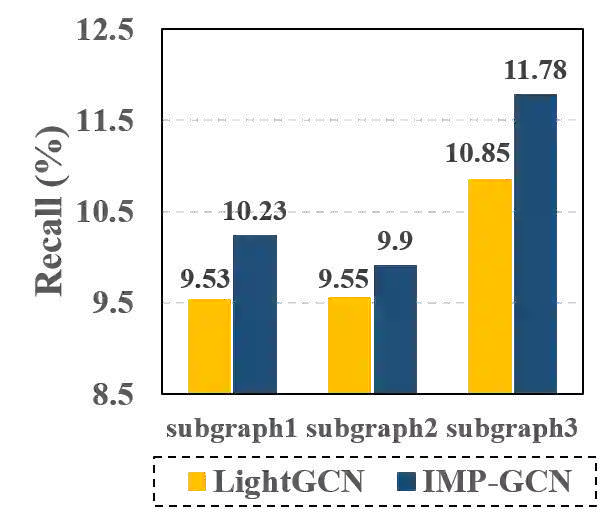

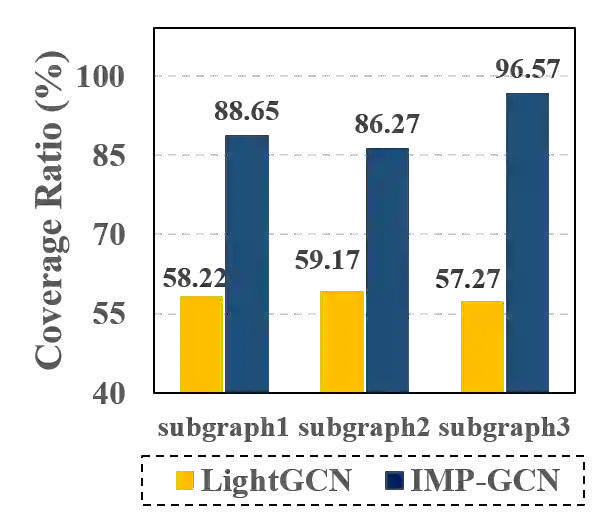

Graph Convolution Networks (GCNs) manifest great potential in recommendation. This is attributed to their capability on learning good user and item embeddings by exploiting the collaborative signals from the high-order neighbors. Like other GCN models, the GCN based recommendation models also suffer from the notorious over-smoothing problem - when stacking more layers, node embeddings become more similar and eventually indistinguishable, resulted in performance degradation. The recently proposed LightGCN and LR-GCN alleviate this problem to some extent, however, we argue that they overlook an important factor for the over-smoothing problem in recommendation, that is, high-order neighboring users with no common interests of a user can be also involved in the user's embedding learning in the graph convolution operation. As a result, the multi-layer graph convolution will make users with dissimilar interests have similar embeddings. In this paper, we propose a novel Interest-aware Message-Passing GCN (IMP-GCN) recommendation model, which performs high-order graph convolution inside subgraphs. The subgraph consists of users with similar interests and their interacted items. To form the subgraphs, we design an unsupervised subgraph generation module, which can effectively identify users with common interests by exploiting both user feature and graph structure. To this end, our model can avoid propagating negative information from high-order neighbors into embedding learning. Experimental results on three large-scale benchmark datasets show that our model can gain performance improvement by stacking more layers and outperform the state-of-the-art GCN-based recommendation models significantly.

翻译:图表变迁网络(GCNs)在建议中显示出巨大的潜力。 这是因为他们通过利用高端邻居的协作信号学习好用户和项目嵌入的能力。 与其他GCN模型一样, GCN 基础建议模型也存在臭名昭著的过度移动问题 — — 当堆叠更多层时, 节点嵌入会变得更加相似, 最终无法分化, 导致性能退化。 最近提议的 LightGCN 和 LR-GCN 在某种程度上缓解了这一问题。 但是, 我们争辩说, 他们忽略了建议中过度移动问题的一个重要因素, 也就是说, 高端邻居用户没有共同利益的用户也可以参与用户嵌入图变动操作中的学习。 结果, 多层图嵌嵌入会让不同兴趣的用户有相似的嵌入功能。 在本文中, 我们提出一个新的关注模型, 以GCN (IMP-GCN) 状态建议, 用于在子图中进行高端变换, 即高端的用户和高端变换数据结构。 子图中, 与共同的用户展示了类似的利益, 演示的生成模型的分级模型, 能够将用户的分解。