图神经网络(GNN)已经成为图表示学习的事实标准,它通过递归地聚集图邻域的信息来获得有效的节点表示。尽管 GNN 可以从头开始训练,但近来一些研究表明:对 GNN 进行预训练以学习可用于下游任务的可迁移知识能够提升 SOTA 性能。但是,传统的 GNN 预训练方法遵循以下两个步骤:

在大量未标注数据上进行预训练; 在下游标注数据上进行模型微调。 由于这两个步骤的优化目标不同,因此二者存在很大的差距。

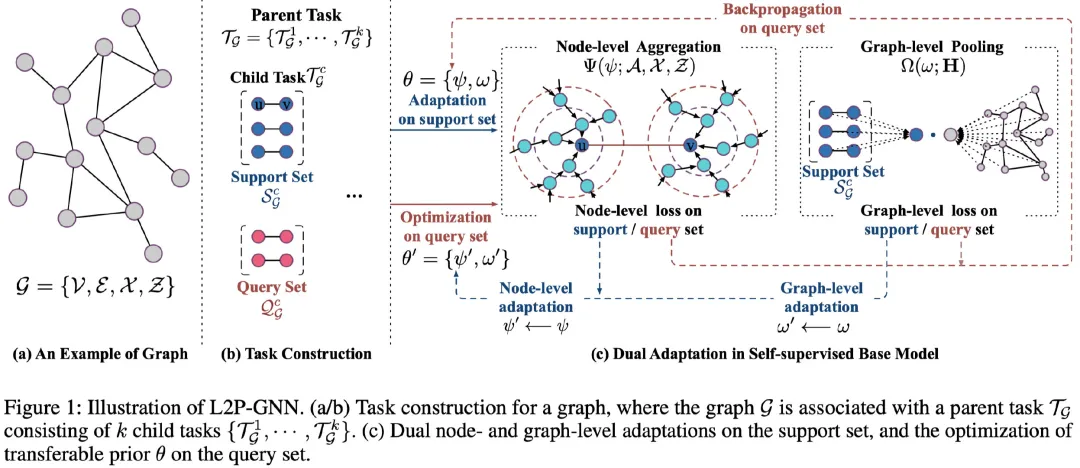

在本文中,我们分析了预训练和微调之间的差异,并为了缓解这种分歧,我们提出了一种用于GNNs的自监督预训练策略L2P-GNN。方法的关键是L2P-GNN试图以可转移的先验知识的形式学习如何在预训练过程中进行微调。为了将局部信息和全局信息都编码到先验信息中,我们在节点级和图级设计了一种双重自适应机制。最后,我们对不同GNN模型的预训练进行了系统的实证研究,使用了一个蛋白质数据集和一个文献引用数据集进行了预训练。实验结果表明,L2P-GNN能够学习有效且可转移的先验知识,为后续任务提供好的表示信息。我们在https://github.com/rootlu/L2P-GNN公开了模型代码,同时开源了一个大规模图数据集,可用于GNN预训练或图分类等。

总体来说,本文的贡献如下:

- 首次探索学习预训练 GNNs,缓解了预训练与微调目标之间的差异,并为预训练 GNN 提供了新的研究思路。

- 针对节点与图级表示,该研究提出完全自监督的 GNN 预训练策略。

- 针对预训练 GNN,该研究建立了一个新型大规模书目图数据,并且在两个不同领域的数据集上进行了大量实验。实验表明,该研究提出的方法显著优于 SOTA 方法。

成为VIP会员查看完整内容

相关内容

专知会员服务

99+阅读 · 2020年7月3日

Arxiv

9+阅读 · 2020年8月31日