Mamba 正在成为克服卷积神经网络(CNNs)和视觉Transformers(ViTs)在计算机视觉中面临的挑战的新方法。虽然 CNNs 在提取局部特征方面表现出色,但它们往往难以在不进行复杂架构修改的情况下捕捉长程依赖关系。相较之下,ViTs 能够有效建模全局关系,但由于自注意机制的平方复杂度,导致计算成本较高。Mamba 通过利用选择性结构化状态空间模型,有效地以线性计算复杂度捕捉长程依赖,解决了这些局限性。本文综述分析了 Mamba 模型的独特贡献、计算优势和应用,同时识别了挑战和潜在的未来研究方向。我们提供了一个基础资源,以促进对 Mamba 模型在计算机视觉中理解和发展的深入研究。本研究的概览可访问 https://github.com/maklachur/Mamba-in-Computer-Vision。

1 引言

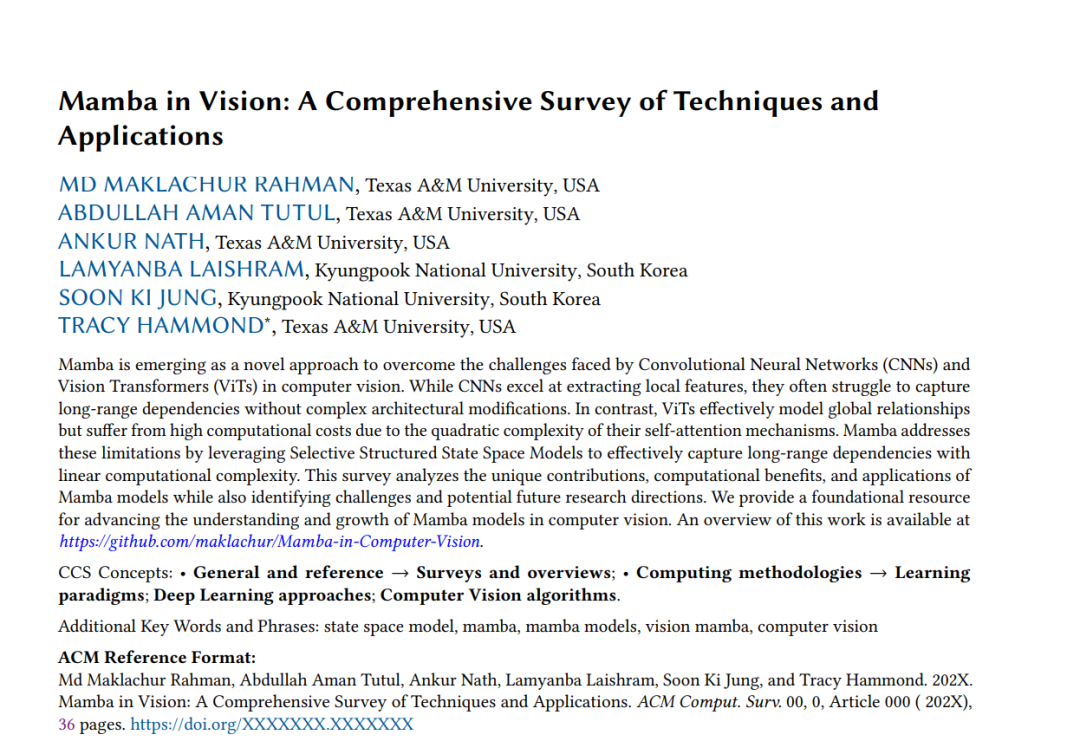

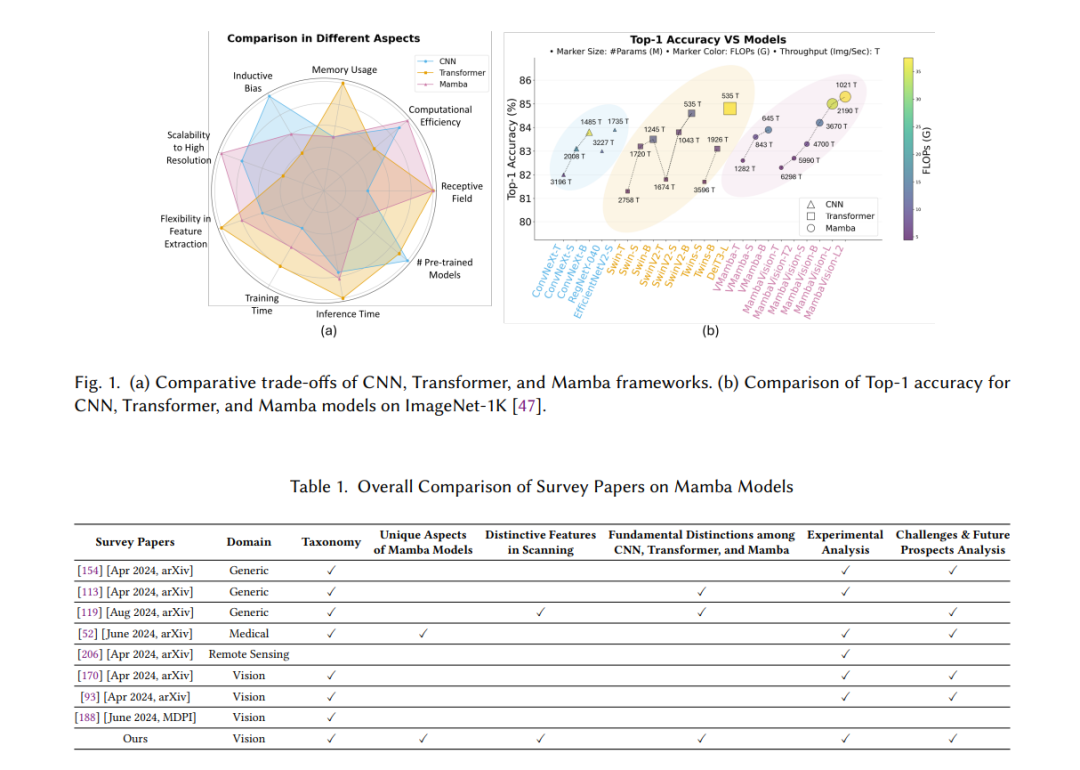

深度学习的发展极大地推动了计算机视觉领域的发展,其中卷积神经网络(CNNs) [69] 发挥了关键作用。CNNs 通过卷积层从像素数据中直接学习复杂模式,捕获多尺度特征并构建空间层次结构,从而彻底改变了这一领域。尽管取得了显著的成功,但由于其局部感受野的限制,CNNs 在捕捉长程依赖关系方面存在固有挑战。解决这些挑战通常需要更深、更复杂的架构,这会增加计算成本并降低效率 [49, 121, 137]。为了改进序列建模和全局上下文理解,最初开发了循环神经网络(RNNs) [126],随后引入了 Transformer [142],为深度学习带来了显著突破。RNNs,特别是那些采用长短期记忆单元(LSTM) [53] 的 RNNs,提升了在序列数据中捕捉时间依赖关系的能力。然而,由于其顺序特性,限制了并行处理能力,降低了速度和可扩展性 [22, 53]。Transformer 借助其自注意力机制克服了这一限制,使模型能够动态优先处理输入数据的不同部分 [142]。视觉 Transformer(ViTs)被开发用于图像处理,将图像视为补丁的序列,相比 CNNs 更有效地捕获全局依赖关系 [25, 68, 120]。然而,尽管在各种计算机视觉任务中表现出色,由于自注意力机制的平方复杂度,ViTs 在高分辨率和实时应用中面临计算效率挑战 [120]。为了解决传统架构的局限性,混合模型通过整合 CNNs、RNNs 和 Transformers 的优点来应对计算机视觉任务。例如,卷积 LSTM(ConvLSTMs) [133] 通过在 LSTM 单元内整合卷积操作,增强了模型捕捉时空关系的能力 [133]。类似地,MobileViT 结合了 CNNs 的局部特征提取与 Transformers 的全局上下文建模 [106]。混合架构旨在平衡高性能和计算效率,但由于组件优化的需求,增加了复杂性。最近,状态空间模型(SSMs)因其在序列数据处理方面的潜力而备受关注,尤其是在有效管理长程依赖关系至关重要的情况下 [38-40]。结构化状态空间序列(S4)模型是该领域的一项显著发展,它利用状态空间表示来实现线性计算复杂度。因此,可以高效地处理长序列而不会牺牲准确性 [39]。S4 模型通过整合循环和卷积操作,帮助减少序列建模中常见的计算需求。基于 SSMs 的基本原理,Mamba 模型 [37] 在序列建模方面实现了显著跃进。Mamba 将状态空间理论与先进的深度学习技术结合起来,采用选择性状态表示,根据输入数据动态调整。此选择性状态机制能够动态过滤掉不重要的信息,以专注于输入序列中最相关的部分,从而减少计算开销并提升效率 [37]。Mamba 架构采用硬件感知、基于扫描的算法,优化 GPU 上的操作,避免了传统基于卷积的 SSMs 的低效性,从而加速训练和推理,使得视觉数据处理更高效,彻底改变了计算机视觉方法 [203]。Mamba 模型在诸如视频处理 [8]、长时间序列数据处理;遥感 [12]、大规模空间数据集处理;以及医学影像 [159]、高分辨率数据的高效精准处理等任务中具有显著优势。由于计算需求高,CNNs 和 Transformers 面临扩展性问题,而 Mamba 模型通过提供与序列长度线性扩展的计算能力,克服了这些问题,使其成为实时和大规模应用的理想选择。它们将状态空间原理与选择性注意力机制相结合,提供了一种稳健的解决方案,用于处理复杂视觉任务,从而实现更高效和可扩展的计算机视觉解决方案。图 1(a) 定性比较了 CNN、Transformer 和 Mamba 框架,而图 1(b) 则基于 ImageNet-1K [124] 数据集上的各种指标提供了定量比较。尽管最近的综述论文探讨了 Mamba 模型的各种方面,如 SSMs [154]、在计算机视觉中的应用 [93, 170, 188] 以及医学图像分析 [52],但本文从模型分类、扫描方法、应用领域、与 CNNs 和 Transformers 的比较分析以及未来方向等方面提供了独特视角,详见表 1。

- 我们全面概述了 Mamba 模型在计算机视觉中的应用,突出其独特特征,并与 CNNs 和 Transformers 进行了比较分析。

- 我们提出了一个新的分类方法,按计算机视觉应用领域对 Mamba 模型进行分类,为研究人员选择合适的模型提供指导。

- 我们展示了 Mamba 模型核心组件的扫描方法的优势与劣势,以及它们的具体应用场景。

- 最后,我们概述了 Mamba 模型的关键挑战,并提出了进一步改进其在计算机视觉中应用的未来研究方向。 本文结构如下:第 2 节概述了 Mamba 模型的分类方法,第 3 节介绍了基于 Mamba 的视觉管道和扫描技术。第 4 节讨论了各个领域的应用,第 5 节则对 Mamba、Transformer 和 CNN 模型进行了比较分析。第 6 节探讨了可能的局限性及未来研究方向,而第 7 节总结了本文的关键发现。

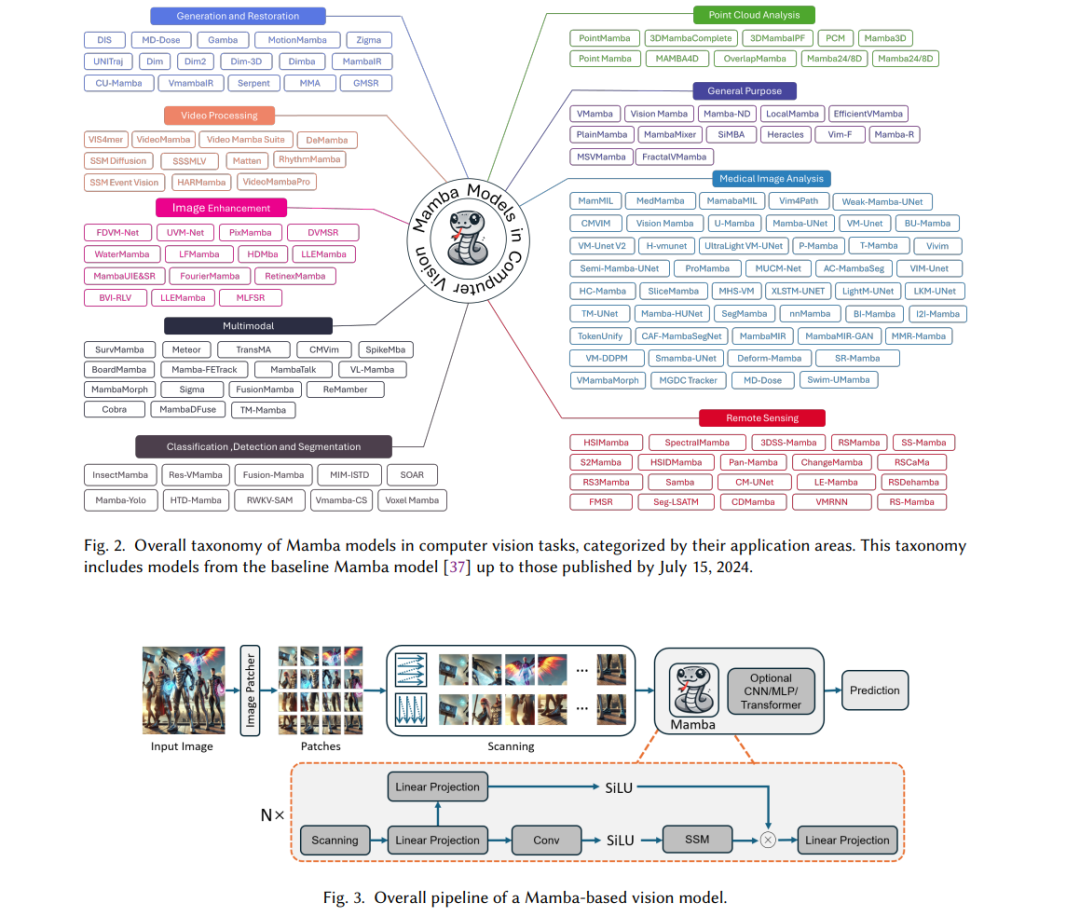

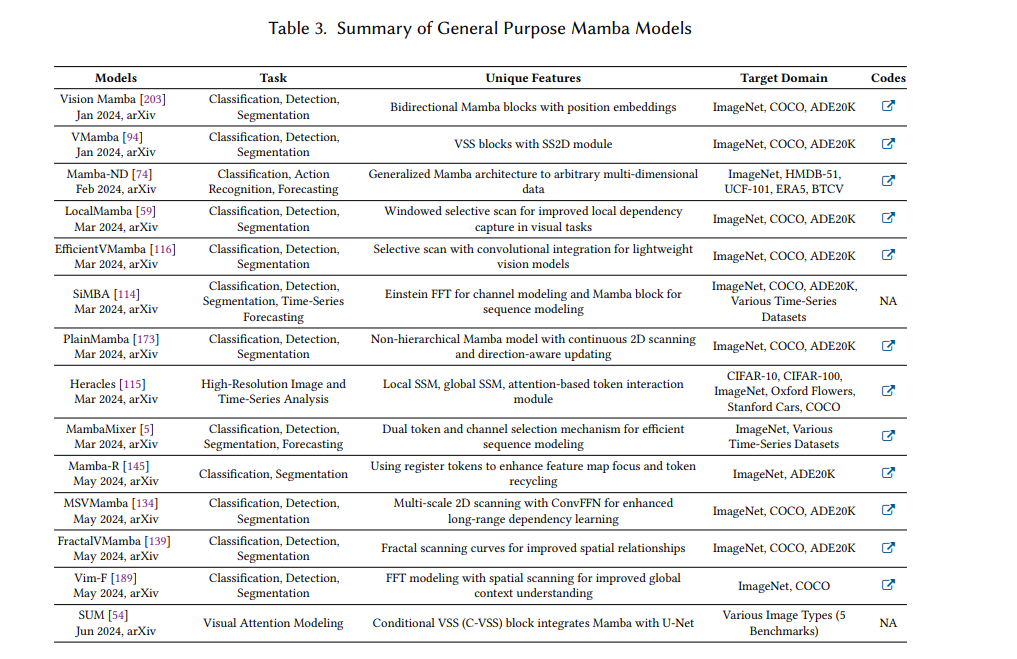

2 Mamba 模型的分类Mamba 在视觉任务中的适应始于2024年初,最早的模型包括 VMamba [94] 和 Vision Mamba (Vim) [203]。这些初期模型推动了视觉处理的边界,为复杂挑战提供了高效的解决方案。为方便未来研究人员,我们开发了一套全面的分类体系,如图 2 所示。该分类突显了基于 Mamba 的模型在九个类别中的多样化应用,对医学图像分析的贡献尤为显著。3 Mamba 模型概述本节中,我们在图 3 中展示了基于 Mamba 的视觉模型的基本流程。该流程从对输入图像进行分块开始,随后进行一系列扫描操作,以提取多尺度特征。分块后,图像通过一个 Mamba 块,通常包括线性投影、卷积层、SiLU 激活函数和 SSM 操作,以最优方式提取特征。根据具体任务的需求,许多模型随后集成了 CNN 和 Transformer 块,以提升性能。接下来,我们将深入探讨 Mamba 块的内部工作原理。4 Mamba 模型在计算机视觉中的应用本节展示了 Mamba 模型在不同计算机视觉任务中的贡献和多样性,包括通用框架(4.1)、图像分类、目标检测和分割(4.2)、图像增强(4.3)、生成与复原(4.4)、3D 点云(4.5)、视频处理(4.6)、遥感(4.7)、医学图像分析(4.8)以及多模态模型(4.9)。图 6 展示了 Mamba 模型在各种视觉任务中的分布情况。

通用 Mamba 框架设计灵活,可适应分类、检测和分割任务。VMamba [94] 通过 VSS 块和 SS2D 模块将 1D 扫描与 2D 视觉数据整合,以提升性能;Vision Mamba [203] 通过双向 Mamba 块和位置嵌入克服了单向扫描的局限性。尽管已有改进,全球上下文捕获仍是一个挑战。Vim-F [189] 通过快速傅里叶变换(FFT)利用频域信息扩展全球感受野,而 Mamba-R [145] 通过寄存器令牌减少特征图中的伪影,输出更干净的结果。在不断演变的模型中,平衡长程依赖学习与计算效率变得至关重要。MSVMamba [134] 通过多尺度 2D 扫描方法结合卷积前馈网络(ConvFFN)提供平衡的解决方案。FractalVMamba [139] 采用分形扫描曲线来增强对空间关系的建模,从而适应不同分辨率的图像。LocalMamba [59] 通过引入窗口化的选择性扫描方法,在网络层间动态调整扫描策略,使其在性能上超越 ViTs 和 CNNs。EfficientVMamba [116] 通过基于 atrous 的选择性扫描和高效跳跃采样,成功减少了浮点运算量(FLOPs),同时保持高性能。扩展 Mamba 在高维数据中的应用引入了新的挑战。Mamba-ND [74] 通过跨维度交替的序列排序,保留 SSMs 的线性复杂度,同时在图像分类和天气预测任务中取得了高准确度。为了增强图像建模的灵活性,SUM [54] 将 Mamba 框架与 U-Net 结构结合。Heracles [115] 集成了局部和全局 SSM 与注意力机制,以应对高分辨率图像和时间序列分析的复杂性。4.2 图像分类、目标检测与分割Mamba 模型通过捕获局部和全局特征来改进图像分类、目标检测和分割任务。例如,InsectMamba [150] 集成了 SSMs、CNNs 和多头自注意力机制,有效应对农业领域中高度伪装和物种多样性的昆虫分类问题。Mamba 还扩展到医学图像分类,MedMamba [185] 和 MamMIL [28] 等模型通过跨多种成像模式优化特征提取,提升分类性能和诊断准确性。在目标检测中,Fusion-Mamba [24] 通过将特征映射到隐藏状态空间,提高了跨模态检测的准确性。SOAR [143] 针对小目标检测,集成了轻量级的 YOLO v9 架构。Mamba-YOLO [156] 结合了 SSMs 和 YOLO 架构中的 LSBlock 和 RGBlock 模块,以提高对局部图像依赖的建模精度。分割任务方面,RWKV-SAM [184] 将 Mamba 与 RWKV 线性注意力架构结合,精确地分割高分辨率图像。VMamba-CS [20] 使用基于 VMamba 的编码器-解码器网络,提高了在建筑表面自主裂缝检测上的表现。4.3 图像增强在图像增强方面,Mamba 在各种领域取得了显著进展。FD-Vision Mamba(FDVM-Net) [199] 通过 C-SSM 块中的卷积层和 SSMs 组合处理内镜成像中的相位和幅度信息,以实现高质量图像重建。水下成像面临颜色失真和模糊问题,PixMamba [86] 使用双层架构来提升水下图像,并控制计算成本。低光图像增强方面,RetinexMamba [4] 结合传统 Retinex 方法与 SSMs 使用创新的光照估计和损坏修复器来保持图像质量和处理速度。UVM-Net [198] 将局部特征提取与 Bi-SSM 块相结合,解决了长程依赖处理的问题。4.4 生成与复原在图像生成中,DiS 模型 [29] 使用 SSM 替代传统 U-Net 样的架构,最小化计算开销,生成高分辨率图像,这在卫星图像和高分辨率内容创建中尤为重要。Gamba [131] 将高斯撒点与 Mamba 的状态空间块相结合,从单视角输入高效进行 3D 重建。在图像复原中,MambaIR [135] 使用双向水平和垂直栅格扫描增强自然图像,彻底整合像素数据以实现高分辨率输出,这对卫星图像等应用至关重要。CU-Mamba [23] 整合 U-Net 架构,高效学习和复原复杂纹理的图像,解决了复杂图案和降质纹理所带来的挑战。4.5 点云分析Mamba 在点云分析中通过解决大数据量、非结构化数据和高计算挑战取得进展。PointMamba [82] 通过序列化排列点数据,实现了 3D 点云的高效处理,减少了参数和 FLOPs,超越了基于 Transformer 的模型。4.6 视频处理Mamba 通过应对长序列和高分辨率数据处理挑战推动了视频处理。ViS4mer [61] 结合 Transformer 编码器用于短程特征提取,并使用多尺度时序 S4 解码器处理长程视频,提高了数据处理速度并显著减少了内存使用。4.7 遥感Mamba 处理卫星和航拍图像中的高维数据,适合于遥感应用。SpectralMamba [180] 通过直接将光谱数据集成到分类过程中,有效解决了高维度和波段间相关性问题。Pan-Mamba [50] 使用通道交换和跨模态 Mamba 块解决全色锐化问题,显著增强了空间和光谱细节。

4.8 医学图像分析

医学图像分析中,Mamba 广泛应用于分类、分割和重建任务。MedMamba [185] 结合卷积层和 SSMs,有效提升了各种医学图像的分类性能。SegMamba [168] 的三向 Mamba(ToM)模块专注于 3D 医学图像的全面解剖覆盖。4.9 多模态多模态模型处理图像、文本、音频和视频等多种数据类型,Mamba 通过融合异构数据来利用不同模态的信息。SurvMamba [18] 结合病理图像和基因组数据来改进生存预测,展示了在多模态数据融合中的强大能力。Broad Mamba [136] 通过分析文本、视频和音频输入增强了多模态会话中的情感识别能力。这些应用展现了 Mamba 模型在多个领域中的多功能性。表 4 到表 14 总结了各类 Mamba 模型在不同任务中的应用情况。