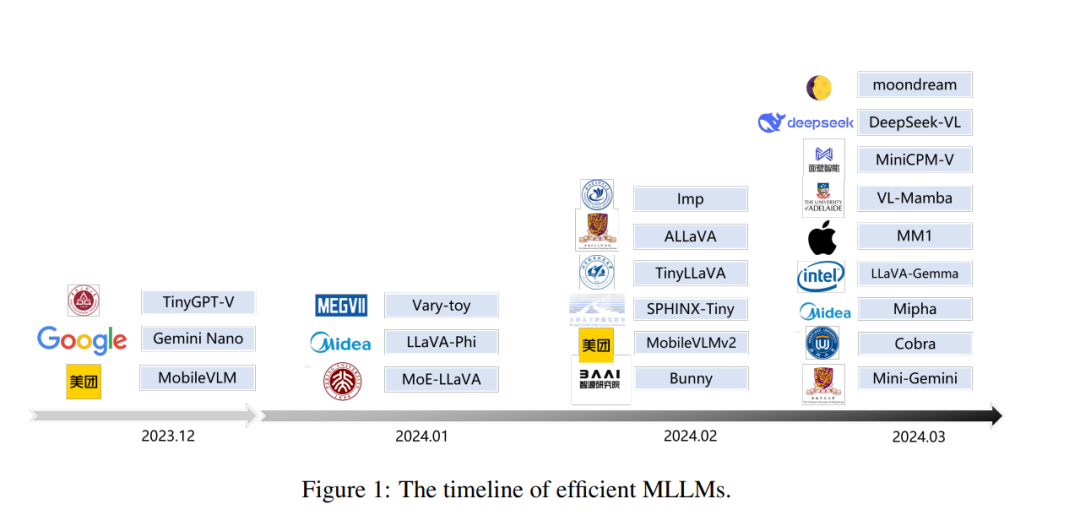

在过去的一年中,多模态大型语言模型(MLLMs)在视觉问答、视觉理解和推理等任务中表现出色。然而,庞大的模型规模和高昂的训练与推理成本阻碍了MLLMs在学术界和工业界的广泛应用。因此,研究高效且轻量级的MLLMs具有巨大的潜力,特别是在边缘计算场景中。在这篇综述中,我们对当前高效MLLMs的研究现状进行了全面而系统的回顾。具体来说,我们总结了代表性高效MLLMs的时间线、高效结构和策略的研究现状以及应用。最后,我们讨论了当前高效MLLM研究的局限性和未来有前景的研究方向。更多详情请参考我们的GitHub仓库:https://github.com/lijiannuist/Efficient-Multimodal-LLMs-Survey。

大规模预训练作为人工智能(AI)领域的一种领先方法,使得像大型语言模型和多模态模型这样的通用模型在许多任务中超越了专门的深度学习模型。大型语言模型(LLM)的卓越能力激发了将它们与其他基于模态的模型结合起来以增强多模态能力的努力。这一概念得到了OpenAI的GPT-4V[1]和Google的Gemini[2]等专有模型显著成功的进一步支持。因此,多模态大型语言模型(MLLMs)应运而生,包括mPLUG-Owl系列[3, 4]、InternVL[5]、EMU[6]、LLaVA[7]、InstructBLIP[8]、MiniGPT-v2[9]和MiniGPT-4[10]。这些模型通过有效利用每种模态的预训练知识,绕过了从头开始训练的计算成本。MLLMs继承了LLM的认知能力,展示了许多显著特性,如强大的语言生成和迁移学习能力。此外,通过与其他基于模态的模型建立强大的表示连接和对齐,MLLMs能够处理来自多种模态的输入,显著拓宽了它们的应用范围。 MLLMs的成功主要归因于规模定律:随着数据、计算能力或模型规模等资源的增加,AI模型的性能会提高。然而,可扩展性伴随着高资源需求,这阻碍了大型模型的发展和部署。例如,MiniGPT-v2的训练需要基于NVIDIA A100 GPU计算出的总计超过800个GPU小时[9]。这对主要企业外的研究人员来说是一个巨大的费用负担。除了训练之外,推理也是MLLMs资源消耗的主要部分。考虑一个典型场景,模型输入包括一个尺寸为336 × 336像素的图像和一个长度为40个tokens的文本提示,使用LLaVA-1.5和Vicuna-13B LLM骨干进行推理需要18.2T的FLOPS和41.6G的内存使用量。大规模模型的资源密集型特性也引发了关于民主化和隐私保护的担忧,因为当前主流的MLLMs,如GPT-4V和Gemini,由少数几家主导企业控制,并在云端运行。如上述实验所示,即使是开源的MLLMs,对计算资源的高要求也使得在边缘设备上运行它们变得具有挑战性。这进一步加剧了确保公平访问和保护用户隐私的挑战。

鉴于这些挑战,高效MLLMs的研究受到了越来越多的关注。这些努力的主要目标是减少MLLMs的资源消耗,扩大其适用性,同时尽量减少性能下降。高效MLLMs的研究始于用轻量级替代品替换大型语言模型,并进行典型的视觉指令微调。随后,研究进一步通过以下方式增强了能力并扩展了用例:(1)引入更轻量的架构,注重效率,旨在减少参数数量或计算复杂度[25, 13, 18];(2)开发了更专业的组件,聚焦于高级架构的效率优化或赋予特定属性,如局部性[19, 17, 12];(3)支持资源敏感任务,一些工作采用视觉token压缩来提高效率,使MLLM的能力能够转移到资源密集型任务中,如高分辨率图像和视频理解[35, 39, 14, 40]。

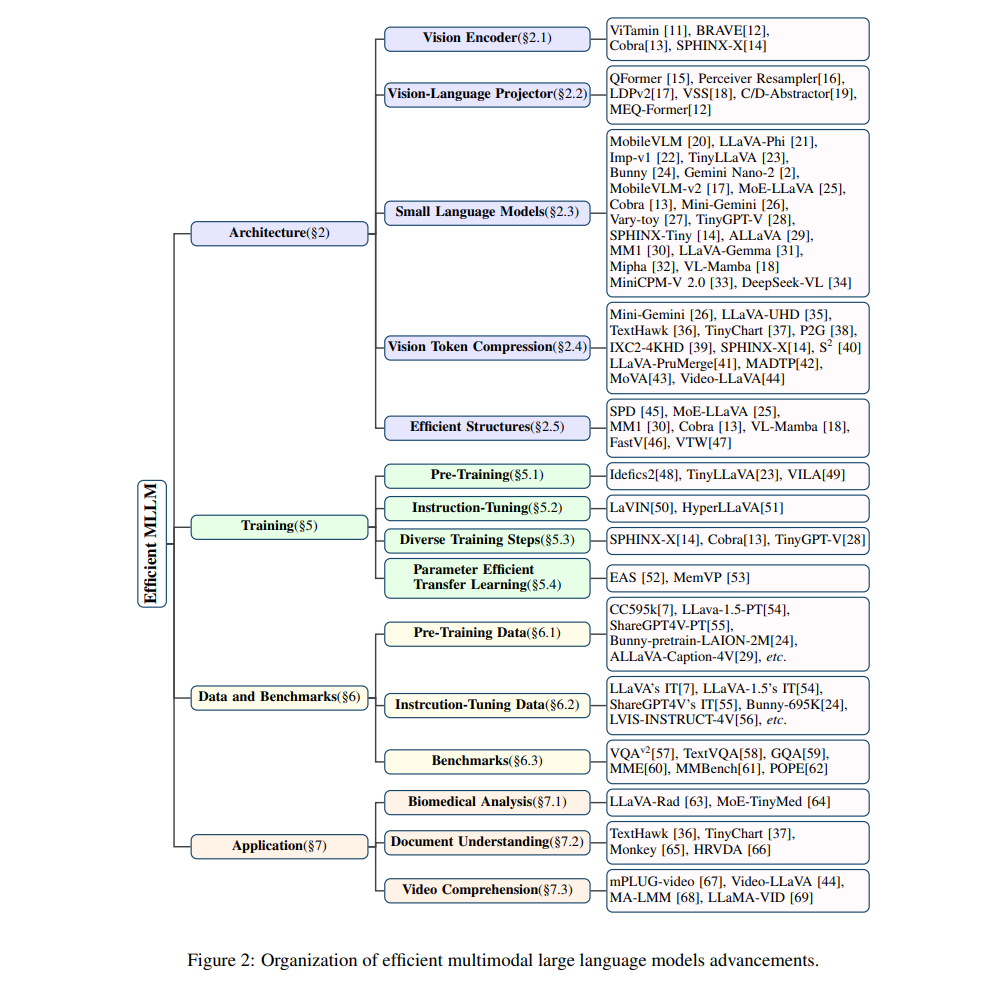

在本综述中,我们旨在呈现快速发展的高效MLLMs领域的最新进展,如图2所示。我们将文献组织成六个主要类别,涵盖高效MLLMs的各个方面,包括架构、高效视觉、高效LLMs、训练、数据和基准测试以及应用。Architecture 关注通过高效技术开发的MLLM框架,以降低计算成本。该架构由多个基于模态的基础模型组成,具有不同于单模态模型的特征,从而促进了新技术的发展。

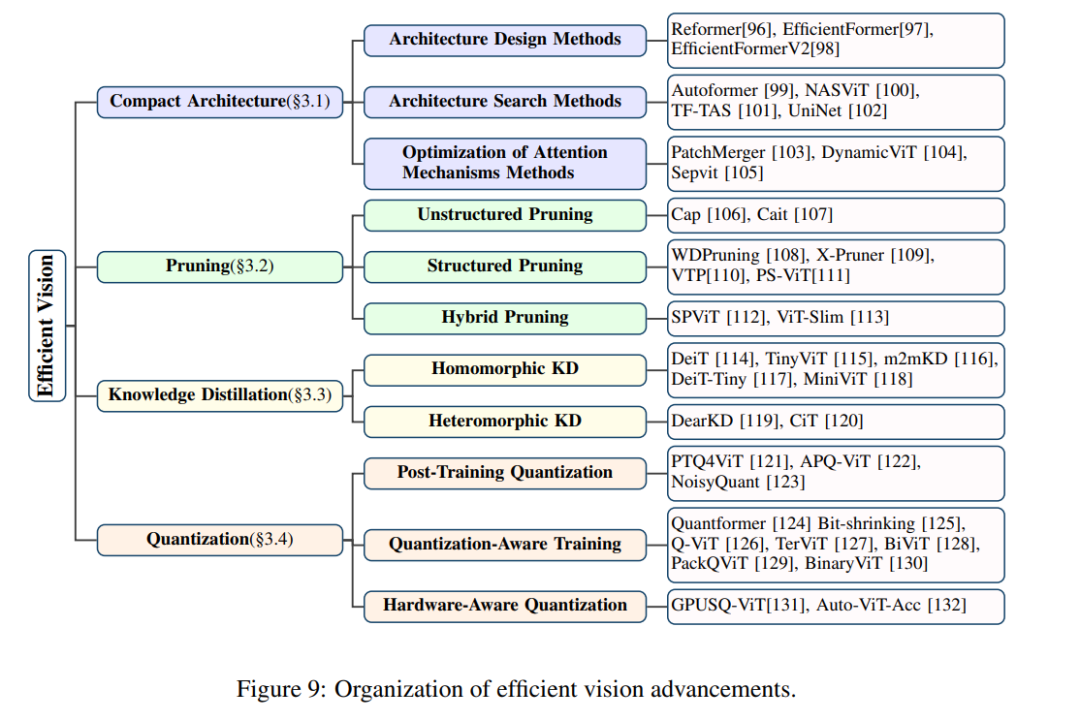

Efficient Vision 探讨优化高效视觉特征提取策略,强调在保持准确性的同时提高效率的方法。它解决了集成高质量视觉数据以实现有效跨模态理解的问题。

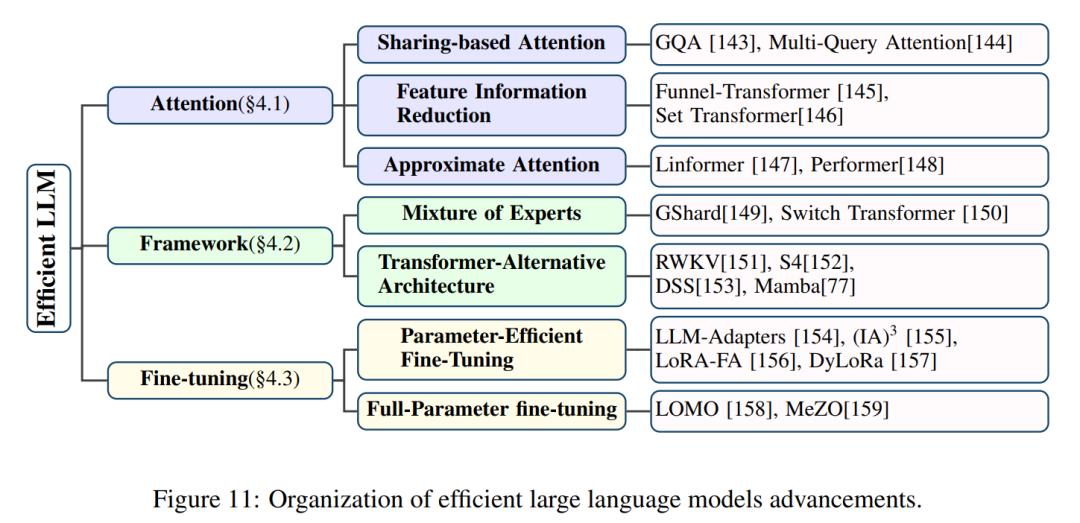

Efficient LLMs 探索提高语言模型计算效率和可扩展性的策略。它研究了模型复杂性与性能之间的权衡,并提出了平衡这些竞争因素的有前景途径。

Training 调查了对高效MLLMs开发至关重要的训练方法的现状。它解决了与预训练阶段、指令微调阶段及整体训练策略相关的挑战,以实现最先进的结果。

Data and Benchmarks 评估用于多模态语言模型评估的数据集和基准测试的效率。它评估了数据集规模、复杂性和计算成本之间的权衡,同时倡导开发优先考虑效率和与现实世界应用相关性的基准测试。

Application 研究高效MLLMs在各个领域的实际影响,强调性能和计算成本之间的平衡。通过解决诸如高分辨率图像理解和医疗问答等资源密集型任务,本节强调了高效MLLMs在拓宽其应用范围和解决现实问题方面的潜力。

总之,这篇综述深入探讨了这些研究工作,探索了多种使MLLMs更具资源效率的策略。我们回顾了高效MLLMs的发展历史,提供了高效MLLMs策略的分类法,并全面比较了现有高效MLLMs的性能。通过这一探索,我们希望提供对当前最先进技术的全面理解,从而揭示这一新兴领域的复杂细微之处。此外,这篇综述还充当了路线图,突出了未来研究的潜在途径,促进了对高效MLLMs领域挑战和机遇的更深入理解。除了这篇综述,我们还建立了一个GitHub仓库,收录了综述中提到的论文,并按照相同的分类法进行整理,地址为:https://github.com/lijiannuist/Efficient-Multimodal-LLMs-Survey。我们将积极维护并纳入新兴研究。

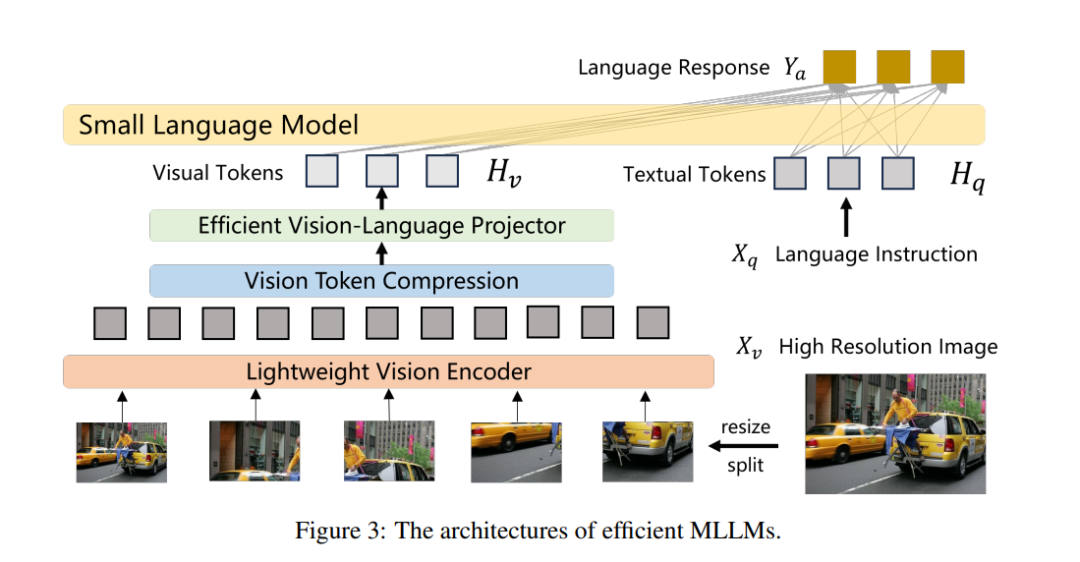

按照标准的MLLM框架,高效MLLMs可以分为三个主要模块:视觉编码器g,负责接收和处理视觉输入;预训练语言模型,管理接收到的多模态信号并进行推理;视觉-语言投影器P,作为连接两种模态的桥梁。为了提高通用MLLMs的效率,主要的优化在于处理高分辨率图像、压缩视觉令牌、实施高效结构以及使用紧凑的语言模型等策略。图3展示了架构图。表1概述了高效MLLMs的总结,包括基础LLM、视觉编码器、图像分辨率和用于连接视觉和语言的投影器。这些高效MLLMs包括:MobileVLM[20]、LLaVA-Phi[21]、Imp-v1[22]、TinyLLaVA[23]、Bunny[24]、Gemini Nano-2[2]、MobileVLMv2[17]、MoE-LLaVA-3.6B[25]、Cobra[13]、Mini-Gemini[26]、Vary-toy[27]、TinyGPT-V[28]、SPHINX-Tiny[14]、ALLaVA[29]、MM1-3B[30]、LLaVA-Gemma[31]、Mipha-3B[32]、VLMamba[18]、MiniCPM-V2.0[70]、DeepSeek-VL[34]、KarmaVLM[71]、moondream2[72]。在本节中,我们将按顺序全面概述这三个模块以及其他高效组件。

Vision Transformer (ViT) [94] 架构在计算机视觉应用中获得了显著的关注并被广泛使用。然而,随着ViT模型规模的增长,可训练参数和操作数量也随之增加,影响了它们的部署和性能。此外,自注意力机制的计算和内存成本随着图像分辨率的增加呈二次增长。参考论文[95],本综述旨在探索可用于高效MLLMs的最有效的视觉编码方法。