在迅速发展的视觉生成领域中,扩散模型革命性地改变了景观,以其令人印象深刻的文本引导生成功能标志着能力的重大转变。然而,仅依赖文本来条件化这些模型并不能完全满足不同应用和场景的多样化和复杂需求。认识到这一不足,多项研究旨在控制预训练的文本到图像(T2I)模型以支持新颖的条件。在这个综述中,我们对可控生成与T2I扩散模型的文献进行了全面调研,涵盖了这一领域的理论基础和实践进展。我们的综述从去噪扩散概率模型(DDPMs)和广泛使用的T2I扩散模型的基础知识简介开始。然后,我们揭示了扩散模型的控制机制,从理论上分析了如何在去噪过程中引入新颖条件进行条件生成。此外,我们提供了这一领域研究的详细概述,从条件视角将其组织成不同的类别:具有特定条件的生成、具有多重条件的生成和通用可控生成。对于所调研的可控生成文献的详尽列表,请参考我们在https://github.com/PRIV-Creation/Awesome-Controllable-T2I-Diffusion-Models上的整理仓库。

https://www.zhuanzhi.ai/paper/9f4a05bc7007432b269db0583ad4babe

扩散模型,作为视觉生成领域的一个范式转变,已经大幅超越了像生成对抗网络(GANs)这样的传统框架【1】-【8】。作为参数化的马尔科夫链,扩散模型展现出了将随机噪声转化为复杂图像的卓越能力,逐步从噪声过渡到高保真的视觉表征。随着技术的进步,扩散模型在图像生成及相关下游任务中展示了巨大的潜力。 随着这些模型生成的图像质量的提升,一个关键挑战变得越来越明显:实现对这些生成模型的精确控制,以满足复杂多样的人类需求。这个任务超越了简单提高图像分辨率或现实感;它涉及到细致地使生成的输出与用户的特定和细腻的需求以及他们的创造性愿景相匹配。得益于大量多模态文本-图像数据集【9】-【17】的出现和引导机制的发展【18】-【21】,文本到图像(T2I)扩散模型已经成为可控视觉生成领域的一个基石【21】-【26】。这些模型能够生成真实、高质量的图像,准确反映自然语言中提供的描述。

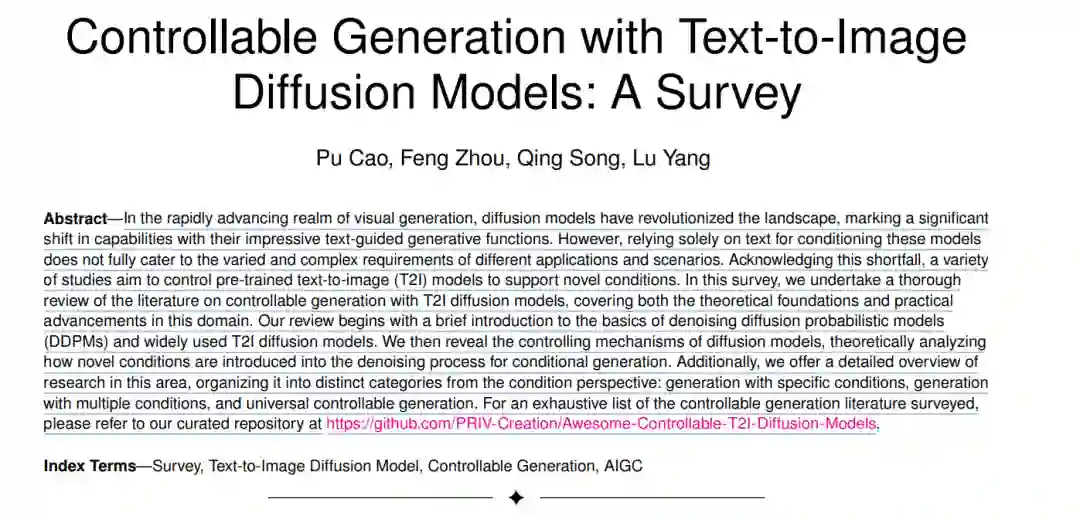

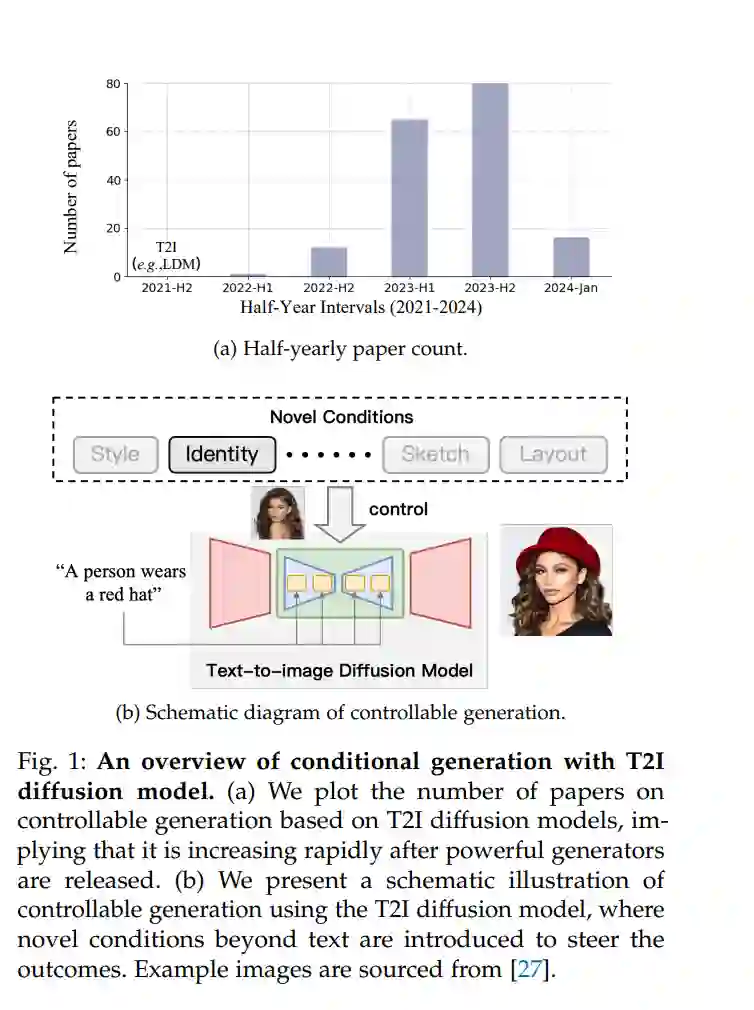

虽然基于文本的条件在推动可控生成领域向前发展方面起到了重要作用,但它们本质上缺乏完全满足所有用户需求的能力。这一限制在一些场景中尤为明显,比如通过文本提示单独无法有效传达的条件,如未见过的人物或独特的艺术风格的描述。这些场景在T2I生成过程中提出了重大挑战,因为这种视觉表征的细微之处和复杂性难以用文本形式封装。认识到这一差距,大量的研究开始转向整合超越文本描述界限的新颖条件到T2I扩散模型中。这一转变进一步得到了强大且开源的T2I扩散模型的出现的促进,如图1a所示。这些进步导致了对多样条件的探索,从而丰富了条件生成的可能性范围,并解决了用户在各种应用中更为复杂和细腻的需求。 尽管有许多调查文章探讨了由AI生成的内容(AIGC)领域,包括扩散模型理论和架构【28】、高效扩散模型【29】、多模态图像合成与编辑【30】、视觉扩散模型【31】-【34】,以及文本到3D应用【35】,但它们通常只简要介绍了控制文本到图像扩散模型或主要关注于其他模态。这种缺乏对T2I模型中新颖条件整合和影响的深入分析凸显了未来研究和探索的一个关键领域。本综述提供了使用文本到图像扩散模型的可控生成的全面回顾,涵盖了理论基础和实际应用。起初,我们提供了T2I扩散模型背景的简要概述,并深入探讨了这些方法的理论基础,阐明了如何将新颖条件整合到T2I扩散模型中。这一探索阐明了先前研究的基本原理,有助于更深入地理解该领域。随后,我们提供了对先前研究的全面概述,强调它们的独特贡献和区别特征。此外,我们探索了这些方法的多样化应用,展示了它们在不同背景和相关任务中的实际效用和影响。

总结来说,我们的贡献包括:

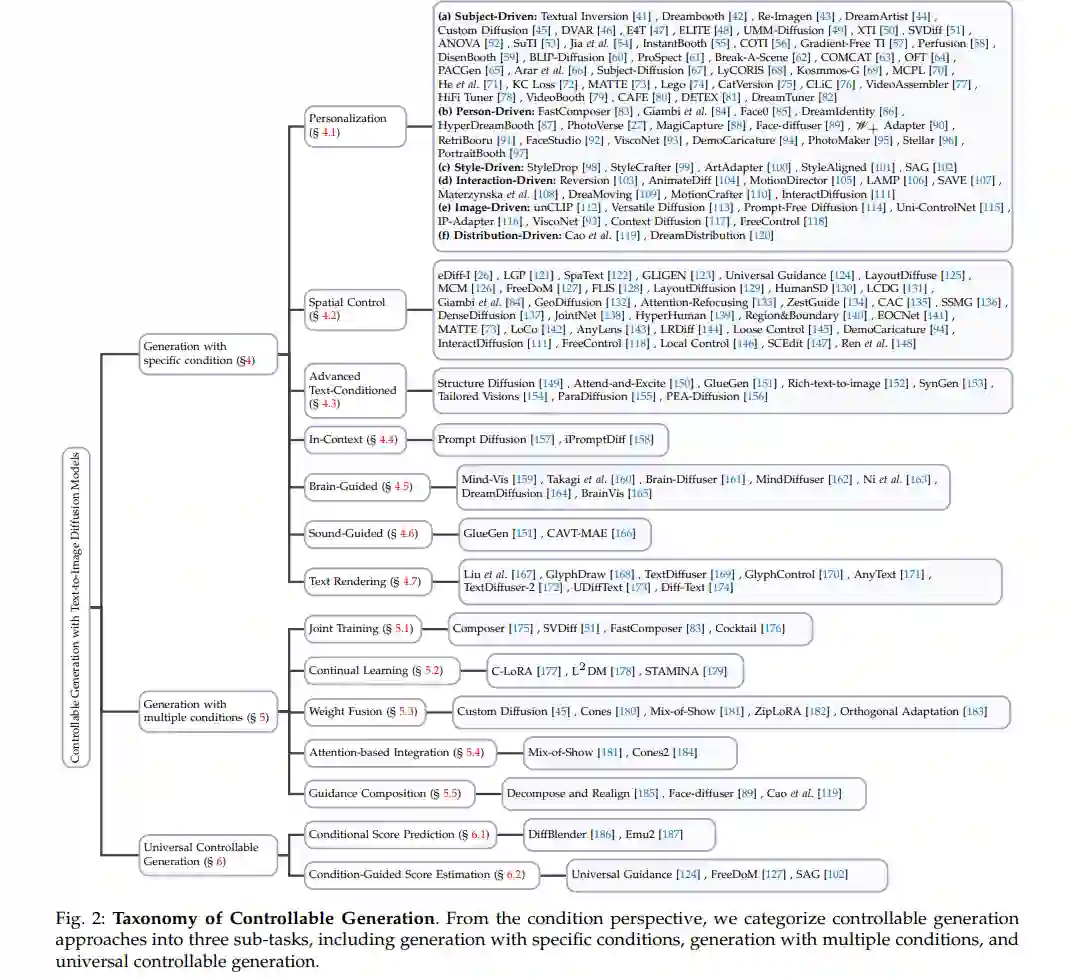

我们从条件角度引入了一个结构良好的可控生成方法的分类法,揭示了这一研究领域固有的挑战和复杂性。

我们对引入新颖条件到T2I扩散模型中的两个核心理论机制进行了深入分析:条件评分预测和条件引导评分估计,提供了对这些机制如何在细粒度级别上运作的细致理解。

我们的回顾是全面的,根据我们提出的分类覆盖了广泛的条件生成研究。我们细致地强调了每种方法的显著特征和独特特点。

我们展示了使用T2I扩散模型的条件生成在各种生成任务中的多样化应用,证明了它作为AIGC时代一个基本和有影响力的方面的出现。

本文的其余部分如下组织。第2节提供了去噪扩散概率模型(DDPMs)的简要介绍,展示了广泛使用的文本到图像扩散模型,并呈现了一个结构良好的分类法。在第3节,我们分析了控制机制并揭示了如何在文本到图像扩散模型中引入新颖条件。第4节总结了根据我们提出的分类控制文本到图像扩散模型的现有方法。最后,第7节展示了可控文本到图像生成的应用。

分类法

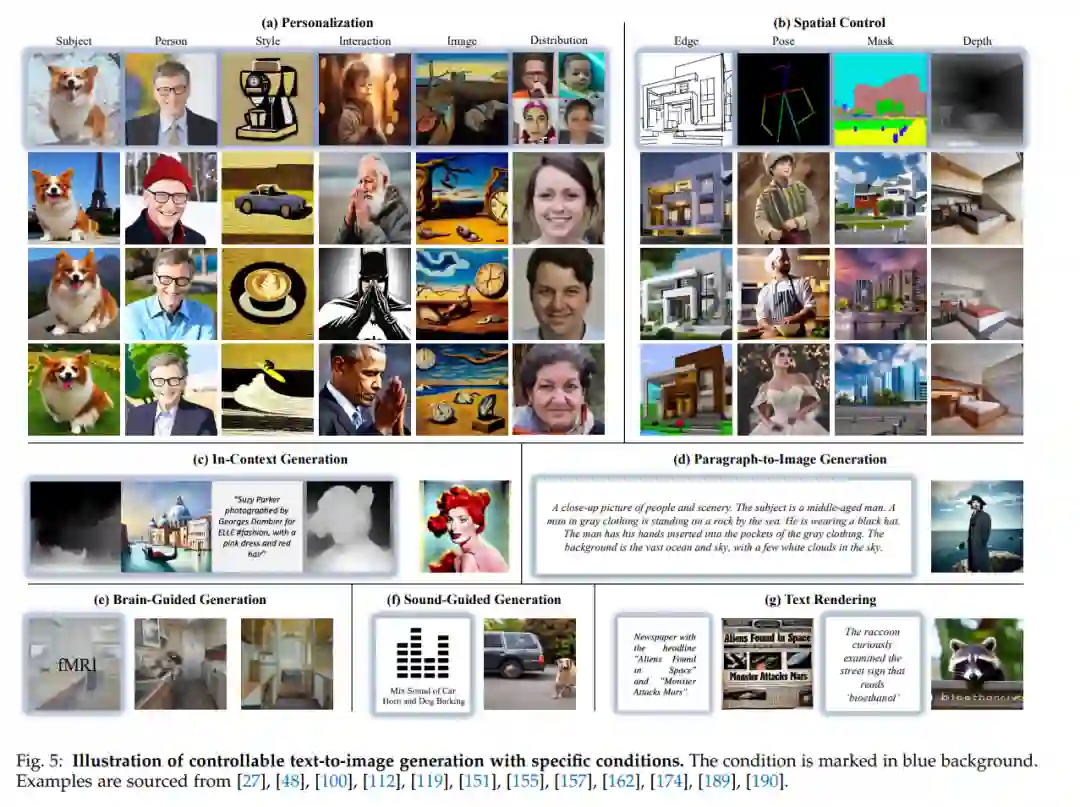

利用文本到扩散模型进行条件生成的任务代表了一个多方面且复杂的领域。从条件视角来看,我们将这个任务划分为三个子任务(参见图2)。大多数工作研究如何在特定条件下生成图像,例如图像引导的生成和草图到图像的生成。为了揭示这些方法的机械理论和特点,我们根据它们的条件类型进一步对它们进行分类。这项任务的主要挑战在于如何使预训练的文本到图像(T2I)扩散模型学会模拟新类型的条件,并与文本条件一起生成,同时确保产生的图像质量高。此外,一些方法探索如何使用多个条件生成图像,例如给定角色的身份和姿态。这些任务的主要挑战在于多个条件的整合,需要能力同时在生成结果中表达几个条件。此外,一些工作尝试开发一种条件不可知的生成方法,可以利用这些条件产生结果。 可控文本到图像生成与特定条件

在文本到图像扩散模型的基础上,引入新颖条件来指导生成过程代表了一个复杂和多方面的任务。在接下来的章节中,我们将根据条件视角回顾现有的条件生成方法,对它们的方法论提供全面的评述。

在多条件生成的任务中,目标是在多个条件下生成图像,例如在用户定义的姿态下生成特定人物,或生成具有三种个性化身份的人物。在本节中,我们从技术角度对这些方法进行全面概述,将它们分类为联合训练(第5.1节)、权重融合(第5.3节)、基于注意力的整合(第5.4节)、引导融合(第5.5节)和持续学习(第5.2节)。注意,一些其他的可控生成方法也展示了多条件合成的能力,而无需专门的设计【41】、【42】、【215】。

通用可控文本到图像生成

除了针对特定类型条件的方法外,还存在旨在适应图像生成中任意条件的通用方法。这些方法根据它们的理论基础被广泛分类为两组:通用条件评分预测框架和通用条件引导评分估计。 应用 在本节中,我们关注那些在生成过程中利用新颖条件来解决特定任务的创新方法。通过强调这些开创性的方法,我们旨在突出条件生成不仅在改变内容创作的格局,还在各个领域扩大创造力和功能性的视野。后续的讨论将提供这些模型的变革性影响及其在多样化应用中的潜力的见解。 结论

在这篇全面的综述中,我们深入探讨了使用文本到图像扩散模型的条件生成领域,揭示了在文本引导生成过程中融入的新颖条件。起初,我们为读者提供了基础知识,介绍了去噪扩散概率模型、著名的文本到图像扩散模型以及一个结构良好的分类法。随后,我们揭示了将新颖条件引入T2I扩散模型的机制。然后,我们总结了以前的条件生成方法,并从理论基础、技术进步和解决策略的角度对它们进行了分析。此外,我们探索了可控生成的实际应用,强调了其在AI生成内容时代的重要作用和巨大潜力。这篇综述旨在提供对当前可控T2I生成格局的全面理解,从而为这一动态研究领域的持续发展和扩展做出贡献。