视觉-语言基础模型(VLFMs)在图像字幕生成、图文检索、视觉问答和视觉定位等各种多模态任务上取得了显著进展。然而,大多数方法依赖于使用通用图像数据集进行训练,缺乏地理空间数据导致在地球观测方面表现不佳。最近提出了许多地理空间图文对数据集和在其上进行微调的VLFMs。这些新方法旨在利用大规模多模态地理空间数据构建具有多样地理感知能力的多功能智能模型,我们称之为视觉-语言地理基础模型(VLGFMs)。本文全面回顾了VLGFMs,汇总并分析了该领域的最新发展。特别是,我们介绍了VLGFMs兴起的背景和动机,突出了其独特的研究意义。然后,我们系统总结了VLGFMs采用的核心技术,包括数据构建、模型架构和各种多模态地理空间任务的应用。最后,我们总结了关于未来研究方向的见解、问题和讨论。据我们所知,这是VLGFMs的首次综合文献综述。我们持续追踪相关工作:

https://github.com/zytx121/Awesome-VLGFM。

在过去的十年中,研究人员在几乎所有地理空间任务上都取得了显著进展,例如场景分类[1]、目标检测[2][3]、变化检测[4]、去噪[5]、土地利用分割[6]、灾害管理[7]和地理空间定位[8],这些进步是由深度学习和其他人工智能技术推动的。然而,这些模型是专门为特定任务设计和训练的,因此难以直接应用于其他任务。即使是相似的任务,这些模型通常也表现出较差的泛化能力。

例如,遥感目标检测是地球观测的核心任务之一。它需要手动标注每个目标的位置和类别,这是一个耗时且劳动密集的过程。遥感图像(RSIs)是由天基或空基传感器从上方视角拍摄的,与自然图像相比,这些图像呈现了独特的视角,导致了定向目标检测的发展。由于该任务使用旋转边界框来表示目标,因此需要带有旋转边界框标注的遥感数据集,如DOTA[9],来支持其训练。此外,模型架构[10]、损失函数[11]、后处理函数和加速操作器[12]也必须基于标准目标检测[13]进行修改。从这个角度来看,特定模型的应用场景似乎相当有限,缺乏跨任务甚至是相似任务之间的泛化能力。

为了减少为每个任务从头开始训练特定模型所浪费的资源,基础模型[14]应运而生。这些模型在大规模图像上进行预训练,使它们能够通过微调小规模的定制数据集来处理各种视觉任务。在遥感领域,先前对纯视觉基础模型的研究揭示了地球观测通用模型的巨大潜力,称为视觉地理基础模型(VGFMs)。VGFMs在从单模态到多模态、从静态到时态的全面评估中表现出显著的泛化能力。尽管这些模型表现出强大的感知能力,但它们缺乏像人类一样进行推理的能力。例如,没有相应的标注样本支持VGFM训练,它无法通过考虑周围环境和常识来确定遥感图像中建筑物的具体功能,而人类则可以。类似地,没有标注样本,VGFM无法根据航空影像中的特征识别汽车的品牌或型号,而人类可以。

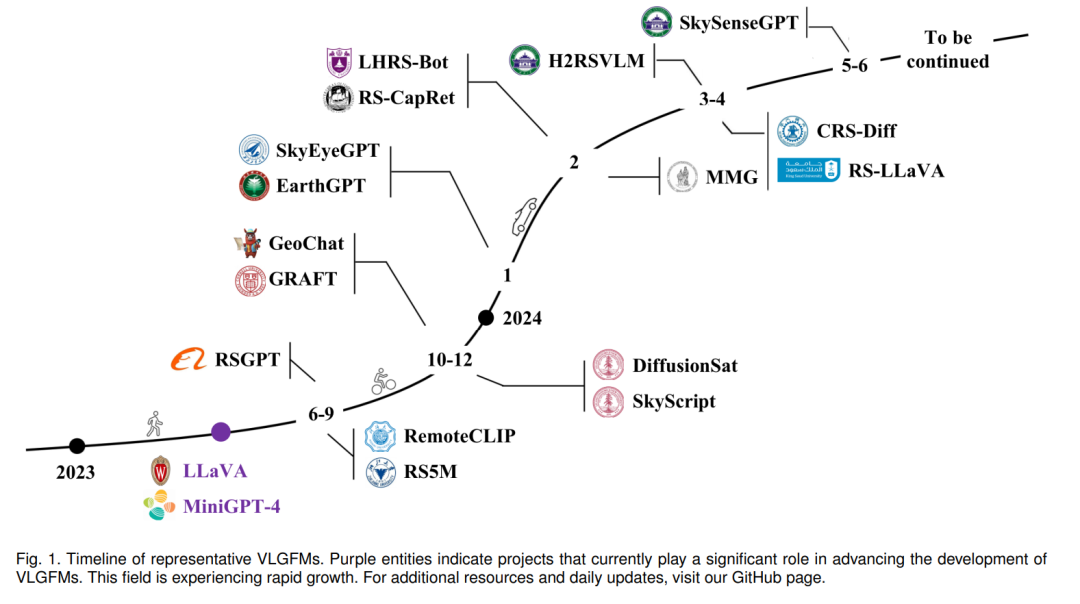

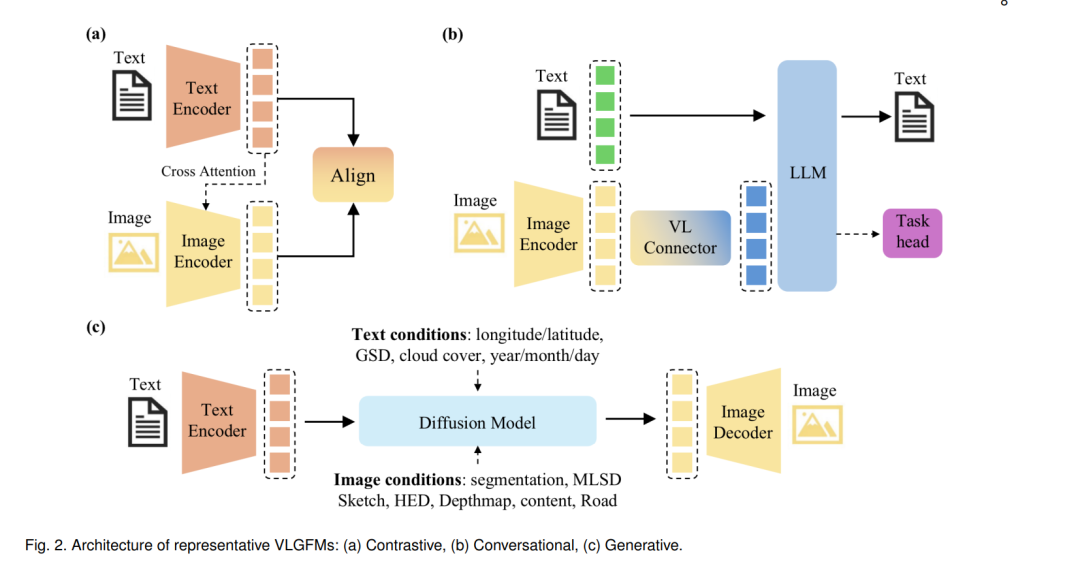

近年来,大型语言模型(LLMs)的发展彻底改变了人机交互。像BERT[16]这样的LLMs利用大量文本数据来开发推理能力,显示出在自然语言处理的各种任务中的显著泛化能力。然而,LLMs只处理离散的文本数据,无法处理图像,而视觉基础模型虽然能够处理图像数据,但缺乏推理能力。为了弥合这些差距,引入了视觉-语言基础模型(VLFMs)的概念。这些创新模型旨在进行感知和推理,整合来自文本和图像的输入。自从GPT-4 Vision发布以来,VLFMs的研究热度不断高涨,受到其强大能力的启发。VLFMs的研究主要分为对比、对话和生成范式。下面,我们将简要介绍三个方向中最具影响力的工作。具体而言,CLIP[17]采用对比范式,将视觉和文本信息投射到统一的表示空间,从而促进了下游视觉-语言任务的桥梁。LLaVA[18]体现了对话范式,使LLMs能够在文本和视觉模态中进行上下文感知对话。Stable Diffusion[19],作为生成范式的代表,利用深度学习从文本描述中生成高质量、详细的图像,从而提升了图像合成和创意视觉应用的能力。 当VLFMs应用于地球观测时,本文将其称为视觉-语言地理基础模型(VLGFMs)。截至目前,VLGFMs也可以分为对比型、对话型和生成型。图1列出了开发的代表性VLGFM及其发布时间。可以看出,VLGFMs首次出现在2023年第二季度。目前,相关工作的数量正处于快速增长期。值得注意的是,目前VLGFM的创新主要集中在收集训练数据上,对模型架构的修改相对较少。大多数工作涉及基于LLaVA[18]和MiniGPT-4[20]框架,使用定制的遥感指令跟随数据集进行微调。

随着VLGFM的快速发展并展示出令人印象深刻的成果,追踪和比较VLGFM的最新研究是值得的。它通过自然语言对话实现了人类与计算机的端到端交互,改变了依赖于预定义程序接口的传统人机交互方式。据我们所知,目前没有综述全面总结VLGFMs的最新进展,包括数据管道、架构、基准和能力。我们的工作旨在填补这一空白。

贡献。鉴于VLGFM的快速进展和令人鼓舞的成果,我们编写了这篇综述,旨在使研究人员了解VLGFMs的基本概念、主要方法和当前进展。这篇综述提取了共同的技术细节,并涵盖了VLGFMs领域最具代表性的工作。它还对背景和相关概念,包括VGFMs和遥感LLM驱动的代理进行了比较分析。此外,我们将VLGFMs的表现能力分为三个层次。据我们所知,这是关于VLGFMs的首次综述。

综述流程。在第2节中,我们提供了背景知识,包括定义、数据集、指标和相关研究领域。在第3节中,我们对基于不同数据收集方法、网络架构和能力的各种方法进行了全面回顾。在第4节中,我们识别了挑战和未来方向。