基于变换器架构的大型模型在人工智能中扮演着越来越重要的角色,特别是在自然语言处理(NLP)和计算机视觉(CV)领域内。模型压缩方法减少了它们的内存和计算成本,这是在实际设备上实现变换器模型的必要步骤。鉴于变换器的独特架构,特别是交替注意力机制和前馈神经网络(FFN)模块,需要特定的压缩技术。这些压缩方法的效率也非常重要,因为通常不现实在整个训练数据集上重新训练大型模型。本综述提供了近期压缩方法的全面回顾,特别关注它们在变换器模型上的应用。压缩方法主要分为剪枝、量化、知识蒸馏和高效架构设计四个类别。在每个类别中,我们讨论了CV和NLP任务的压缩方法,强调共同的基本原则。最后,我们深入探讨了各种压缩方法之间的关系,并讨论了该领域的进一步方向。

深度神经网络已成为众多人工智能应用中不可或缺的部分,其架构涵盖了多种形式,如多层感知机(MLP)、卷积神经网络(CNN)、循环神经网络(RNN)、长短期记忆网络(LSTM)、变换器(Transformers)等。近来,基于变换器的模型已成为各个领域的主流选择,包括自然语言处理(NLP)和计算机视觉(CV)领域。考虑到它们强大的扩展能力,大多数拥有超过数十亿参数的大型模型都是基于变换器架构的,这些模型被视为通用人工智能(AGI)的基础元素。尽管大型模型展示了显著的能力,但它们极大的规模对实际开发提出了挑战。例如,GPT-3模型有1750亿参数,大约需要350GB的内存模型存储空间(float16)。巨大的参数量及其相关的计算开销要求设备具有极高的内存和计算能力。直接部署这样的模型将会产生巨大的资源成本,并显著增加二氧化碳排放。此外,在像手机这样的边缘设备上,由于存储和计算资源有限,这些模型的开发变得不切实际。

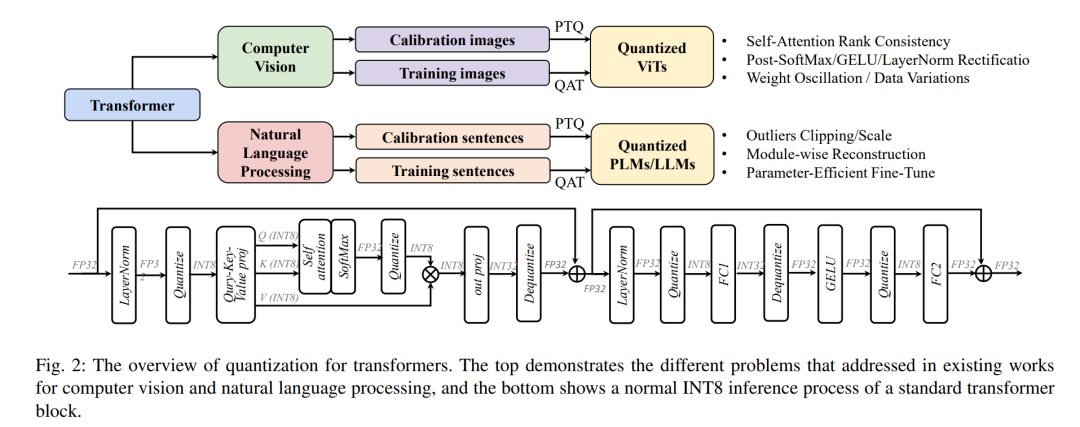

模型压缩是一种有效的策略,用于减轻与变换器模型相关的开发成本。这种方法基于减少冗余的原则,包括多种类别,如剪枝、量化、知识蒸馏、高效架构设计等。网络剪枝直接移除冗余组件,如块、注意力头、FFN层或个别参数。通过采用不同的剪枝粒度和剪枝标准,可以派生出多种子模型。量化通过使用较低位表示模型权重和中间特征来减少开发成本。例如,将全精度模型(float32)量化为8位整数时,内存成本可以减少四分之一。根据计算过程,它可以分为训练后量化(PTQ)或量化感知训练(QAT),其中前者只需要有限的训练成本,对大型模型更有效。知识蒸馏作为一种训练策略,将知识从大模型(教师)转移到小模型(学生)。学生通过模拟模型的输出和中间特征来模仿教师的行为。值得注意的是,对于像GPT-4这样的高级模型,仅通过APIs访问,它们生成的指示和解释也可以指导学生模型的学习。除了从预定义的大型模型获得模型外,一些方法通过直接减少注意力模块或FFN模块的计算复杂性来产生高效的架构。结合不同的方法可以实现极端压缩。例如,Han等人结合了网络剪枝、量化和哈夫曼编码,在传统的VGGNet上实现了令人印象深刻的49倍压缩率。关于变换器模型,它们的压缩策略展示出独特的特点。与CNN或RNN等其他架构不同,变换器具有独特的设计,包括替代的注意力和FFN模块。前者通过计算不同令牌上的注意力图来捕获全局信息,而后者分别从每个令牌提取信息。这种特定的架构可以激发针对最优压缩率的定制压缩策略。此外,对于这样的大型模型,压缩方法的效率尤为重要。由于大型模型的高计算成本,通常无法负担在原始训练集上重新训练整个模型。一些训练效率高的方法,如训练后压缩更受青睐。

在这项综述中,我们旨在全面调查如何压缩这些变换器模型(图1),并且根据量化、知识蒸馏、剪枝、高效架构设计等将方法进行分类。在每个类别中,我们分别调查了NLP和CV领域的压缩方法。表1总结了主要的压缩类别,并列出了适合大型变换器模型的代表性方法。尽管NLP和CV通常被视为非常不同的领域,我们观察到它们的模型压缩方法实际上共享相似的原则。最后,我们讨论了不同压缩方法之间的关系,并提出了一些未来的研究方向。本文的其余部分组织如下。第2节介绍变换器的基本概念。继此之后,第3节对保持架构的压缩方法进行了深入讨论,包括量化和知识蒸馏——这些技术保持了模型的架构。第4节进一步探讨了保持架构的压缩,包括剪枝和高效架构设计。第5节探索了额外的变换器压缩方法。最后,第6节总结了压缩方法并讨论了未来的研究方向。架构保留型压缩量化是在各种设备上部署变换器的关键步骤,尤其是对于设计了专用于低精度算术运算的GPU和NPU。1)训练后量化(PTQ)[21],[41],[22],[42],[43],[44],[45],主要集中在使用少量未标记的校准数据优化权重和激活的量化参数,一些最新方法还探索了权重量化的自适应舍入。(2) 量化感知训练(QAT)[46],[47],[48],[49],[50],[51],[23],[52],[53],[54],[55],[56],将量化节点插入网络并使用完整的训练数据进行训练,其中所有的权重和量化参数都一起优化。在本节中,我们系统地介绍了基于变换器的视觉模型和大型语言模型的模型量化研究,如图2所示。

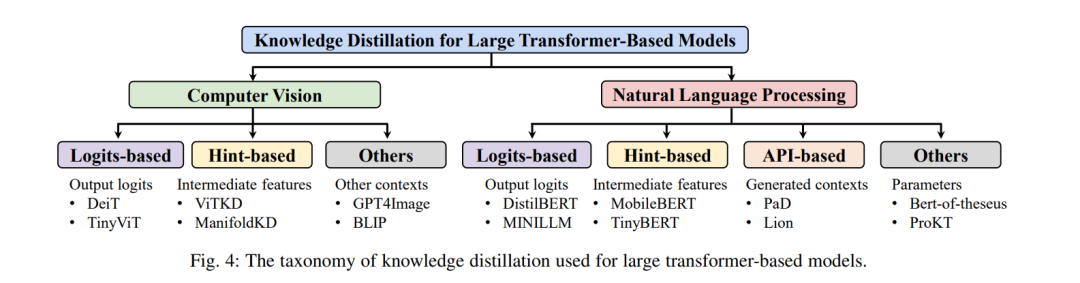

知识蒸馏(KD)旨在通过压缩[83],[84],[85]或转移[87],[88],[86]来自教师网络的知识来训练学生网络。在本文中,我们主要关注旨在实现一个紧凑的学生模型的蒸馏方法,同时保持与笨重的教师模型相比满意的性能。学生模型通常具有更窄、更浅的架构,使它们更适合在资源有限的系统上部署。

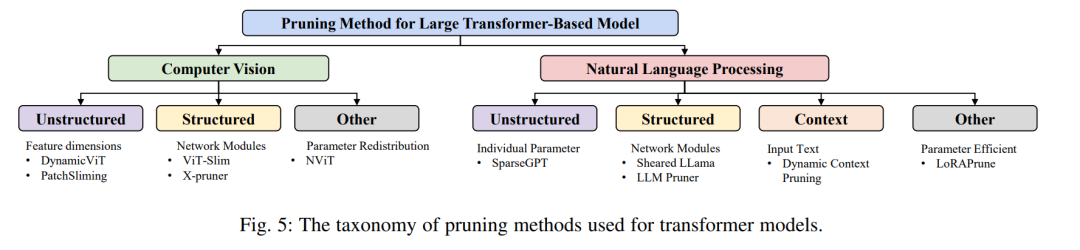

神经网络剪枝长期以来被认为是一种有效的方法,用于缩小模型大小和加速模型推理。剪枝方法的分类可能相当复杂,包括剪枝和模型训练的顺序、结构规范,以及确定被剪枝参数的方式[133]。然而,在本综述的范围内,将源模型限定为针对自然语言处理[134],[4]或视觉识别[12],[26],[135],[136]的预训练大型变换器,提出了几种特定的技术类别需要被讨论(见图5)。

结论

在这项综述中,我们系统地调查了变换器模型的压缩方法。与传统模型的压缩方法相比,压缩变换器模型时有独特的考虑因素。与如CNN或RNN等其他架构不同,变换器拥有独特的架构设计,包括替代的注意力和FFN模块,这要求专门定制的压缩方法以获得最佳压缩率。此外,这些大型模型的压缩方法效率尤其关键。某些模型压缩技术需要大量的计算资源,对于如此庞大的模型可能是难以承受的。这项综述旨在涵盖与变换器相关的大多数近期工作,并为它们的压缩制定一个全面的路线图。随后,我们深入探讨了各种方法之间的相互联系,解决后续挑战,并概述了未来研究的方向。

不同压缩方法之间的关系。不同的压缩方法可以一起使用,以获得极其高效的架构。一个传统的序列是首先定义一个具有高效操作的新架构。然后移除冗余组件(例如,注意力头,层)以获得更小的模型。对于实际硬件实现,将权重或激活量化到较低位是必不可少的。所需位数的选择不仅取决于错误的容忍度,还取决于硬件设计。作为一个例子,Int8计算在Nvidia A00上高效优化,但在较老的Tesla P100上缺乏支持。蒸馏通常作为一种训练策略,在剪枝和量化的微调阶段都适用。为了追求极高的压缩率,探索如何结合不同的压缩策略是有前景的。尽管在CNN这样的传统模型上已经被广泛探索,但变换器模型具有更复杂的架构和更高的计算成本。通过联合搜索找到合适的组合策略是具有挑战性的。

训练高效的压缩策略。与压缩传统模型相比,更加强调压缩方法的计算成本。大型变换器目前在使用大量计算资源的大型数据集上进行训练。例如,Llama2在几个月内使用数千个GPU在2万亿令牌上进行训练。在预训练期间,尤其当原始数据通常无法访问时,使用可比的计算资源进行微调是不切实际的。因此,在训练后应用高效的压缩方法变得更加可行。最初为传统小模型开发的一系列工作已广泛研究了训练后量化,这些方法已无缝过渡到变换器。仅用几个GPU小时,一些最新的工作GPTQ、SmoothQuant已将FP16模型量化到Int8,而不会造成显著性能损失。然而,对于较低位(例如,4位),量化模型仍然遭受显著的性能下降。值得注意的是,极低位模型,如二进制变换器,在传统小模型中已被广泛探索,但在大模型的背景下仍然相对未被探索。

对于剪枝,训练后的挑战与剪枝粒度密切相关。虽然非结构化稀疏性可以实现高压缩率并且最小化微调需求,但类似策略难以转移到结构性剪枝。直接移除整个注意力头或层将导致模型架构的显著改变和准确率的显著降低。如何识别有效权重以及如何有效恢复性能都是洞见方向。识别有效权重和恢复表示能力的高效策略是解决这些挑战的关键研究方向。

超越变换器的高效架构。在现实世界应用中,变换器架构的输入上下文可以扩展到极长长度,包括NLP中的序列文本(例如,数十万词的书)或CV中的高分辨率图像。原生注意力机制对输入序列长度的复杂度呈二次方增长,对于长序列输入构成了显著的计算挑战。许多研究通过减轻注意力的计算成本来解决这个问题,采用了稀疏注意力、局部注意力等技术。然而,这些注意力压缩策略通常会妥协表示能力,导致性能降低。如RWKV和RetNet等新兴架构采用类似RNN的递归输出生成,有效地将计算复杂度降低到O(N)。这一发展为进一步探索更高效模型提供了希望。对于计算机视觉任务,即使是不带注意力模块的纯MLP架构也能达到SOTA性能。超越广泛使用的变换器架构,通过仔细研究它们的效率、泛化能力和扩展能力,探索新的高效架构是有前景的。