近期基础模型的浪潮在计算机视觉(CV)及其他领域取得了巨大成功,其中“任意分割模型”(SAM)激发了探索任务无关的视觉基础模型的热情。凭借其卓越的零样本泛化能力,SAM 正在挑战许多传统的计算机视觉范式,在各种图像分割和多模态分割任务(如文本到掩码)中表现出色,同时也在视频领域取得了卓越的表现。此外,最新发布的 SAM 2 再次点燃了对图像和视频可提示视觉分割的研究热情。然而,现有的综述主要集中在 SAM 在各种图像处理任务中的应用,视频领域的全面深入的综述明显缺乏。为弥补这一空白,本文对基础模型时代的视频领域 SAM 进行了系统性的综述。作为首个回顾 SAM 在视频领域进展的工作,本文重点讨论了其在各种任务中的应用,探讨了基础模型在广泛应用中的最新进展和创新机遇。我们首先简要介绍了 SAM 和视频相关研究领域的背景。随后,我们提出了一个系统的分类法,将现有方法划分为三个关键领域:视频理解、视频生成和视频编辑,并分析总结了它们的优缺点。此外,本文还提供了基于 SAM 的方法与当前最先进方法在代表性基准测试中的对比结果以及深刻的分析。最后,我们讨论了当前研究面临的挑战,并展望了 SAM 在视频领域及其他相关领域未来的研究方向。 关键词:综述、任意分割模型、视频理解、视频生成、视频编辑。

近年来,基础模型[1]–[3]成为了一个重要的研究领域,革命性地改变了自然语言处理(NLP)、计算机视觉(CV)和机器学习等多个领域。这些模型通常在大规模数据集上进行预训练,使其能够学习输入数据的通用表示,并提取有意义的特征,进一步微调以适应特定的应用。虽然基础模型主要在NLP领域得到了广泛关注,但其应用范围远不止于此。在计算机视觉领域,研究人员正在探索基础模型在图像理解[4]–[6]、目标检测[7]、[8]、图像分割[9]、[10]及其他与视觉相关的任务[11]、[12]中的应用。

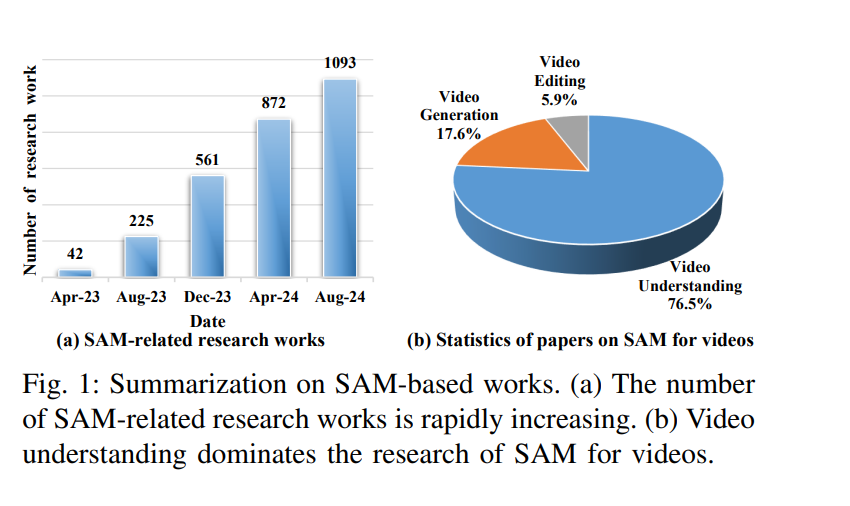

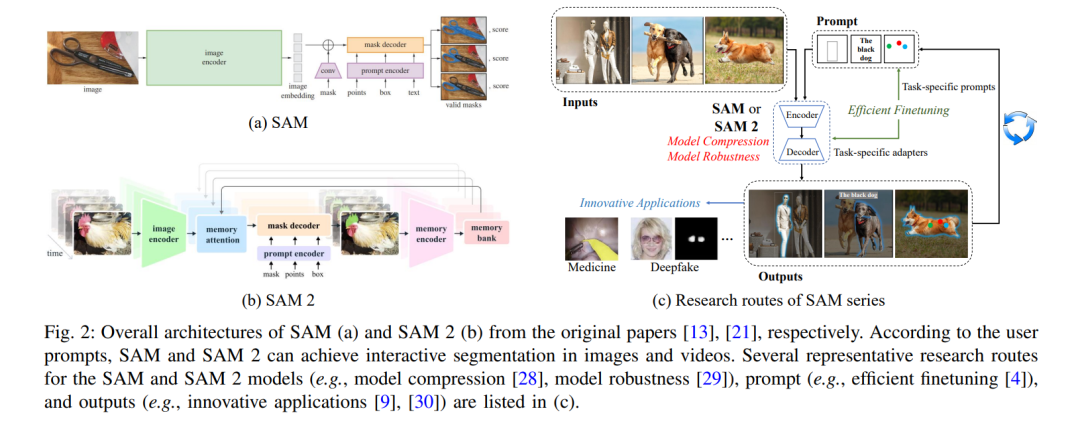

一个显著的例子是“任意分割模型”(SAM)[13],它在探索通用且任务无关的基础模型方面取得了显著进展。通过在超过11万张图像上的10亿个掩码上进行训练,SAM能够基于多种提示(例如点、框和文本)生成高质量的分割掩码。更重要的是,SAM在各种分割任务中表现出强大的零样本泛化能力(例如交互式分割、语义分割和全景分割),无需像以前那样进行重新训练或微调[14]。因此,SAM的出现使得许多研究人员认为这是计算机视觉领域的“GPT-3时刻”,因为SAM已经学会了“物体是什么”的一般概念,即使对于未知的物体、不熟悉的场景(例如水下环境和细胞显微镜以及模糊的情况)也是如此[15]。大量研究人员已将SAM扩展到不同的领域[16]–[20]。如图1(a)所示,自2023年4月以来,关于SAM的研究工作数量显著增加。

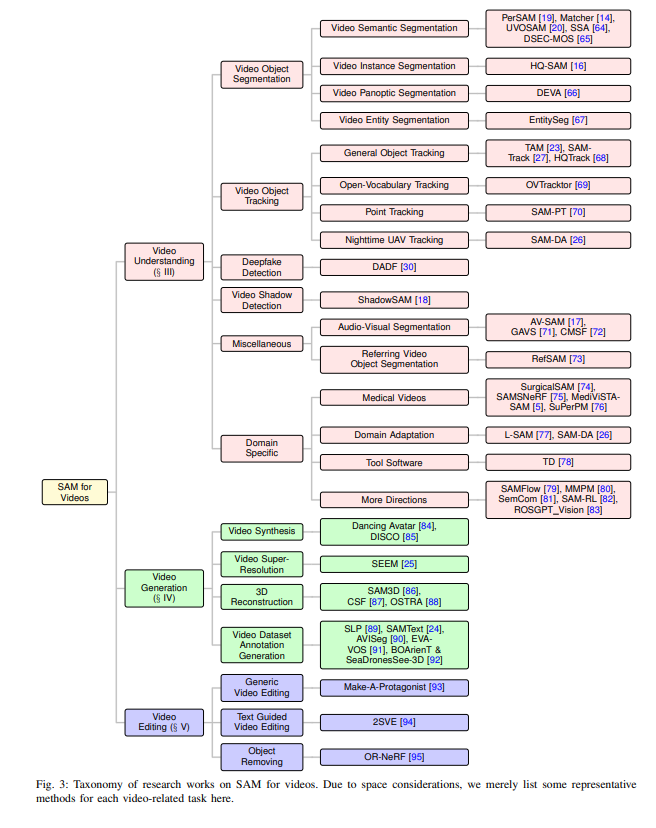

任意分割模型2(SAM 2)[21]通过将Transformer框架与流式存储器集成,增强了其前身SAM,提供了更强的实时视频分割能力。SAM 2在大规模且多样化的任意分割视频(SA-V)数据集上进行训练,特别是在视频任务中,表现出比SAM更高的精度和效率,并为跨不同时空上下文的可提示视觉分割提供了强大的解决方案。 将SAM纳入视频任务。视频在当今数字时代是一个极其重要的媒介[22]。与静态图像和纯文本相比,视频提供了强大的视觉表现力、增强的感知和记忆、强大的叙事能力和丰富的交互性,使其成为一种更有效的交流和娱乐媒介[2],[22]。对SAM在视频任务中的探索正在迅速成为一个蓬勃发展的研究领域[3],[23]–[25]。尽管SAM在各种图像任务中显示出巨大的潜力,但它在视频任务中仍面临诸多挑战,如确保SAM能够在长视频帧中始终如一地生成一致的掩码[16],[19],以及提高其处理大规模视频数据的可扩展性和效率[26],[27]。目前大多数与视频相关的工作通常直接应用SAM以实现创新应用的显著效果。为了全面理解这一前沿研究领域,如图1(b)所示,我们进行了这次综述,并将已有的创新应用工作划分为三个主要类别(即视频理解、视频生成和视频编辑)。

视频中的独特挑战。与其他任务(如图像和文本处理)相比,视频任务呈现以下独特挑战[3],[22]–[25]。1)时间信息处理:视频数据不仅包含空间信息,还包含时间动态。因此,处理视频数据需要考虑时间关系和动态变化。2)高维数据:视频的每一帧都由大量像素组成的高维数据组成,导致数据量庞大,要求更多的计算资源和存储空间。3)连续性和稳定性:视频通常是连续的,处理时需要考虑帧之间的连贯性和稳定性,以在分析和应用中获得可靠的结果。4)时间成本:由于视频数据量大,处理视频任务的时间成本通常更高,对计算资源和算法效率提出了更高的要求。5)动作和事件识别:与静态图像相比,视频任务通常涉及动作和事件识别,要求模型理解和学习时间序列中的动态变化。上述挑战预示着视频任务的极端复杂性和巨大的研究机会[16],[22],[27]。

与现有综述的对比。尽管已有三篇综述[3],[9],[31]提出了关于SAM的研究,但我们的综述与现有综述的区别主要体现在三个方面。1)以往基于SAM的综述仅聚焦于医学图像分割任务[9]或大致覆盖视频任务[3],[31],然而,视频领域的SAM是一个具有许多创新机会和潜在应用的挑战性和前景广阔的研究课题[22]。这激励我们进行一项专门针对这一特定领域(即视频领域的SAM)的系统性综述,以惠及相关研究人员和实践者。2)本综述提供了一个易于理解且高度结构化的视频领域SAM分类法,将现有方法分为三个主要类别(即视频理解、视频生成和视频编辑),这与以往的综述有显著不同。3)我们提供了全面的性能评估,并深入分析了这些前沿方法的优缺点,以帮助读者选择适合其特定应用的基准,并提供改进现有方法的宝贵见解。此外,我们基于系统的文献综述和全面的性能评估,提出了一些潜在的未来发展趋势。

本综述的主要贡献有三点: 我们全面回顾了基础模型时代的视频领域SAM的发展,并对该领域的最新进展进行了系统性综述,归纳为视频理解、视频生成和视频编辑三个主要类别。据我们所知,这是首个专注于这一特定领域的系统性综述。 我们全面比较了基于SAM的方法与当前代表性数据集上的最先进方法,尤其是对这些前沿方法的优缺点进行了深入分析,帮助读者为其特定应用选择合适的基准,并提供了改进现有方法的宝贵见解。 基于系统的文献综述和全面的性能评估,我们提出了一些潜在的未来发展趋势。

本综述的剩余部分组织如下:第二部分总结了背景知识,包括SAM和SAM 2的工作流程、研究路线及相关研究领域。第三部分主要概述了视频理解领域的SAM方法。第四部分深入探讨了视频生成领域的主要研究。第五部分阐述了视频编辑领域的SAM方法。第六部分介绍了基准数据集和评估方法。第七部分总结了本文,并强调了未来研究的潜在方向。

****

使用SAM进行视频理解

在本节中,我们主要介绍了使用SAM进行的各种视频理解任务,如图3所示。

**A. 视频对象分割

视频对象分割(VOS)是计算机视觉中的一项关键任务,用于分割视频中的主要对象。通过结合预训练的分割模型SAM,最近的工作在VOS中表现出巨大潜力。我们将其简要总结为语义级、实例级、全景级和实体级(见图4)。

- 视频语义分割:Zhang等人[20]首次采用SAM进行无监督的视频对象分割(VOS),无需人工注释即可执行分割。具体来说,他们在IDOL[96]中移除了掩码预测分支,使其适应为一种新颖的视频显著对象跟踪方法,旨在发现显著对象及其时空轨迹。然后,他们将生成的轨迹作为提示与SAM结合,以逐帧获取掩码结果。

此外,利用SAM出色的分割能力进行的一次性对象分割在图像分割和视频分割中也表现良好。Liu等人[14]提出了一种无训练框架,Matcher,用于一次性对象分割。他们集成了一个通用特征提取模型(例如DINOv2[10]、CLIP[97]和MAE[98])和一个与类别无关的分割模型(即SAM),通过三种操作实现可控的掩码生成。随后,Zhang等人[19]介绍了一个无需训练的个性化SAM,称为PerSAM,以SAM仅分割用户提供的对象。具体来说,他们首先通过用户提供的图像和掩码获得目标对象的位置置信度图。然后,基于置信度,他们提出了目标引导的注意力和目标语义提示,以帮助SAM的解码器进行个性化分割。此外,他们还提供了一个微调变体PerSAM-F,仅需10秒钟的2个参数来缓解掩码歧义问题。这些方法都可以用于逐帧设置的图像和视频对象分割。

除了这些,Chang等人[64]在PVUW2023 VSS轨道中采用SAM作为语义分割的后处理技术。Zhou等人[65]提出了一个新颖的移动对象分割(MOS)数据集,称为DSEC-MOS,具有高时间分辨率和低延迟的信息变化,以促进MOS的研究。

视频实例分割:为了解决SAM存在的掩码边界粗糙和预测不准确的问题,Ke等人[16]提出了HQ-SAM,为SAM配备了更准确地分割任何对象的能力。具体来说,他们引入了一个轻量级的高质量输出Token来替换原始SAM的输出Token,并通过全局-局部特征融合来融合全局语义上下文和局部边界细节。他们固定预训练模型参数以保持SAM的原始性能,并仅在他们构建的数据集上训练了44K精细掩码的引入组件的少量参数。

视频全景分割:端到端视频分割模型在大词汇表设置中的表现不佳是一个重要挑战。在大词汇表数据集VIPSeg[99]中,最近的一项工作[100]在视频全景质量得分上仅达到26.1。Cheng等人[66]指出,类别和场景数量的增加使得很难通过端到端训练取得良好表现。因此,他们提出了一种解耦视频分割方法 (DEVA),通过特定任务的图像级分割和与类别/任务无关的双向时间传播来实现。具体来说,SAM用于图像级分割,采用包含目标域外数据的通用数据训练。通过首帧分割,他们在未来几帧中降噪误差,以达成共识作为输出分割。然后,将XMem[101]作为时间传播模型适配,将分割传播到后续帧。VIPSeg上的大量实验验证了其在大规模视频全景分割中的有效性。

视频实体分割:图像/视频分割任务的野外设置对现有方法是一个重大挑战,其中没有对域、类别、图像分辨率和质量进行限制[67]。尽管实体分割旨在分割训练集中未见过的类别,但缺乏实体分割数据集使得在此任务上取得良好进展变得困难。为填补这一空白,Qi等人[67]构建了一个高质量的大规模实体分割数据集,称为EntitySeg。该数据集包含33,227张图像,具有多域和多分辨率的高质量标注掩码,允许评估模型的泛化能力和鲁棒性。他们对现有模型进行了基准测试,发现这些模型无法很好地适应所提出的数据集。因此,他们进一步提出了CropFormer[67]框架来解决这个问题。

**B. 视频对象跟踪

视频对象跟踪(VOT)是计算机视觉中的一项基础任务。我们将使用SAM的VOT方法分为四组:(1)通用对象跟踪,(2)开放词汇跟踪,(3)点跟踪和(4)夜间无人机(UAV)跟踪。(1)最近,SAM强大的分割能力增强了对对象的感知,并促进了通用对象跟踪的发展。Yang等人[23]提出了基于SAM的无训练轨迹任意模型(TAM),实现了视频中的高性能交互式跟踪和分割。具体来说,他们首先使用SAM获取对象的初始掩码,用户可以通过点击选择目标对象或修改掩码。然后,他们采用XMem对后续帧进行VOS,使用用户选择的掩码。为了避免XMem随时间推移分割越来越粗糙的问题,他们再次使用SAM进行精细化。Cheng等人[27]提出了SAM-Track,用于分割和跟踪视频中的任何对象。他们结合SAM获取分割,Grounding-DINO理解自然语言,DeAOT[102]进行跟踪。在VOTS2023挑战中,Zhu等人[68]提出的HQTrack获得了第二名,达到了高质量的VOT。他们的框架具体实现了DeAOT和SAM的改进变体(即HQ-SAM[16])用于多对象分割和掩码精细化。TREK-150对象跟踪挑战的第一名解决方案[103]也采用了类似的结合SAM和DeAOT的方法。他们引入了MSDeAOT作为DeAOT的改进变体,通过用参考帧中的掩码替换边框并将掩码和帧输入VOS模型。(2)Chu等人[69]利用SAM作为分割器,结合开放词汇对象检测器和光流估计,构建了一个零样本开放词汇视觉跟踪框架OVTracktor。(3)提出了SAM-PT[70],利用VOS的稀疏点传播。以带有第一帧点注释的视频作为输入,SAM-PT可以通过点跟踪器生成轨迹作为提示,并使用SAM输出预测掩码,从而实现强大的零样本性能。预测的掩码还用于重新初始化并去除不可靠的点。(4)Yao等人[26]利用SAM进行实时夜间无人机跟踪,以准确定位潜在对象并从夜间图像中确定高质量的目标域训练样本。

**C. Deepfake检测

在最近的一项研究中,Lai等人[30]探讨了SAM及其变体在Deepfake检测和定位中的性能评估,这是首次评估这些方法在特定任务中的表现。研究人员指出,现有的方法(使用LoRA[104]、SAM适配器[4]和可学习提示[105]对SAM进行微调以适应下游任务)在面部伪造定位方面的表现往往不理想,特别是在本地和全局上下文的伪造建模能力方面。为了应对这些挑战,Lai等人[30]提出了一个创新框架,称为detect any deepfakes(DADF),基于SAM构建。具体来说,他们在SAM中引入了一个多尺度适配器,旨在捕捉短期和长期伪造上下文,促进高效的微调。此外,他们还引入了一个重建引导的注意模块,以增强伪造痕迹并提高模型对伪造区域的敏感性。所提出的方法在伪造检测和定位方面表现出了最先进的性能。

**D. 视频阴影检测

视频阴影检测在各种应用中起着至关重要的作用,包括对象检测[106]、图像分割[107]和虚拟现实场景生成[108]。然而,训练数据的有限性导致现有基于深度神经网络的方法的泛化能力受到挑战,这可能导致预测误差在视频传播过程中积累[109]。特别是,当将SAM应用于单帧阴影检测时,SAM倾向于将阴影分类为背景的一部分[18]。这给使用SAM进行阴影检测带来了不小的挑战,因为它需要弥合自然对象和复杂阴影之间的差距。为了解决这一挑战,Wang等人[18]引入了ShadowSAM,这是一个简单但有效的框架,专门用于对SAM进行微调以适应阴影检测。此外,通过采用长短期注意机制,他们扩展了其在高效视频阴影检测中的能力。

**E. 其他

-

音频-视觉分割:最近,SAM被应用于音频-视觉定位和分割[17],[71]。这两项研究都集中在克服音频-视觉定位和分割中的挑战,特别是解决音频与视频中各种对象之间固有的不对齐问题。在[17]中,作者通过引入AV-SAM,提出了一种方法,能够为视频中的每个掩码提示学习音频对齐的视觉特征。这有助于通过像素级音频-视觉融合引导SAM生成掩码。该方法利用了SAM中预训练的图像编码器中的音频特征和视觉特征,以聚合跨模态表示。相反,Wang等人[71]提出了一种编码器-提示-解码器范式,以解决数据稀缺和数据分布不均的问题。他们利用预训练模型的丰富知识,提出了一种语义感知音频提示,以帮助视觉基础模型聚焦于发声的对象。同时,该方法鼓励减少视觉和音频模态之间的语义差距。此外,Bhosale等人[72]提出了CMSF,这是一种利用音频线索生成音频标签并随后提出分割掩码的方法。这些最新的进展突显了SAM在解决与音频-视觉处理相关的复杂任务中的多功能性。

-

视频对象指代分割:尽管SAM因其在图像分割中的出色表现而广受关注,但[73]中讨论的一项研究突出了SAM在视频对象指代分割(RVOS)领域的局限性。这种局限性源于对用户交互提示的精确性要求,以及对不同模态(如语言和视觉)的有限理解。为了有效地将SAM用于RVOS并充分释放其在视频分割和多模态融合中的潜力,Li等人进行了开创性的研究[73]。他们通过集成来自不同模态和不同时刻的多视图信息,探讨了SAM在RVOS中的潜力。作者引入了RefSAM,这是一种新颖的方法,利用轻量级模块和高效的微调策略,以端到端学习的方式对齐和融合语言和视觉特征。此外,他们设计了一个分层密集注意模块,以利用多层次的视觉和文本特征,从而实现不同尺寸对象的有效跨模态分割。

**F. 特定领域

-

医学视频:SAM也为医学视频的分析做出了贡献。针对SAM原始流程的两个问题(即域间隔和对精确点或框位置的依赖),SurgicalSAM[74]引入了一种新颖的端到端高效微调方法,旨在无缝地将手术特定信息与SAM的预训练知识结合,以增强整体泛化能力。该工作[110]全面探讨了机器人手术的不同场景,并评估了SAM的鲁棒性和零样本泛化能力。SAMSNeRF[75]结合了SAM和神经辐射场(NeRF)技术,使用SAM生成手术工具的精确分割掩码,然后通过NeRF引导动态手术场景重建的优化。Fillioux等人[111]评估了SAM在处理患者来源的类器官显微镜帧中的表现。MediViSTA-SAM[5]是首个将SAM适用于视频分割的研究。SuPerPM[76]是一种大型变形鲁棒的手术感知框架,利用SAM将组织区域从背景中分割出来。

-

域适应:最近,研究人员利用SAM增强了模型在目标域中的泛化能力,特别是在目标域数据的质量和数量不理想的情况下。Bonani等人[77]利用SAM为真实数据提供正则化信号,并引入了一个不变性-变异性损失结构。该结构用于对无标注的目标域数据进行自监督学习,促进语义分割网络的域适应能力的鲁棒性。Yao等人[26]提出了SAM-DA,一种基于SAM的域适应框架,旨在用于实时夜间无人机跟踪。他们引入了一种创新的SAM驱动方法,从每张夜间图像生成大量高质量的目标域训练样本,从而显著增加了目标域训练样本的数量和质量,为域适应提供了更好的数据支持。

-

工具软件:Hsieh等人[78]探讨了利用工具文档而非演示文档来指导大语言模型(LLMs)使用新工具的可能性。文章[78]表明,使用工具文档使得LLMs能够以零样本的方式使用SAM,而无需进行训练或微调。同样重要的是,文章展示了利用工具文档启用新应用的潜力。一个这样的例子是将GroundingDino[7]与SAM结合,创建了Grounded-SAM[112],这是一种能够在视觉内容中生成与文本相关的模型,展示了从图像中提取有意义的文本信息的能力。

-

更多方向:几项研究将SAM应用于各种应用,涵盖了光流估计[79]、机器人学[80],[83],[113]、用于视频游戏的强化学习(RL)[82]以及语义通信[81]。

为了解决光流估计中的“碎片化”挑战,Zhou等人[79]使用SAM作为图像编码器,为光流估计提供了更丰富和更高层次的上下文特征。这一策略减少了模型专注于局部和低层次线索的倾向。在Yang等人的工作[80]中,SAM用于生成对象的分割掩码,为模型提供丰富的语义、几何和形状先验。这反过来有助于机器人感知物体姿势并确定抓取点。类似的想法也见于[83],[113]。在[82]中,作者使用SAM增强了原始像素输入,旨在提高RL代理在Atari视频游戏中的表现。尽管观察到RL代理的游戏表现有所改善,但在性能提升与计算成本之间找到适当的平衡仍然是一个持续探索的问题。此外,Raha等人[81]提出了一种基于SAM的新颖语义通信框架,在保持原始内容不变的情况下高效地传输序列图像或视频。

VII. 结论与未来方向

**A. 结论

本综述深入探讨了基础模型时代的最新发展,重点关注了视频领域的SAM。根据我们的了解,这是第一篇系统且全面的综述,专注于这个特定且前景广阔的研究领域。我们首先总结了视频领域的独特挑战,强调了视频任务的极端复杂性以及对视频领域SAM模型的系统性综述的迫切需求。随后,我们概述了SAM和SAM 2、不同的研究路线以及与视频相关的研究领域。

在此基础上,我们详尽地回顾了现有的研究工作,并将其分为三个关键领域:视频理解、视频生成和视频编辑,考虑了它们各自的技术视角和研究目标。此外,我们还提供了基于SAM的方法与当前最先进方法在各种视频任务中的比较结果,并附有许多有见地的观察。

**B. 未来方向

通过我们的调查和深入评估,我们发现尽管SAM模型(包括SAM 2)在各种图像和视频任务中取得或正在取得重大突破,但仍存在许多机遇和挑战。我们在以下几个方面提供了视频领域及其他领域的SAM未来研究方向: * 构建大规模视频数据集:视觉基础模型的显著成就主要归因于数十亿高质量图像数据的可用性。然而,考虑到数据收集和标注的巨大成本,目前的视频任务通常限于相对小规模的数据集。例如,VOT数据集TrackingNet[159]包含30,643个视频和1443万帧,但其显著缺点是注释稀疏。利用SAM自动生成视频的密集掩码注释是实现数据扩展的潜在解决方案[24]。

构建大规模视频基础模型:目前的大多数视觉基础模型主要集中在图像级别的预训练和适应,这显然在复杂和动态的视频级别理解任务中受限。由于越来越方便的收集和存储,视频正逐渐成为边缘设备和互联网中的一个领域力量[22]。因此,为广泛的视频应用开发视频基础模型,例如医疗视频基础模型,成为了一个紧迫的需求。

参数高效的训练和快速推理:从头开始训练具有数十亿参数的视频基础模型必然面临高数据维度和高计算开销的重大挑战。虽然有些研究尝试通过利用预训练模型探索新技术,例如适配器[4]和提示学习[160],以促进高效的迁移学习,但仍迫切需要减轻训练和推理的开销。更高效的训练策略和模型压缩方法可能会在计算资源有限的边缘设备(例如汽车和手术机器人)上释放视频基础模型的更多潜力。

结合更多模态:尽管当前的基础模型在单一模态和双模态(例如视觉与文本、视觉与音频)方面取得了显著进展,但整合更多模态的研究仍远未深入。一个核心原因是缺乏大规模对齐的多模态数据[2]。一方面,收集多模态数据,例如视觉图像、文本、音频、点云、红外图像、深度图像和事件流,对于研究多模态基础模型至关重要。另一方面,开发一个无需配对多模态数据的统一模型[12]是一个有前景的方向。 * 可信且可解释的视频基础模型:人工智能的安全性在实际应用中引发了重大关注,例如面部识别和自动驾驶中的隐私泄露和安全风险。然而,视频基础模型抵御各种攻击[29]的能力仍远未得到充分研究。此外,由于视频基础模型的高复杂性和快速增长的部署[3],提高其可解释性并增强人们对决策的信任是未来研究的一个有价值方向。

视频领域SAM的更多创新机会:由于视频领域的SAM是一个快速发展的研究领域,我们可能无法涵盖本综述中的所有最新进展。实际上,有大量视频任务尚未被SAM覆盖或未被充分研究,例如视频字幕生成、基于视频的事件检测、基于视频的行为/动作识别、视频摘要生成和视频帧插值。最后但同样重要的是,将SAM与大量传统技术/方法(如知识蒸馏和图学习)以及前沿技术/方法(如视频扩散模型、可解释AI(XAI)和具身AI)结合起来,可能会由于SAM的多功能性和即插即用特性在基础模型时代激发更多机会。