简介:

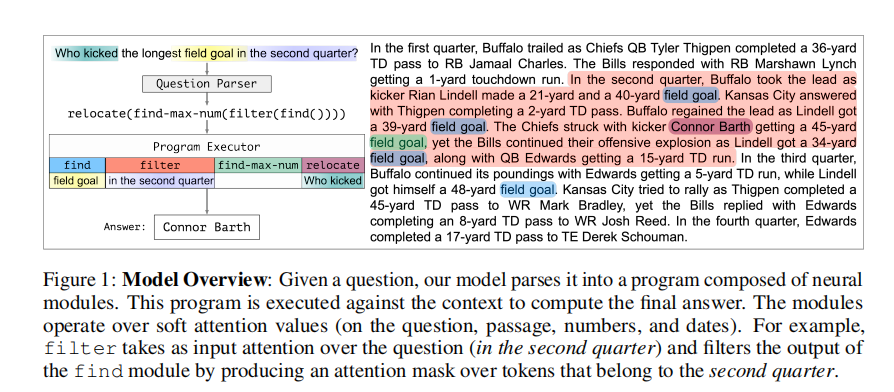

回答需要针对文本进行推理的多个步骤的构想问题具有挑战性,尤其是当它们涉及离散的象征性操作时。神经模块网络(NMN)学习解析诸如由可学习模块组成的可执行程序之类的问题,它们在合成视觉质量检查域中表现良好。但是,我们发现在开放域文本中针对非合成问题学习这些模型具有挑战性,在这种模型中,模型需要处理自然语言的多样性并进行更广泛的推理。我们通过以下方式扩展NMN:(a)引入对一段文本进行推理的模块,以概率和可微分的方式对数字和日期执行符号推理(例如算术,排序,计数); (b)提出无监督的损失,以帮助提取与文本中的事件相关的参数。此外,我们显示出有限的启发式获得的问题程序和中间模块输出监督为准确学习提供了足够的归纳偏差。我们提出的模型大大优于DROP数据集的子集上的最新模型,后者构成了我们模块所涵盖的各种推理挑战。

成为VIP会员查看完整内容

相关内容

加州大学伯克利分校(University of California, Berkeley),是美国最负盛名且是最顶尖的一所公立研究型大学,位于旧金山东湾伯克利市的山丘上。创建于1868年,是加州大学十个分校中历史最悠久的一所。加州大学伯克利分校在世界范围内拥有崇高的学术声誉,拥有丰富的教学资源,研究水平非常坚厚,与斯坦福大学、麻省理工学院等一同被誉为美国工程科技界的学术领袖。

专知会员服务

44+阅读 · 2020年6月29日

专知会员服务

37+阅读 · 2020年4月10日

专知会员服务

37+阅读 · 2020年3月14日

专知会员服务

76+阅读 · 2020年1月16日

专知会员服务

49+阅读 · 2019年11月15日

Arxiv

5+阅读 · 2018年5月23日

Arxiv

4+阅读 · 2018年1月26日