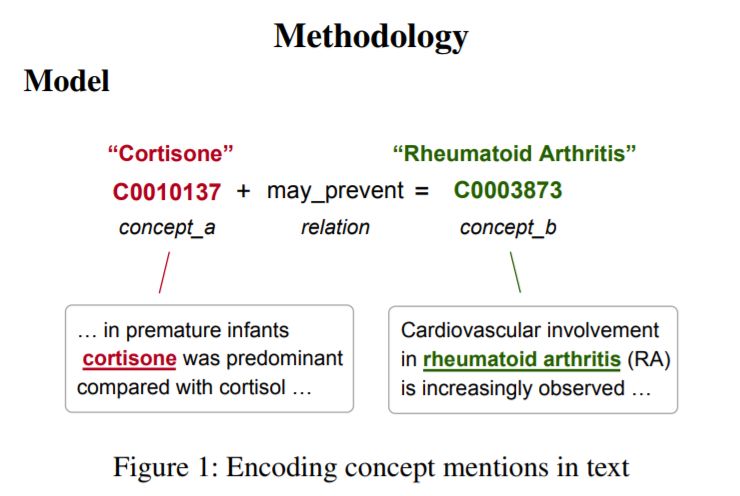

对于自然语言理解任务来说,外部知识通常是有用的。我们介绍了一个上下文文本表示模型,称为概念上下文(CC)嵌入,它将结构化的知识合并到文本表示中。与实体嵌入方法不同,我们的方法将知识图编码到上下文模型中。就像预先训练好的语言模型一样,CC嵌入可以很容易地在广泛的任务中重用。我们的模型利用语义泛化,有效地编码了庞大的UMLS数据库。在电子健康记录(EHRs)和医疗文本处理基准上的实验表明,我们的模型大大提高了监督医疗NLP任务的性能。

成为VIP会员查看完整内容

相关内容

专知会员服务

76+阅读 · 2020年1月16日

专知会员服务

64+阅读 · 2020年1月11日

专知会员服务

49+阅读 · 2019年11月15日

专知会员服务

80+阅读 · 2019年11月5日

Arxiv

10+阅读 · 2020年3月12日

Arxiv

12+阅读 · 2019年9月26日

Arxiv

7+阅读 · 2019年2月3日

Arxiv

3+阅读 · 2018年2月1日