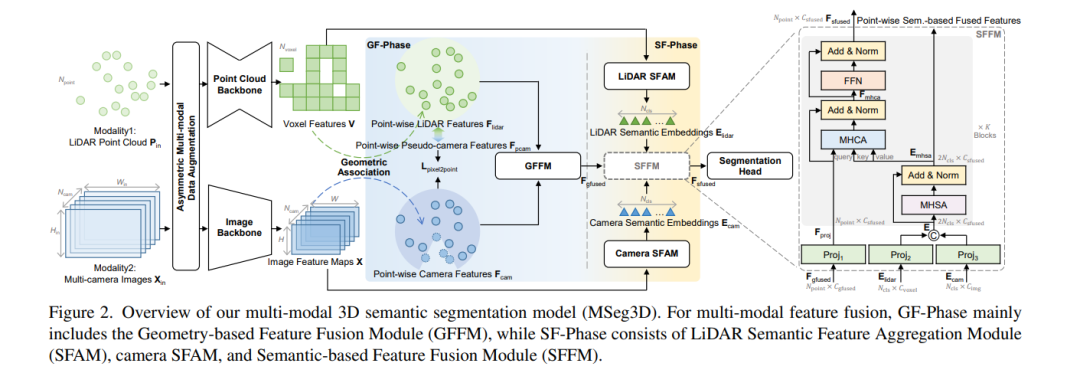

激光雷达和相机是自动驾驶中可用于3D语义分割的两种模态。由于激光点不足,流行的仅用激光雷达的方法在小而远的目标上存在严重的分割问题,而鲁棒的多模态解决方案尚未得到充分探索,**本文研究了三个关键的内在困难:模态异质性、有限的传感器视场交叉点和多模态数据增强。为此,提出一种联合模态内特征提取和模态间特征融合的多模态3D语义分割模型(MSeg3D)。**MSeg3D中的多模态融合包括所有可见点上基于几何的特征融合GF-Phase、跨模态的特征补全和基于语义的特征融合SF-Phase。通过对LiDAR点云和多相机图像分别应用非对称变换来重新激活多模态数据增强,这有利于通过多样化的增强变换进行模型训练。MSeg3D在nuScenes, Waymo和SemanticKITTI数据集上取得了最先进的结果。在故障多摄像机输入和多帧点云输入下,MSeg3D仍然表现出鲁棒性,并改善了LiDARonly基线。我们的代码通过https: //github.com/jialeli1/lidarseg3d公开。

成为VIP会员查看完整内容

相关内容

CVPR 2023大会将于 6 月 18 日至 22 日在温哥华会议中心举行。CVPR是IEEE Conference on Computer Vision and Pattern Recognition的缩写,即IEEE国际计算机视觉与模式识别会议。该会议是由IEEE举办的计算机视觉和模式识别领域的顶级会议,会议的主要内容是计算机视觉与模式识别技术。

CVPR 2023 共收到 9155 份提交,比去年增加了 12%,创下新纪录,今年接收了 2360 篇论文,接收率为 25.78%。作为对比,去年有 8100 多篇有效投稿,大会接收了 2067 篇,接收率为 25%。

Arxiv

11+阅读 · 2023年3月10日