题目: Breaking the interpretability barrier - a methodfor interpreting deep graph convolutional models

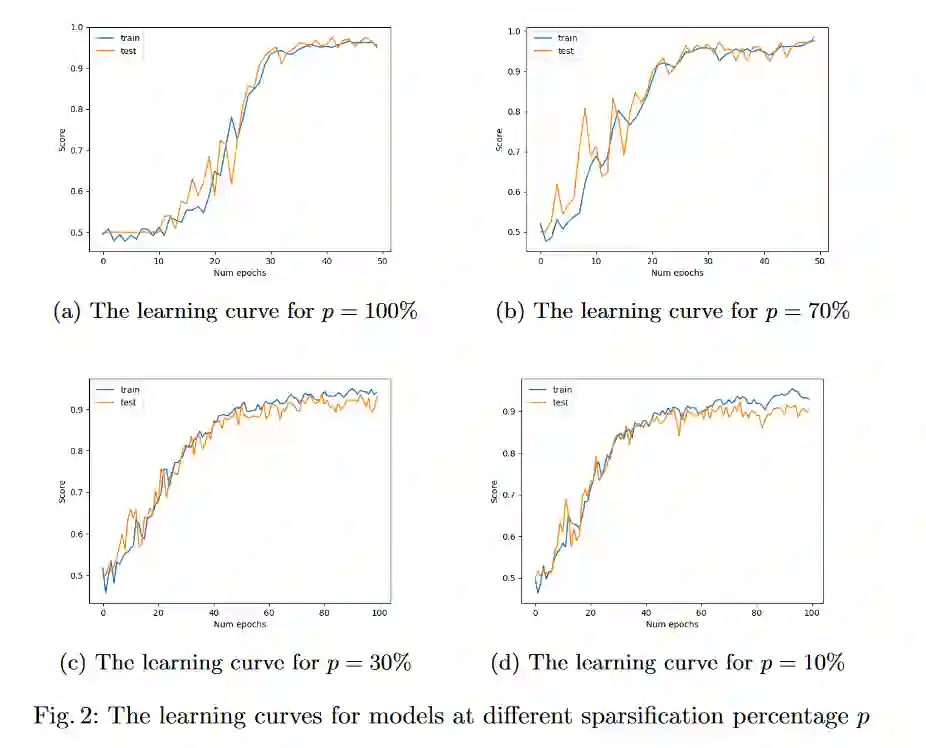

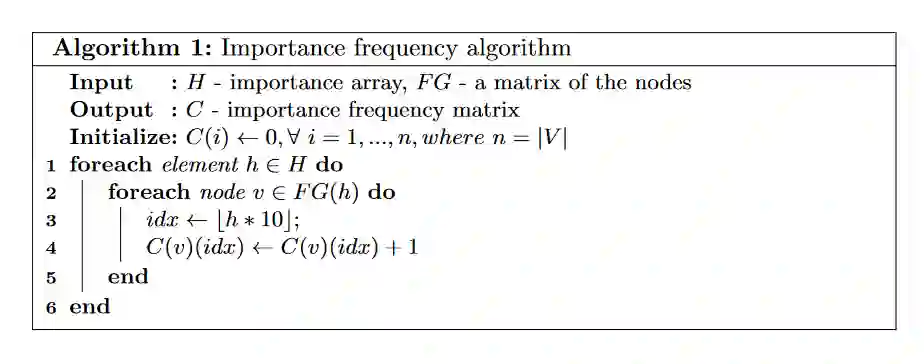

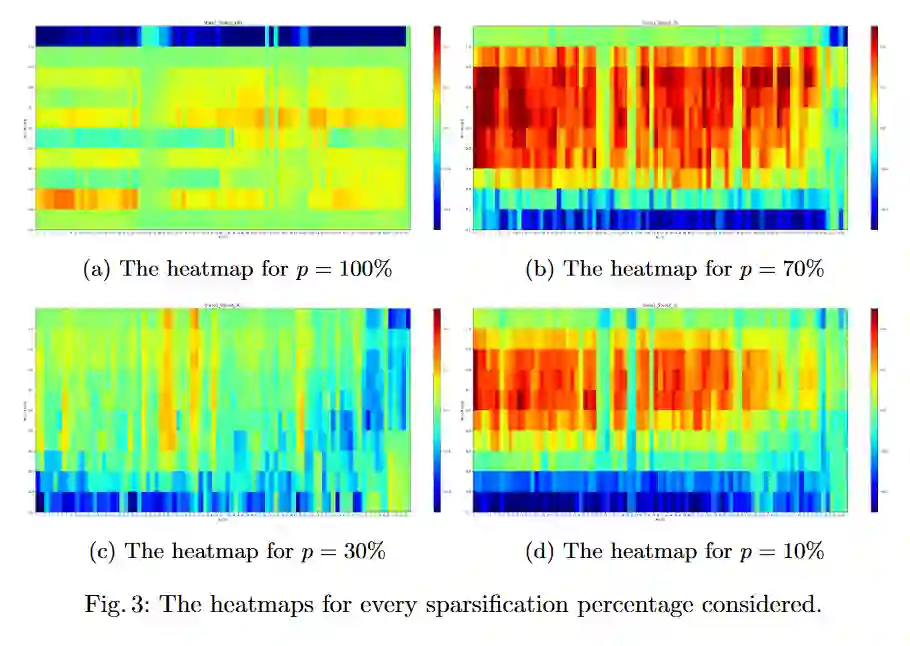

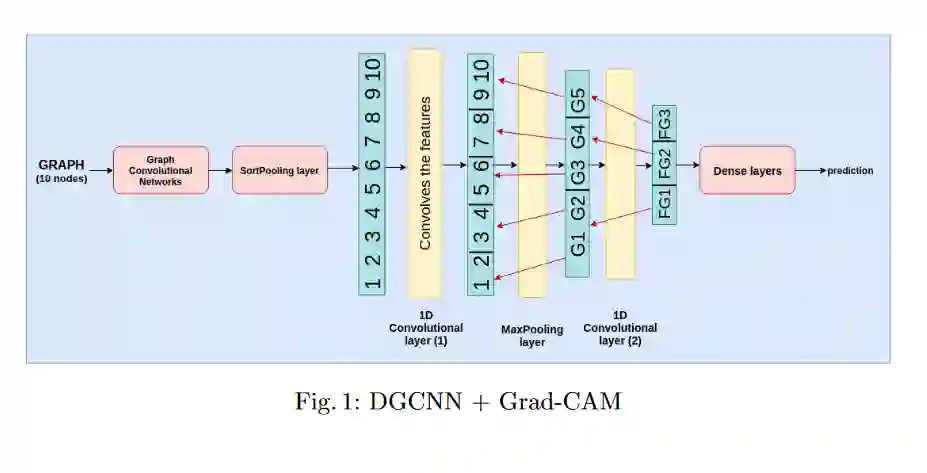

摘要: 与基于图像的卷积网络相比,图卷积神经网络的可解释性具有更大的挑战性,因为图的节点之间没有显示出清晰的空间关系(就像图像一样)。本文探讨了一种计算图卷积分类模型节点相关信息的方法。为此,我们采用梯度CAM算法,通过替换图像中严重依赖像素二维空间关系的部分,在梯度CAM结果中通过其外观计数来估计节点的重要性。我们的策略是针对具有相关领域特定假设的现实问题而定义的;因此,我们另外提出了一种系统生成人工数据的方法,该方法与现实数据具有相似的属性,以评估学习过程和解释方法的通用性。实际数据用完整的加权图表示。通过应用稀疏化策略,初步的结果表明图中的信息节点可以被识别。

作者简介: Raul Cristian Muresan,博士,克鲁伊·纳波卡特兰西瓦尼亚神经科学研究所实验和理论神经科学实验室主任(罗马尼亚)。特兰西瓦尼亚神经科学研究所董事会主席克鲁·纳波卡(罗马尼亚)。法兰克福马克斯普朗克脑研究所附属研究员(德国)。等

成为VIP会员查看完整内容

相关内容

Raul Cristian Muresan,博士,克鲁伊·纳波卡特兰西瓦尼亚神经科学研究所实验和理论神经科学实验室主任(罗马尼亚)。特兰西瓦尼亚神经科学研究所董事会主席克鲁·纳波卡(罗马尼亚)。法兰克福马克斯普朗克脑研究所附属研究员(德国)。

专知会员服务

32+阅读 · 2020年6月11日

专知会员服务

49+阅读 · 2020年1月1日

专知会员服务

15+阅读 · 2019年12月3日