用深度学习揭示数据的因果关系

【导读】ICLR2019上主要集中在解决深度学习中的四个主要挑战:公平,安全,普遍性和因果关系。 我们已经讨论了当前状态下的机器学习算法是如何有偏见的,容易受到对抗性攻击的影响,以及他们在多个应用程序的训练数据集中找到的模式概括的能力极其有限。 现在,研究界正忙于努力使技术足够复杂以减轻这些弱点。

因果关系

机器学习非常适合在数据中找到相关性,但是它能否找出因果关系? 这样的成就将是一个巨大的里程碑:如果算法可以帮助我们阐明复杂系统中不同现象的原因和影响,它们将加深我们对世界的理解并解锁更强大的工具来影响它。知名研究员LéonBottou(现在Facebook的人工智能研究部门和纽约大学)设立了一个新的框架,他正在与合作者一起研究如何实现这一目标。

思考因果关系的新方法

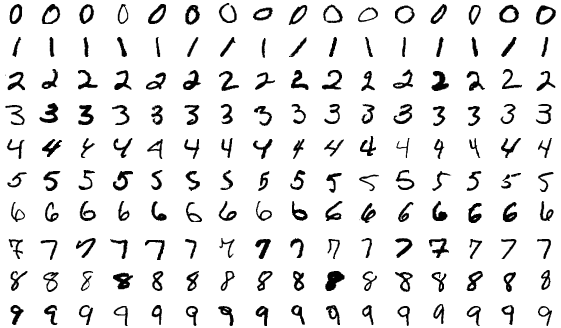

Bottou和他的团队的第一个重要思想:一种思考因果关系的新方法。 假设您想构建一个识别手写数字的计算机视觉系统。你将在大量的手写数字图像上训练一个神经网络,每个图像用它们代表的数字标记,最后得到可以发现用于识别以前从未见过数字的新系统。

但是,假设训练数据集略有修改,每个手写数字也被涂上红色或绿色。

假设你不知道是颜色还是形状影响了分类结果,简单地整张图片并将它们输入神经网络,用于预测最后的数字。

事情变得有趣。 “有色MNIST”数据集会误导模型。回到现实世界,我们知道标记的颜色与其内容完全不相关,但在这个特定的数据集中,颜色才起了主要的作用,而不是形状。因此,我们的神经网络学习使用颜色作为主要预测因子。当我们使用网络识别遵循相同着色模式的其他手写数字时,这完全没问题。但是当我们颠倒数字的颜色时,表现完全不行。 (当Bottou和他的合作者用真实的训练数据和真实的神经网络进行这个思想实验时,他们在前一种情况下获得了84.3%的识别准确率,在后者中获得了10%的准确性。)

换句话说,神经网络发现了Bottou所谓的“虚假相关”,这使得它在训练它的狭窄环境之外完全无用。从理论上讲,如果你能够摆脱机器学习模型中的所有虚假关联,那么你将只留下“不变”的那些 - 无论上下文如何都是如此。

Bottou解释说,不变性反过来会让你理解因果关系。如果您知道系统的不变属性并知道在系统上执行的干预,您应该能够推断出干预的后果。例如,如果您知道手写数字的形状总是决定其含义,那么您可以推断改变其形状(原因)会改变其含义(效果)。另一个例子:如果你知道所有物体都受到万有引力定律的影响,那么你可以推断出当你放开一个球(原因)时,它会落到地上(效果)。

显然,这些是基于我们已经知道的不变属性的简单因果实例,但想想我们如何将这个想法应用于我们还不了解的更复杂的系统。例如,如果我们能够找到经济系统的不变属性,那么我们能够理解实施普遍基本收入的效果怎么办?或者地球气候系统的不变属性,我们可以评估各种地球工程的影响吗?

摆脱虚假的相关性

那么我们如何摆脱这些虚假的相关性呢?这是Bottou团队的第二个重要创意。在当前的机器学习实践中,默认的直觉是将尽可能多的多样化和有代表性的数据聚集到单个训练集中。但是Bottou说这种方法有害。来自不同背景的不同数据 - 无论是在不同时间,在不同位置还是在不同实验条件下收集 - 应该作为单独的集合而不是混合和组合来保存。当它们合并时,就像现在一样,重要的上下文信息会丢失,从而导致虚假相关的可能性更高。

对于多个特定于上下文的数据集,训练神经网络是非常不同的。网络没必要找到一个单独的训练数据集中成立的相关性;它必须找到所有不同数据集中不变的相关性。如果从各种情境中巧妙地选择这些集合,那么最终的相关性也应该与地面实况的不变性质紧密匹配。

让我们再一次回到我们简单的彩色MNIST示例。利用他们寻找不变属性的理论,Bottou和合作者重新开始他们原来的实验。这次他们使用了两个彩色的MNIST数据集,每个数据集都有不同的颜色模式。然后,他们训练他们的神经网络,以找到两组之间保持一致的相关性。当他们在具有相同和反色图案的新数字上测试这个改进的模型时,它们两者的识别准确率达到70%。结果证明神经网络已经学会忽视颜色并仅仅关注标记的形状。

Bottou说他的团队在这些想法上的工作没有完成,研究界需要一些时间来测试比彩色数字更复杂的问题的技术。但该框架暗示了深度学习的潜力,以帮助我们理解事情发生的原因,从而使我们能够更好地控制自己的命运。

原文链接:

https://www.technologyreview.com/s/613502/deep-learning-could-reveal-why-the-world-works-the-way-it-does/

-END-

专 · 知

专知,专业可信的人工智能知识分发,让认知协作更快更好!欢迎登录www.zhuanzhi.ai,注册登录专知,获取更多AI知识资料!

欢迎微信扫一扫加入专知人工智能知识星球群,获取最新AI专业干货知识教程视频资料和与专家交流咨询!

请加专知小助手微信(扫一扫如下二维码添加),加入专知人工智能主题群,咨询技术商务合作~

专知《深度学习:算法到实战》课程全部完成!540+位同学在学习,现在报名,限时优惠!网易云课堂人工智能畅销榜首位!

点击“阅读原文”,了解报名专知《深度学习:算法到实战》课程