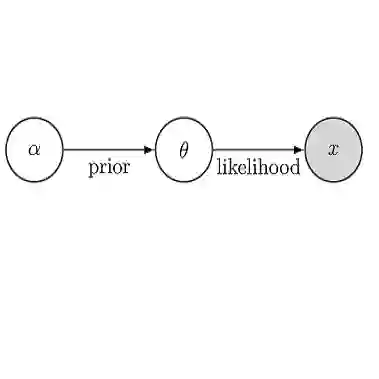

Bayesian inference without the likelihood evaluation, or likelihood-free inference, has been a key research topic in simulation studies for gaining quantitatively validated simulation models on real-world datasets. As the likelihood evaluation is inaccessible, previous papers train the amortized neural network to estimate the ground-truth posterior for the simulation of interest. Training the network and accumulating the dataset alternatively in a sequential manner could save the total simulation budget by orders of magnitude. In the data accumulation phase, the new simulation inputs are chosen within a portion of the total simulation budget to accumulate upon the collected dataset. This newly accumulated data degenerates because the set of simulation inputs is hardly mixed, and this degenerated data collection process ruins the posterior inference. This paper introduces a new sampling approach, called Neural Proposal (NP), of the simulation input that resolves the biased data collection as it guarantees the i.i.d. sampling. The experiments show the improved performance of our sampler, especially for the simulations with multi-modal posteriors.

翻译:在模拟研究中,没有进行概率评价,也没有进行无概率的推断,贝叶斯推论是获得真实世界数据集定量验证模拟模型的模拟研究中的一个关键研究课题。由于不可能获得可能性评估,以前的论文培训了摊销神经网络,以估计地真伪后部,进行利益模拟。培训网络和以顺序方式积累数据集,可以按数量级顺序节省整个模拟预算。在数据积累阶段,在总模拟预算的一部分中选择新的模拟投入,以积累已收集的数据集。这种新积累的数据退化是因为模拟投入的组合几乎无法混合,而这种退化的数据收集过程破坏了远地点的推断。本文介绍了一种新的取样方法,称为Neural Proposor(NP),即模拟输入解决偏差数据收集的方法,因为它保证i.i.d.采样。实验显示我们的取样器的性能有所改善,特别是用于多式后部的模拟。