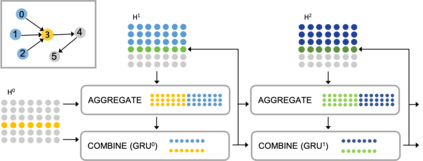

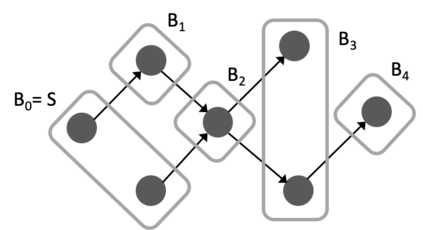

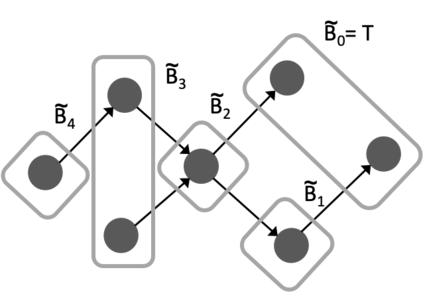

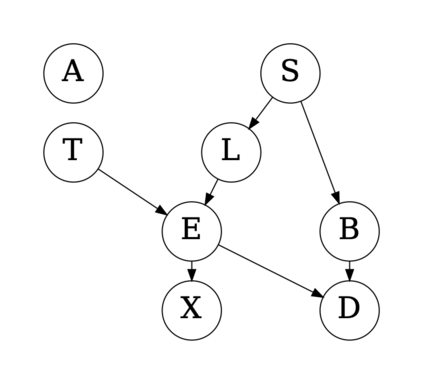

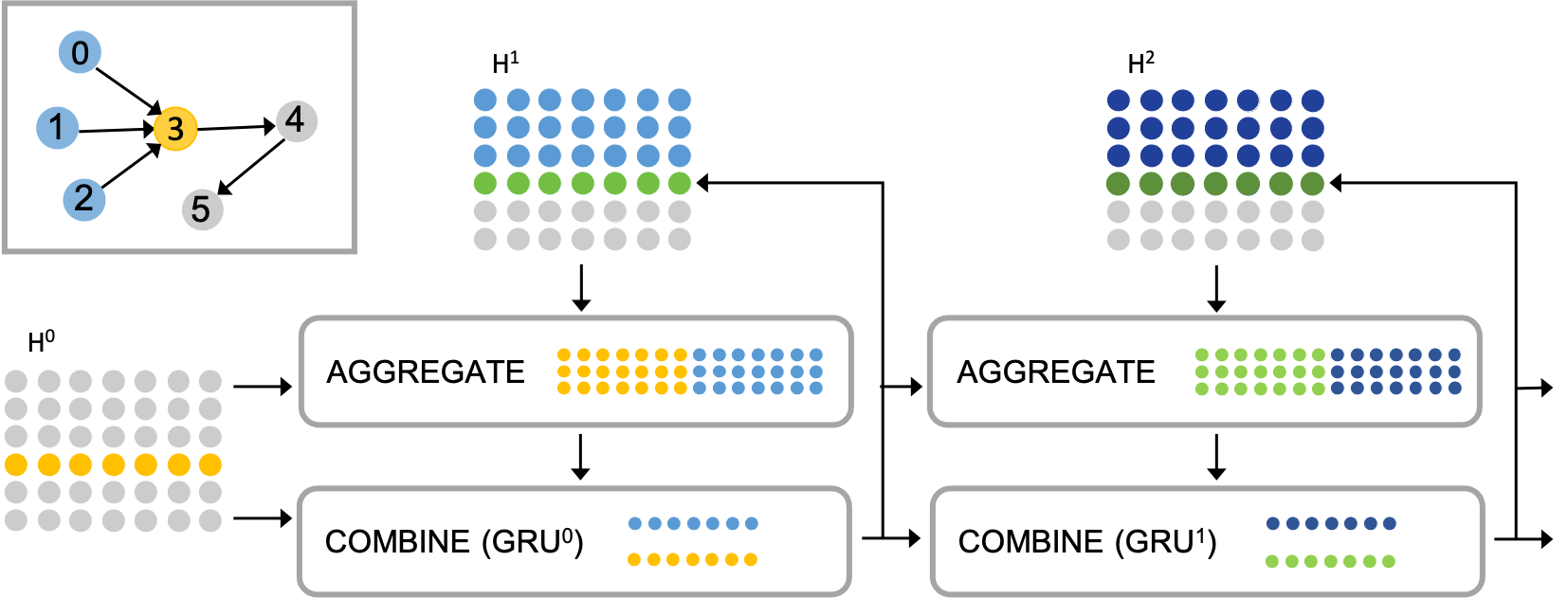

Graph-structured data ubiquitously appears in science and engineering. Graph neural networks (GNNs) are designed to exploit the relational inductive bias exhibited in graphs; they have been shown to outperform other forms of neural networks in scenarios where structure information supplements node features. The most common GNN architecture aggregates information from neighborhoods based on message passing. Its generality has made it broadly applicable. In this paper, we focus on a special, yet widely used, type of graphs -- DAGs -- and inject a stronger inductive bias -- partial ordering -- into the neural network design. We propose the \emph{directed acyclic graph neural network}, DAGNN, an architecture that processes information according to the flow defined by the partial order. DAGNN can be considered a framework that entails earlier works as special cases (e.g., models for trees and models updating node representations recurrently), but we identify several crucial components that prior architectures lack. We perform comprehensive experiments, including ablation studies, on representative DAG datasets (i.e., source code, neural architectures, and probabilistic graphical models) and demonstrate the superiority of DAGNN over simpler DAG architectures as well as general graph architectures.

翻译:图像神经网络(GNNs)旨在利用图表中显示的关系导导偏差;在结构信息补充节点特征的情景中,已经显示它们优于其他形式的神经网络。最常见的GNN架构根据传递的信息汇总了邻居的信息。它的概括性使它广泛适用。在本文中,我们侧重于特殊但广泛使用的图表类型 -- -- DAGs -- -- 并向神经网络设计中注入更强烈的感应偏差 -- -- 部分订购。我们建议了\emph{定向环球图神经网络},DAGNN是一个根据部分顺序定义的流程处理信息的架构。DAGNN可以被视为一个框架,它要求早期工作作为特殊案例(例如,树木模型和模型经常更新不偏重的表示方式),但我们确定了先前结构所缺乏的几个关键组成部分。我们进行了全面的实验,包括对有代表性的DAG数据设置(i.e.e.、源代码和图像结构)进行了全面实验,其中包括对有代表性的AGAGstor式模型(i.、更简单的图像和图像结构)进行更简单的图像分析。