【KDD2020】更深的图神经网络,Towards Deeper Graph Neural Networks

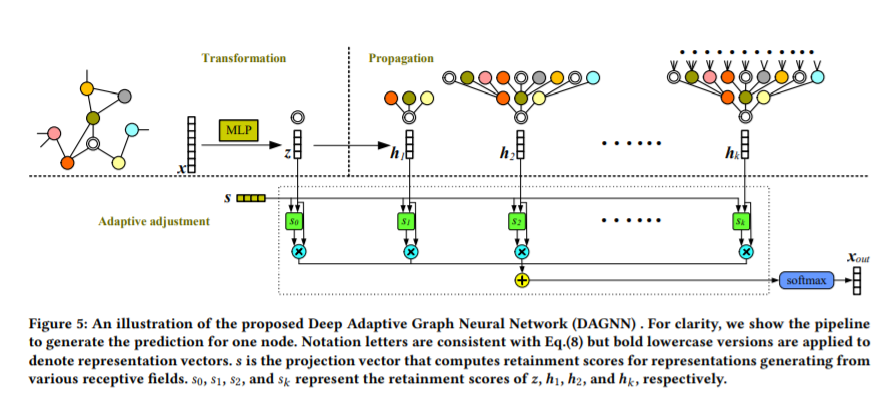

图神经网络在图表示学习领域取得了显著的成功。图卷积执行邻域聚合,并表示最重要的图运算之一。然而,这些邻域聚合方法的一层只考虑近邻,当进一步启用更大的接受域时,性能会下降。最近的一些研究将这种性能下降归因于过度平滑问题,即重复传播使得不同类的节点表示无法区分。在这项工作中,我们系统地研究这一观察结果,并对更深的图神经网络发展新的见解。本文首先对这一问题进行了系统的分析,认为当前图卷积运算中表示变换与传播的纠缠是影响算法性能的关键因素。将这两种操作解耦后,更深层次的图神经网络可用于从更大的接受域学习图节点表示。在建立深度模型时,我们进一步对上述观察结果进行了理论分析,这可以作为过度平滑问题的严格而温和的描述。在理论和实证分析的基础上,我们提出了深度自适应图神经网络(DAGNN),以自适应地吸收来自大接受域的信息。一组关于Citation、合著和共购数据集的实验证实了我们的分析和见解,并展示了我们提出的方法的优越性。

https://arxiv.org/abs/2007.09296

专知便捷查看

便捷下载,请关注专知公众号(点击上方蓝色专知关注)

后台回复“DGNN” 可以获取《【KDD2020】更深的图神经网络,Towards Deeper Graph Neural Networks》专知下载链接索引

登录查看更多

相关内容

专知会员服务

137+阅读 · 2020年7月29日