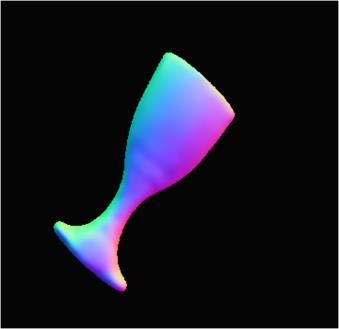

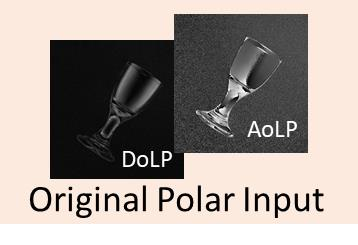

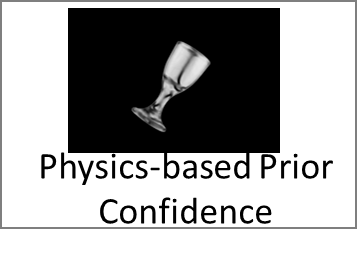

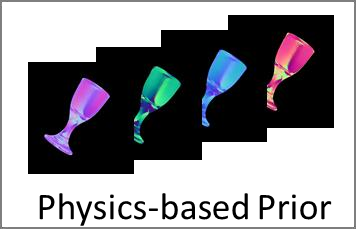

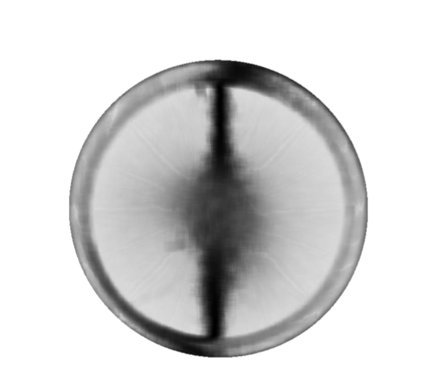

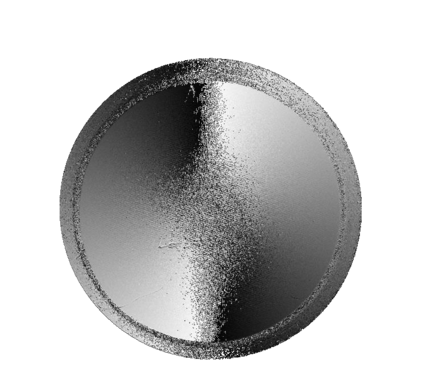

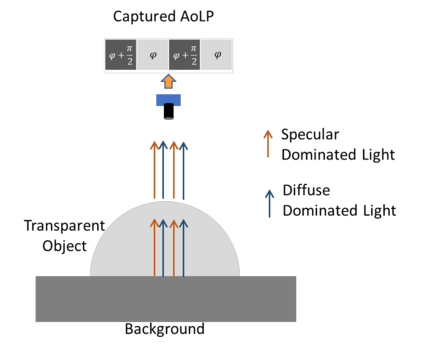

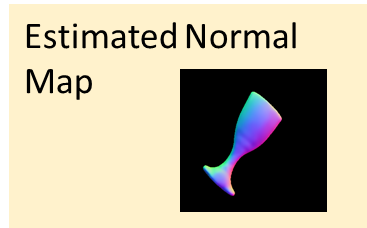

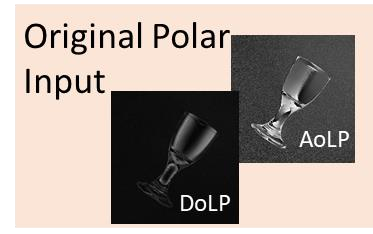

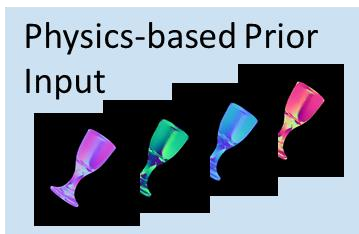

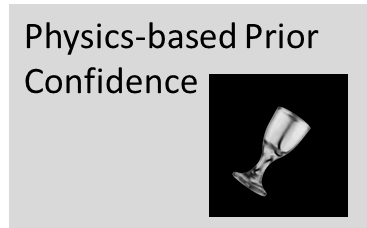

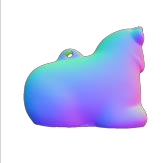

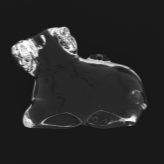

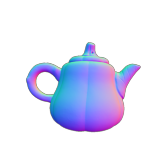

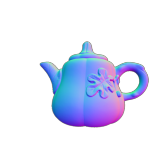

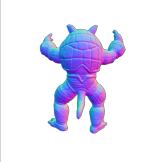

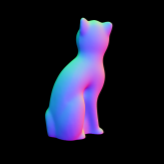

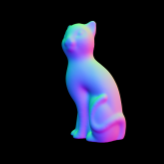

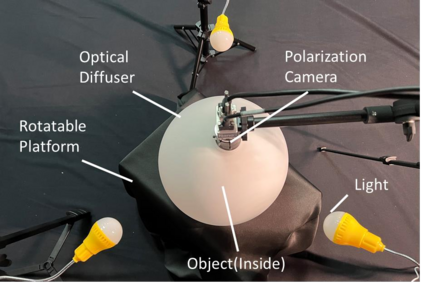

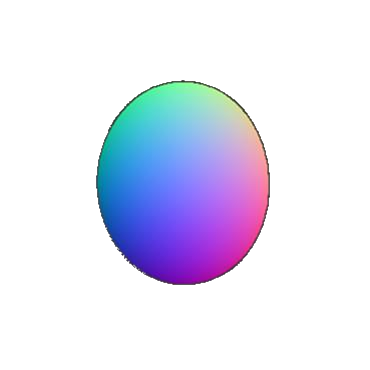

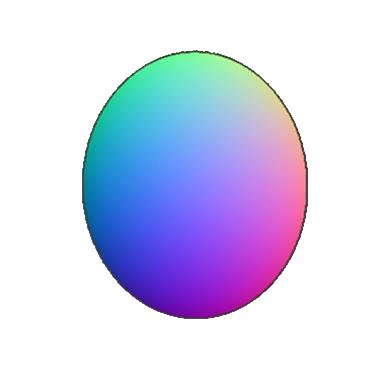

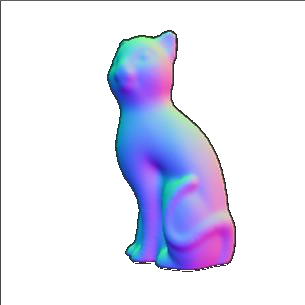

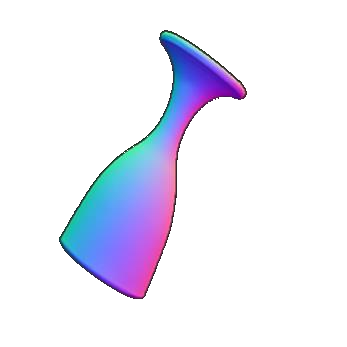

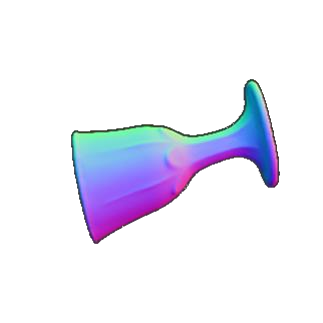

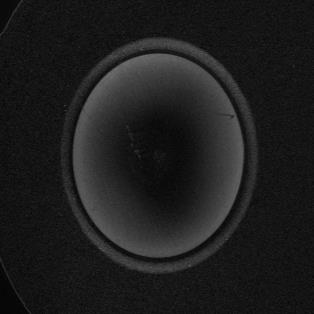

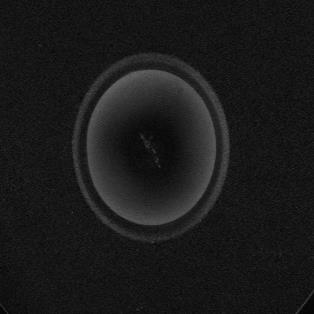

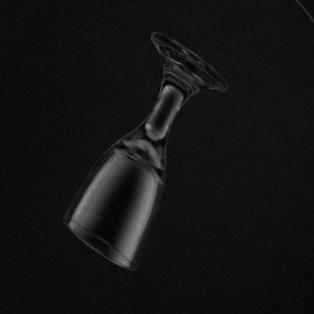

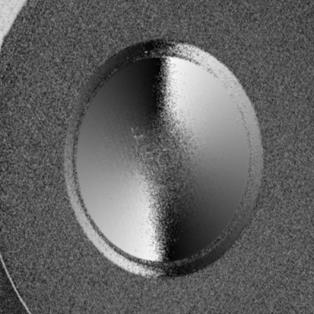

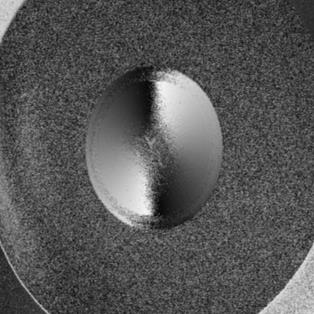

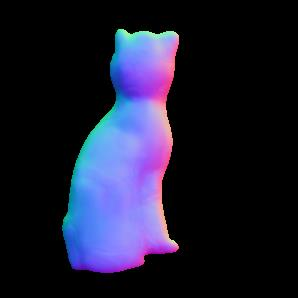

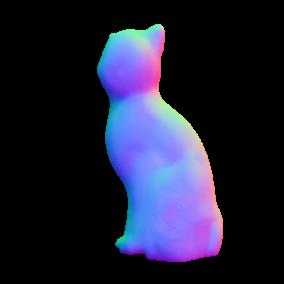

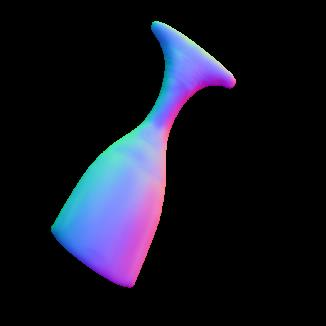

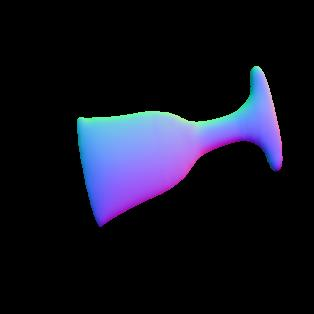

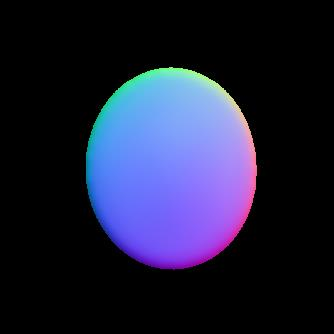

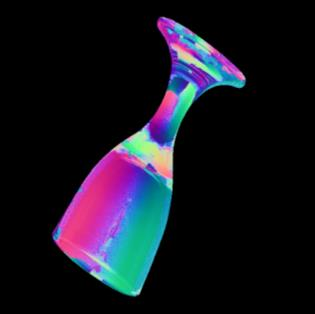

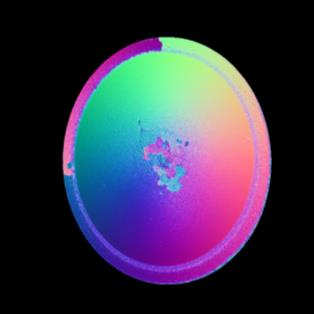

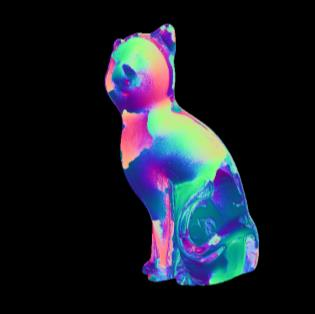

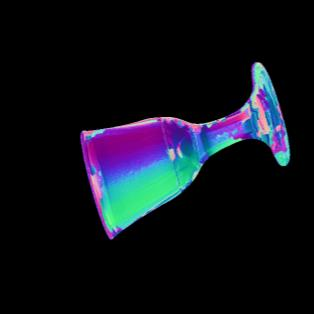

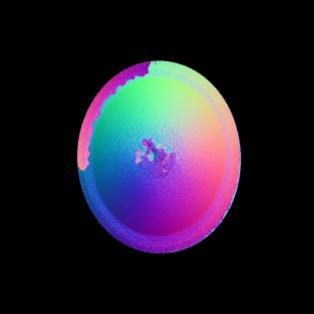

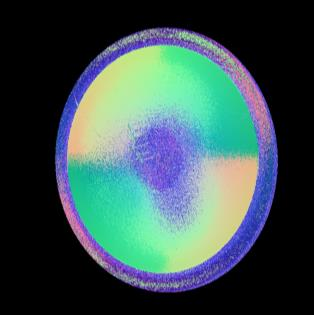

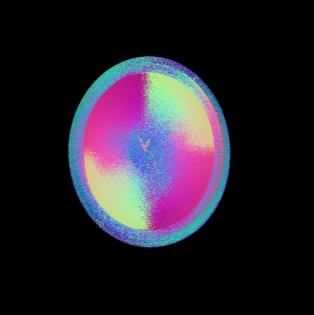

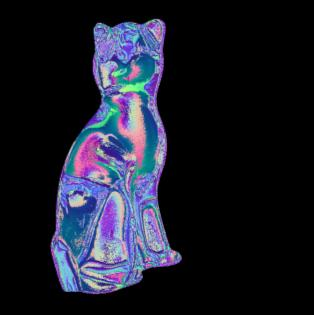

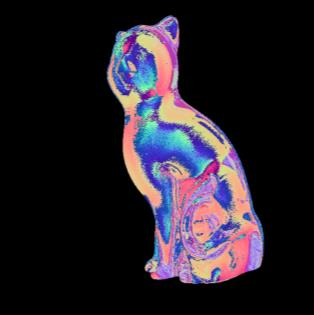

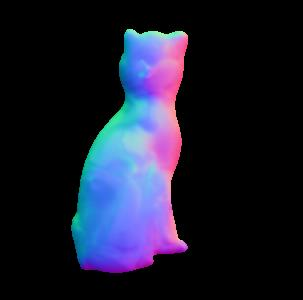

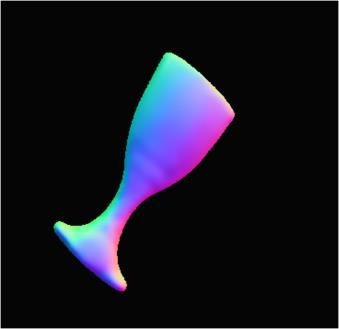

This paper presents a data-driven approach for transparent shape from polarization. Due to the inherent high transmittance, the previous shape from polarization(SfP) methods based on specular reflection model have difficulty in estimating transparent shape, and the lack of datasets for transparent SfP also limits the application of the data-driven approach. Hence, we construct the transparent SfP dataset which consists of both synthetic and real-world datasets. To determine the reliability of the physics-based reflection model, we define the physics-based prior confidence by exploiting the inherent fault of polarization information, then we propose a multi-branch fusion network to embed the confidence. Experimental results show that our approach outperforms other SfP methods. Compared with the previous method, the mean and median angular error of our approach are reduced from $19.00^\circ$ and $14.91^\circ$ to $16.72^\circ$ and $13.36^\circ$, and the accuracy $11.25^\circ, 22.5^\circ, 30^\circ$ are improved from $38.36\%, 77.36\%, 87.48\%$ to $45.51\%, 78.86\%, 89.98\%$, respectively.

翻译:本文为两极分化的透明形状提供了一种由数据驱动的透明形状方法。由于具有固有的高传输能力,先前基于视觉反射模型的两极分化(SfP)方法的形状在估计透明形状方面遇到困难,而缺乏透明的SfP数据集也限制了数据驱动方法的应用。因此,我们建立了透明的SfP数据集,该数据集由合成和现实世界数据集组成。为了确定物理反射模型的可靠性,我们通过利用两极分化信息固有的缺陷来确定以物理为基础的先前信任,然后我们建议建立一个多分支融合网络以嵌入信任。实验结果表明,我们的方法优于其他SfP方法。与以往的方法相比,我们方法的平均和中角错误从1.900 carc$和14.91 circ美元减少到16.72 cic$和13.36 circ$,准确性11.25 circ, 22.5 circ, 30 circ$,从38.36 美元、77.36 Q. Q. 、87.48 * 至45.51美元分别改进了。