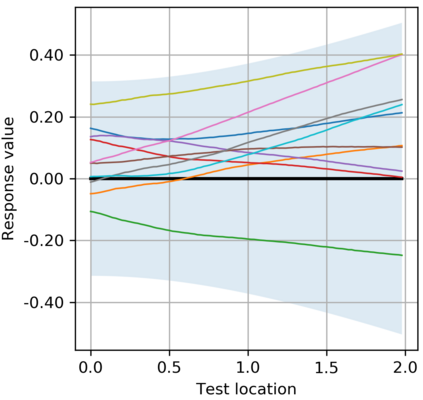

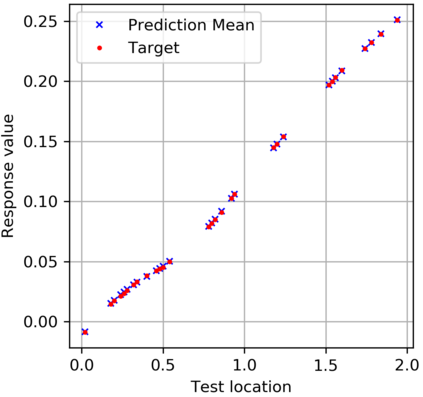

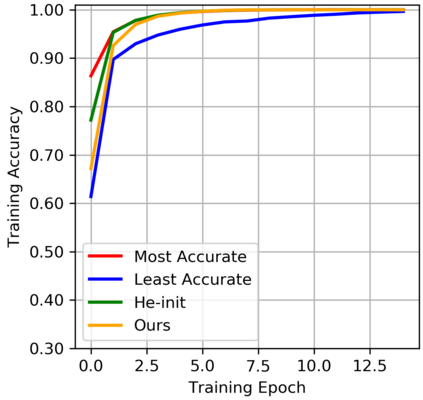

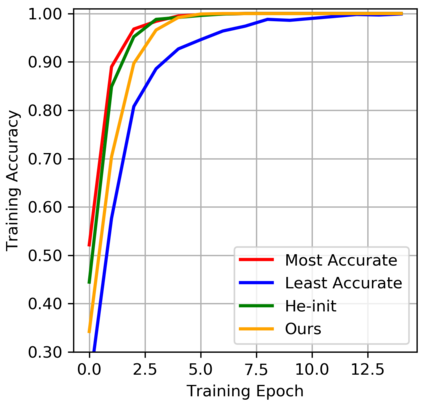

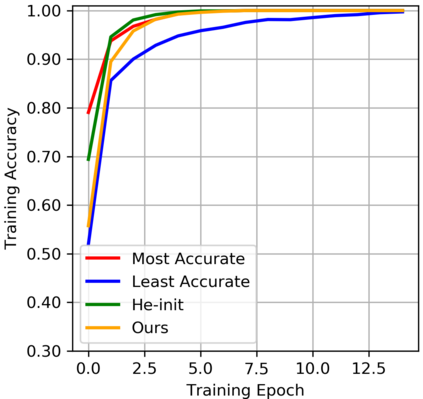

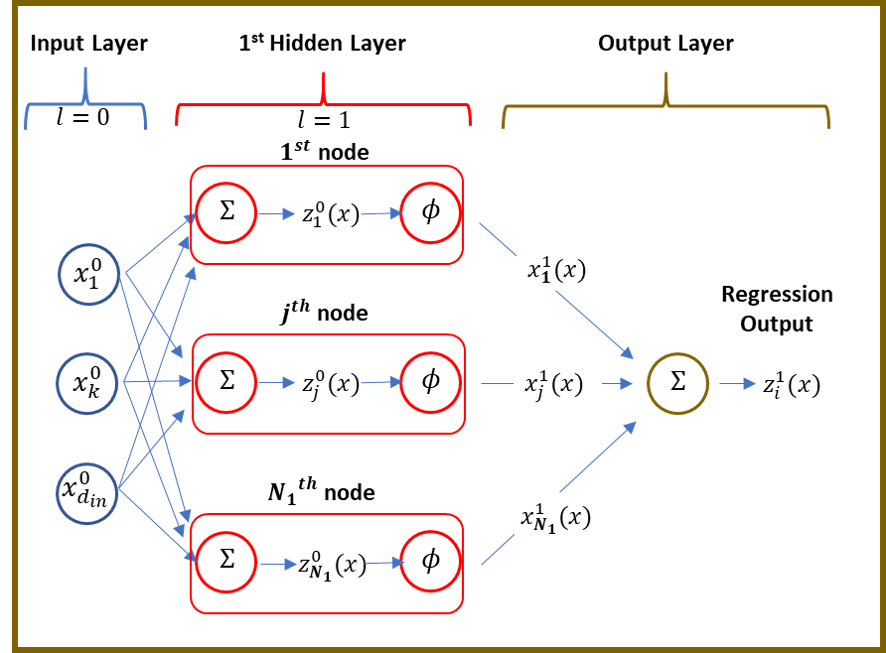

We propose a simple, data-driven approach to help guide hyperparameter selection for neural network initialization. We leverage the relationship between neural network and Gaussian process models having corresponding activation and covariance functions to infer the hyperparameter values desirable for model initialization. Our experiment shows that marginal likelihood maximization provides recommendations that yield near-optimal prediction performance on MNIST classification task under experiment constraints. Furthermore, our empirical results indicate consistency in the proposed technique, suggesting that computation cost for the procedure could be significantly reduced with smaller training sets.

翻译:我们提出一个简单、数据驱动的方法,帮助指导神经网络初始化的超参数选择。我们利用神经网络和具有相应激活和共变功能的高斯进程模型之间的关系,推断出模型初始化所需的超参数值。我们的实验表明,微小可能性最大化提供了一些建议,在实验制约下,在MNIST分类任务方面产生接近最佳的预测性能。此外,我们的经验结果表明,拟议技术的一致性,建议用较小的培训组合来大幅降低程序计算成本。