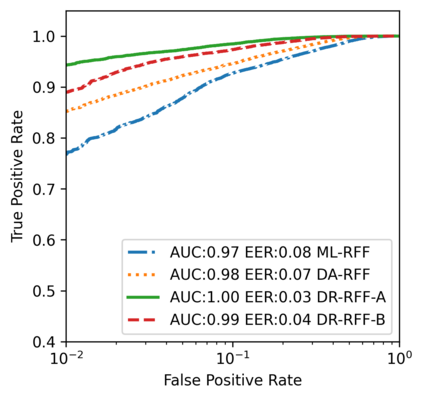

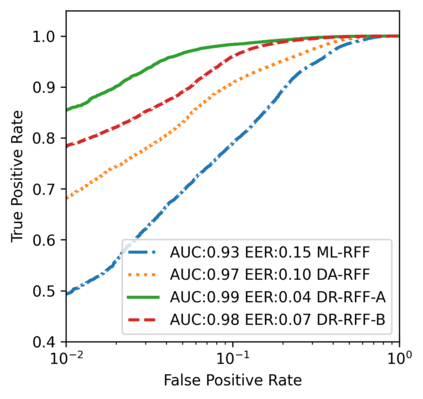

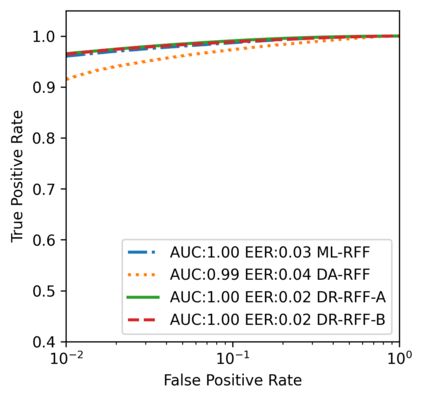

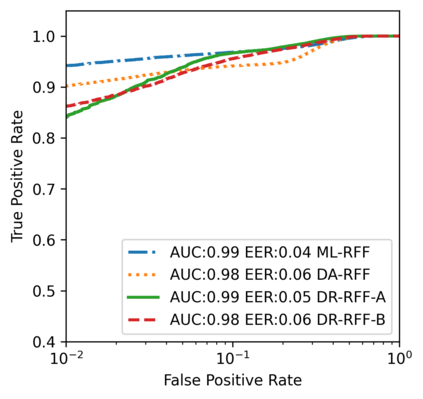

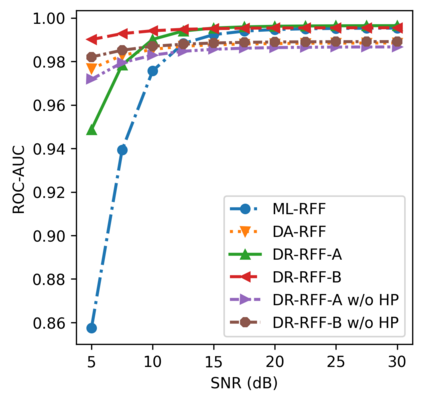

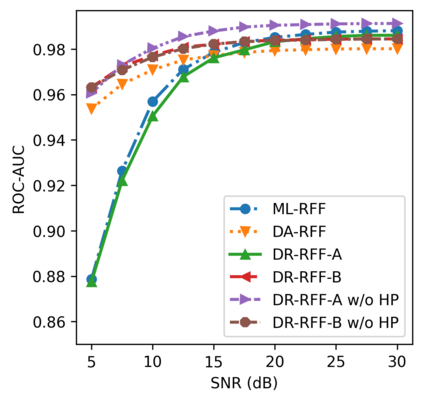

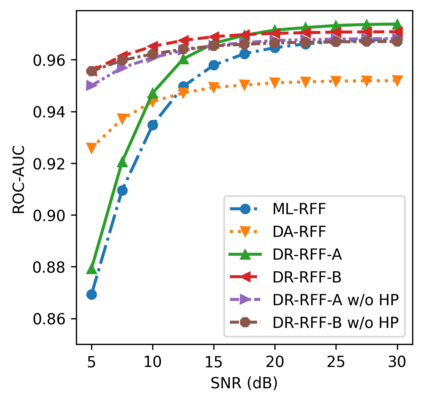

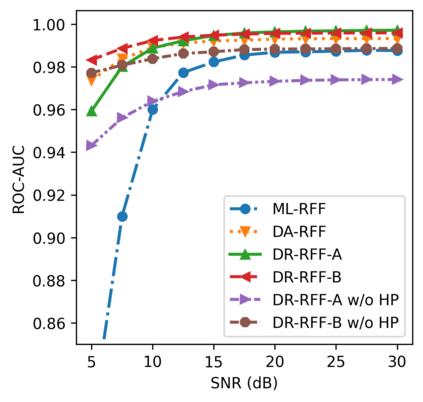

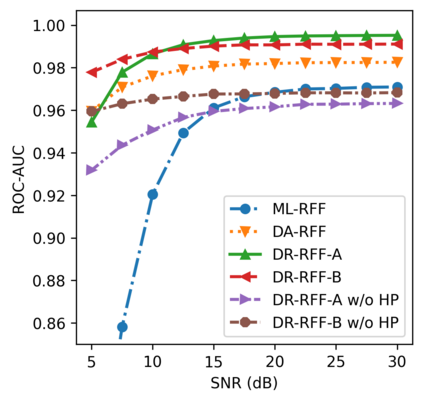

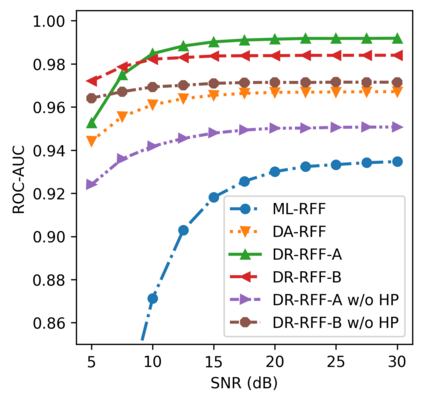

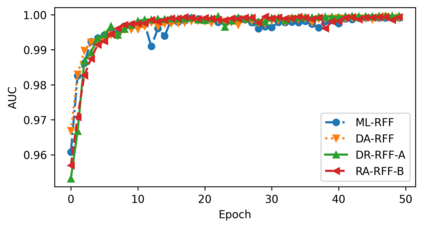

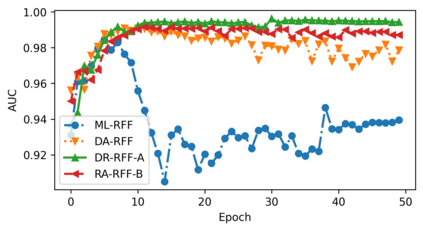

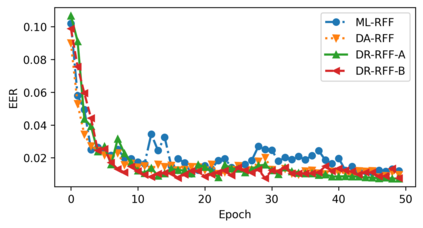

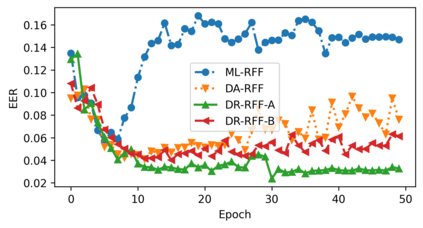

Deep learning (DL) applied to a device's radio-frequency fingerprint~(RFF) has attracted significant attention in physical-layer authentications due to its extraordinary classification performance. Conventional DL-RFF techniques, trained by adopting maximum likelihood estimation~(MLE), tend to overfit the channel statistics embedded in the training dataset. This restricts their practical applications as it is challenging to collect sufficient training data capturing the characteristics of all possible wireless channel environments. To address this challenge, we propose a DL framework of disentangled representation learning~(DRL) that first learns to factor the input signals into a device-relevant component and a device-irrelevant component via adversarial learning. Then, it synthesizes a set of augmented signals by shuffling these two parts within a given training dataset for training of subsequent RFF extractor. The implicit data augmentation in the proposed framework imposes a regularization on the RFF extractor to avoid the possible overfitting of device-irrelevant channel statistics, without collecting additional data from unknown channels. Experiments validate that the proposed approach, referred to as DR-RFF, outperforms conventional methods in terms of generalizability to unknown complicated propagation environments, e.g., dispersive multipath fading channels, even though all the training data are collected in a simple environment with dominated direct line-of-sight~(LoS) propagation paths.

翻译:用于设备无线电频率指纹的深度学习 (DL) 因其特殊的分类性能,在物理层认证中吸引了极大关注。常规 DL- RFF 技术,通过采用最大可能性估计~(MLE)来培训,往往过度配置培训数据集中嵌入的频道统计数据。这限制了它们的实际应用,因为收集足够的培训数据以捕捉所有可能的无线频道环境的特性是具有挑战性的。为了应对这一挑战,我们提议了一个DL框架,即分解代表学习 ~(DRL),它首先通过对抗性学习将输入信号纳入一个与设备相关的组件和一个与设备相关的组件。然后,它通过将这两部分在特定的培训数据集中进行拼接,将这两部分合并到培训数据集中。拟议框架中的隐含性数据增强使得RFF提取器在避免与设备无关的频道统计数据可能过度匹配,而没有从未知的渠道收集更多数据。 实验证实,拟议的方法,即DRF, 超越了与设备相关的组件相关的部分,在常规路径中,尽管常规方法在常规路径中是不透明的,但是,在普通的传播环境中是不透明的、不透明的、不透明的、不透明的、不透明的、不透明的、不透明的、不透明的、不透明的、不易传播环境。