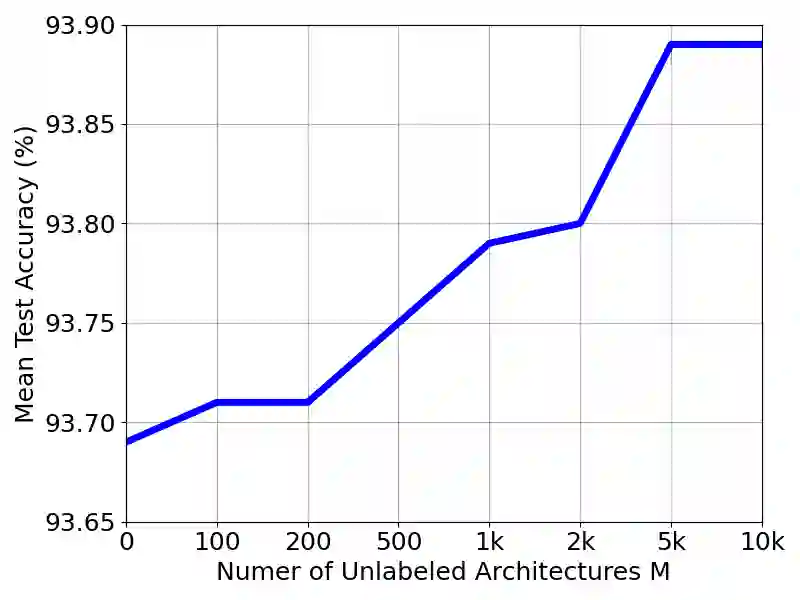

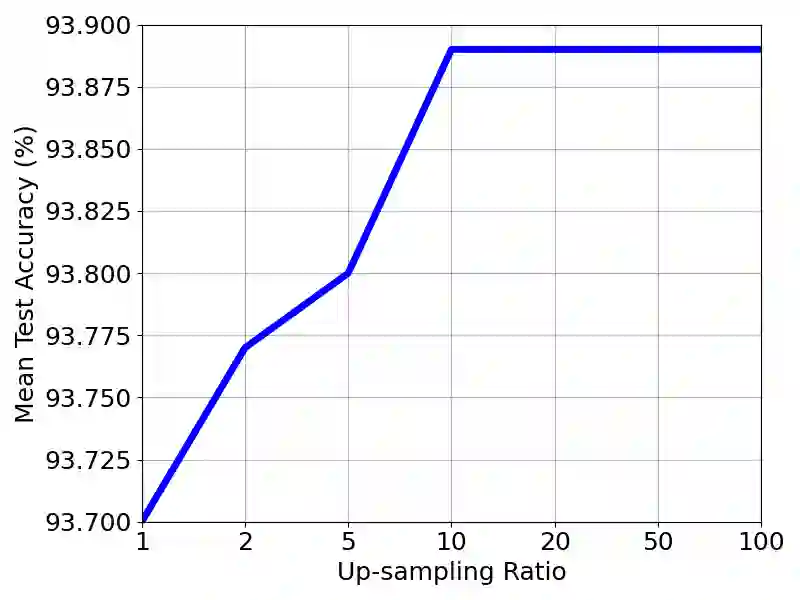

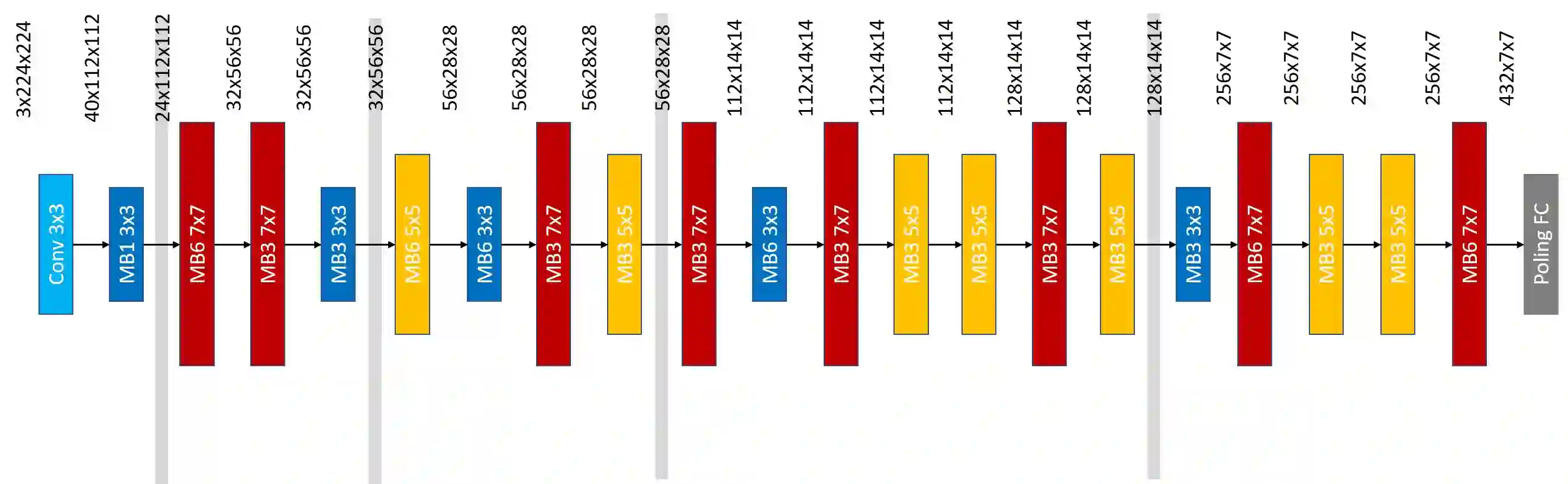

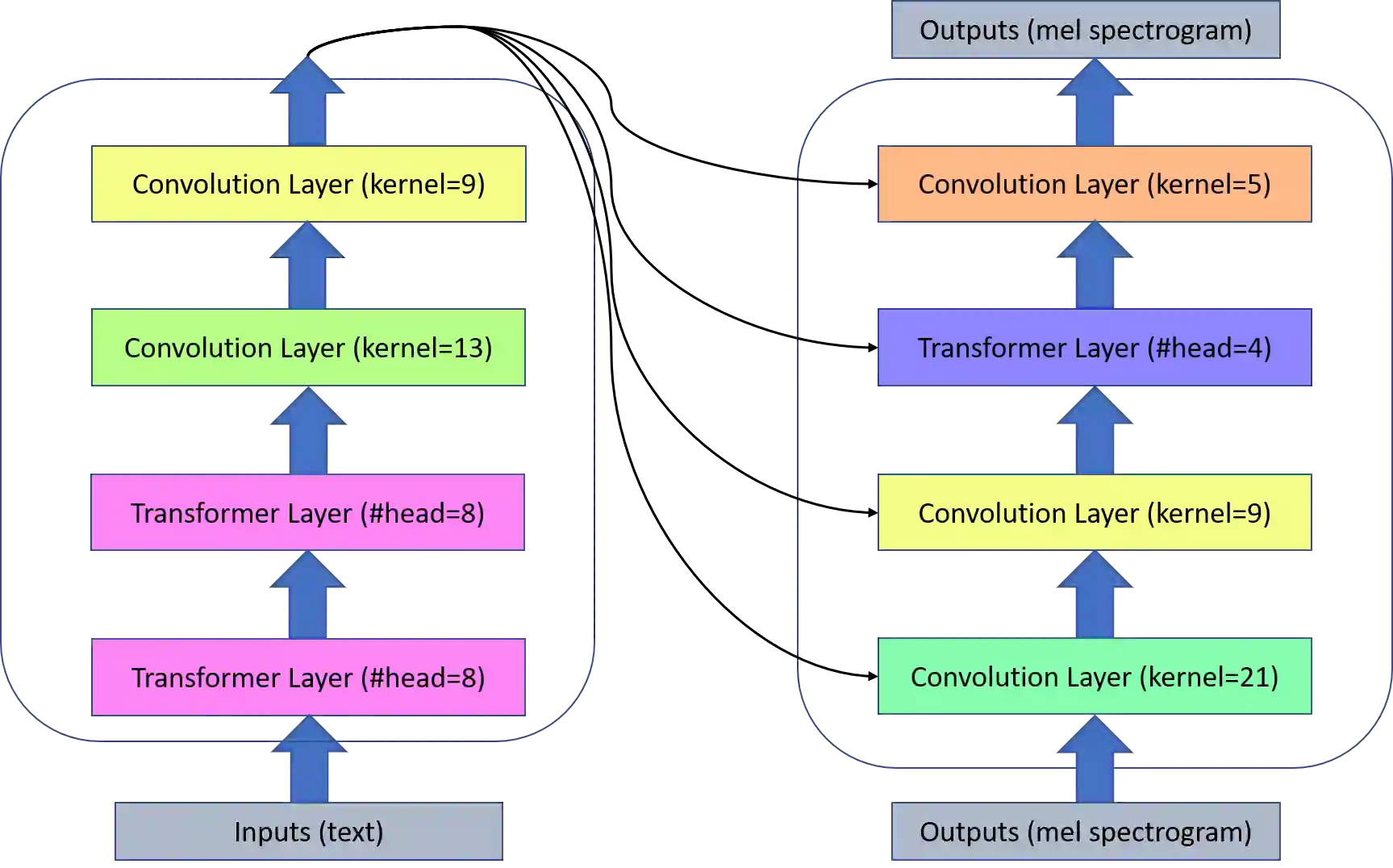

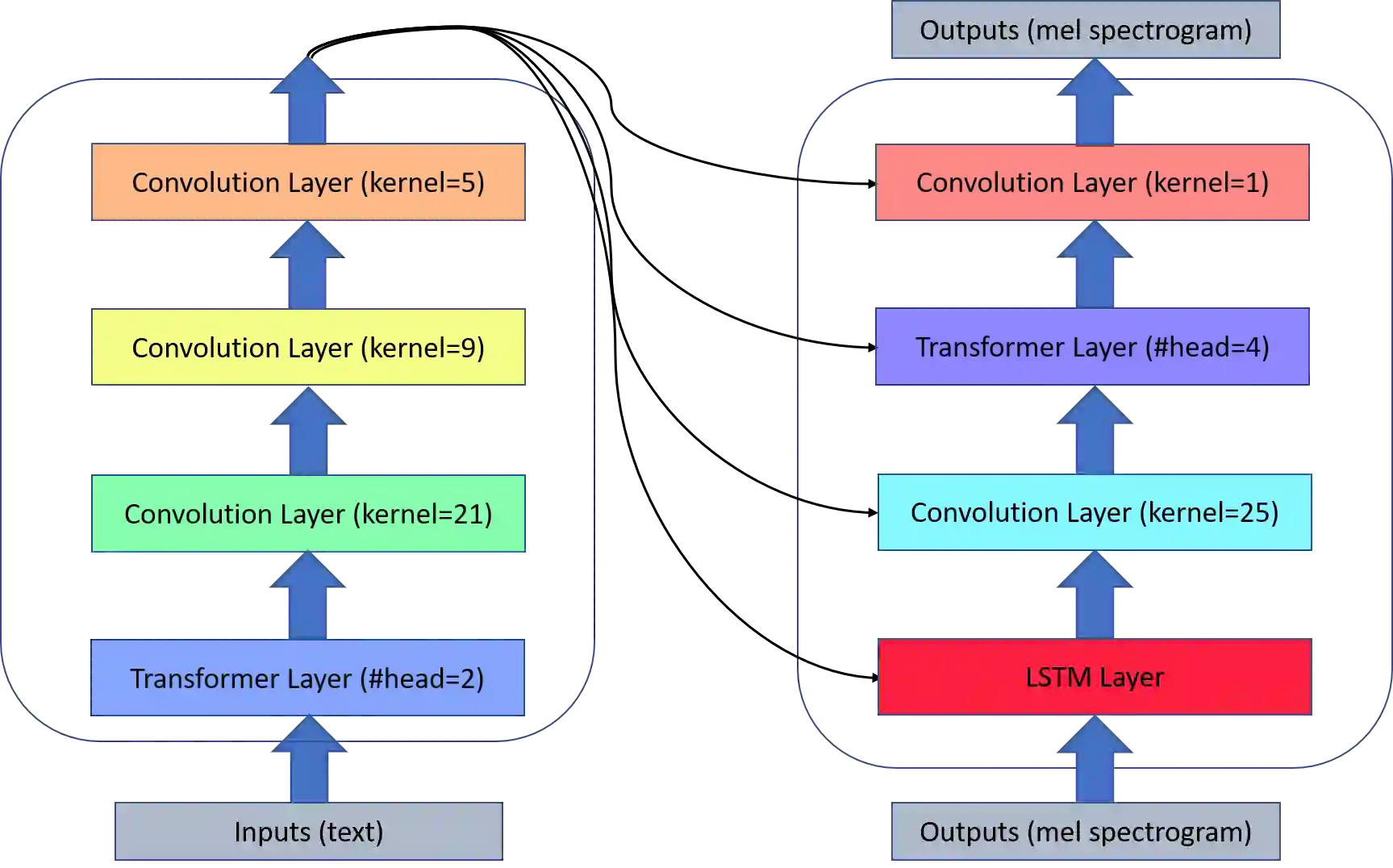

Neural architecture search (NAS) relies on a good controller to generate better architectures or predict the accuracy of given architectures. However, training the controller requires both abundant and high-quality pairs of architectures and their accuracy, while it is costly to evaluate an architecture and obtain its accuracy. In this paper, we propose SemiNAS, a semi-supervised NAS approach that leverages numerous unlabeled architectures (without evaluation and thus nearly no cost). Specifically, SemiNAS 1) trains an initial accuracy predictor with a small set of architecture-accuracy data pairs; 2) uses the trained accuracy predictor to predict the accuracy of large amount of architectures (without evaluation); and 3) adds the generated data pairs to the original data to further improve the predictor. The trained accuracy predictor can be applied to various NAS algorithms by predicting the accuracy of candidate architectures for them. SemiNAS has two advantages: 1) It reduces the computational cost under the same accuracy guarantee. On NASBench-101 benchmark dataset, it achieves comparable accuracy with gradient-based method while using only 1/7 architecture-accuracy pairs. 2) It achieves higher accuracy under the same computational cost. It achieves 94.02% test accuracy on NASBench-101, outperforming all the baselines when using the same number of architectures. On ImageNet, it achieves 23.5% top-1 error rate (under 600M FLOPS constraint) using 4 GPU-days for search. We further apply it to LJSpeech text to speech task and it achieves 97% intelligibility rate in the low-resource setting and 15% test error rate in the robustness setting, with 9%, 7% improvements over the baseline respectively.

翻译:神经架构搜索(NAS) 依靠一个良好的控制器来生成更好的架构或预测给定架构的准确性。 然而, 培训控制器需要丰富和高质量的建筑配对及其准确性, 而评估一个架构和获得其准确性的成本是昂贵的。 在本文中, 我们提出SemNAS, 这是一种半监督的NAS 方法, 利用许多没有标签的架构( 没有评估, 因而几乎没有成本 ) 。 具体地说, SemNAS 1 培训了一个初始精密预测器, 配有一套小规模的架构改进数据配对; 2 使用经过培训的精确性预测器来预测大量建筑的准确性( 没有评估); 3 将生成的数据配对原始数据配对, 以进一步改进预测器来进行。 训练有素的精度预测器可以应用各种NAS 算法, 利用许多没有标签的架构的准确性( 没有评估, 因而几乎没有成本 ) 。 在 NASBSB- 101 基准中, 它在仅使用1/7 的精确性搜索和精确性测试率中, 达到所有 IMSBSBSB 的精确率 的精确率 中, 在测试中, 在测试中, 它在使用15-02 达到相同的精确率中, 达到相同的精确度中, 。