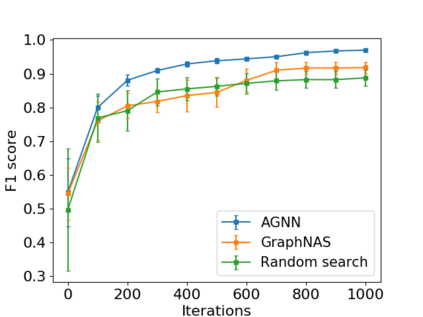

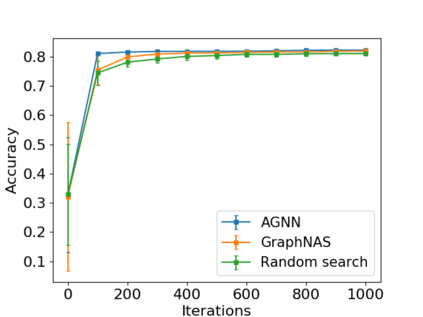

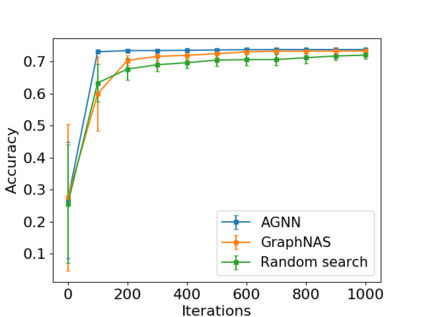

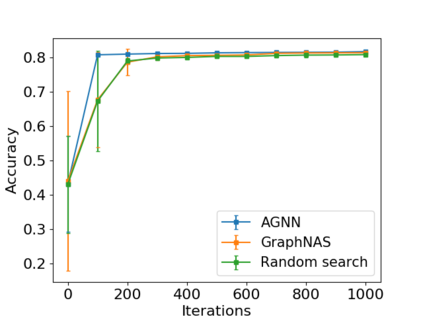

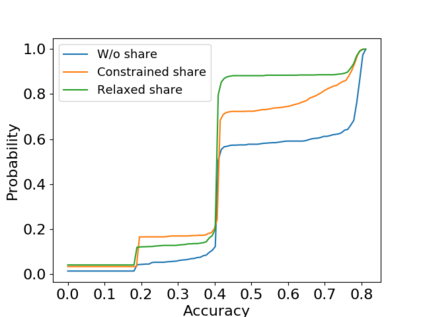

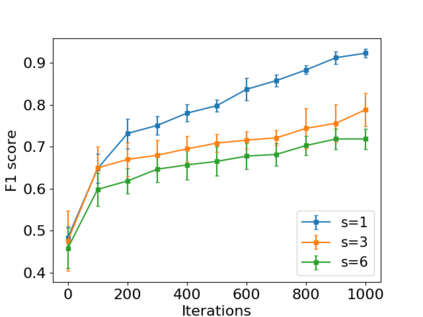

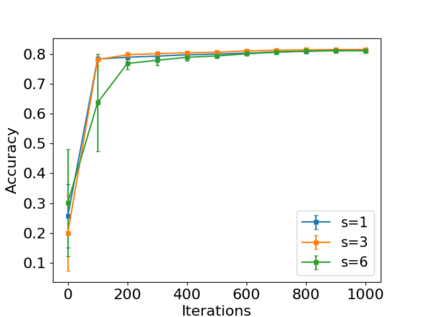

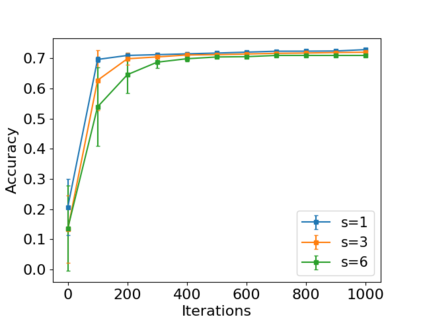

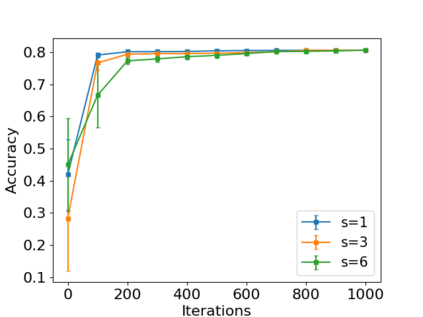

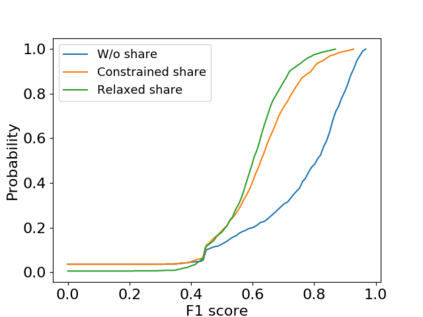

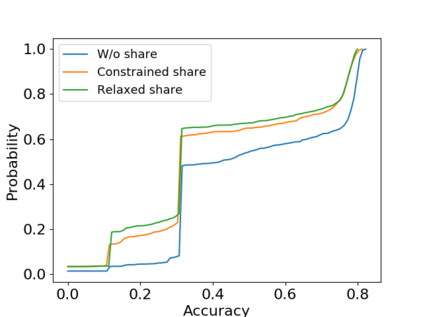

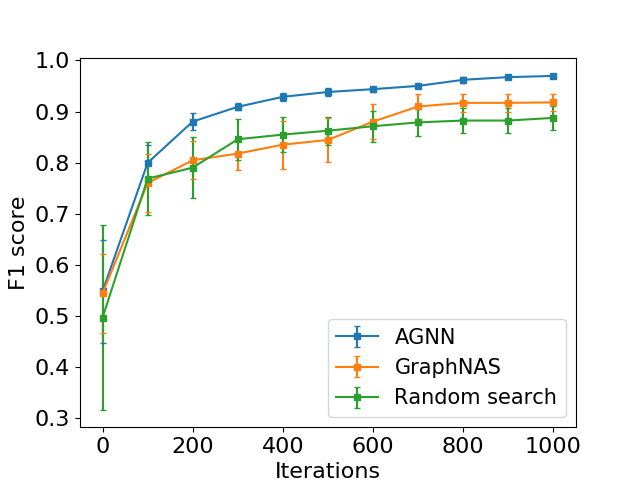

Graph neural networks (GNN) has been successfully applied to operate on the graph-structured data. Given a specific scenario, rich human expertise and tremendous laborious trials are usually required to identify a suitable GNN architecture. It is because the performance of a GNN architecture is significantly affected by the choice of graph convolution components, such as aggregate function and hidden dimension. Neural architecture search (NAS) has shown its potential in discovering effective deep architectures for learning tasks in image and language modeling. However, existing NAS algorithms cannot be directly applied to the GNN search problem. First, the search space of GNN is different from the ones in existing NAS work. Second, the representation learning capacity of GNN architecture changes obviously with slight architecture modifications. It affects the search efficiency of traditional search methods. Third, widely used techniques in NAS such as parameter sharing might become unstable in GNN. To bridge the gap, we propose the automated graph neural networks (AGNN) framework, which aims to find an optimal GNN architecture within a predefined search space. A reinforcement learning based controller is designed to greedily validate architectures via small steps. AGNN has a novel parameter sharing strategy that enables homogeneous architectures to share parameters, based on a carefully-designed homogeneity definition. Experiments on real-world benchmark datasets demonstrate that the GNN architecture identified by AGNN achieves the best performance, comparing with existing handcrafted models and tradistional search methods.

翻译:在图形结构数据上,已经成功地应用了图表神经网络(GNN)来操作图形结构数据。在特定情况下,通常需要丰富的人类专门知识和巨大的艰苦试验才能确定合适的GNN结构。这是因为GNN结构的性能受到图形组合组件选择的显著影响,例如综合功能和隐藏的维度。神经结构搜索(NAS)显示其发现在图像和语言建模中学习任务的有效深层结构的潜力。然而,现有的NAS算法无法直接应用于GNNS搜索问题。首先,GNN的搜索空间不同于现有的NAS工作。第二,GNN结构结构的代表性学习能力显然随着结构的轻微修改而变化。它影响到传统搜索方法的搜索效率。第三,NAS中广泛使用的技术,例如参数共享可能会在GNNNW中变得不稳定。为了弥合差距,我们建议自动化的图形神经网络框架,目的是在预定的搜索空间中找到最佳的GNNNS结构。基于强化的搜索空间设计目的是通过小步骤对模型进行贪婪的校准。GNNNN结构的学习能力学习能力能力,GNNNS在经过认真研订的实验室基准结构上能够通过设计新的标准结构,在GNIS标定的实验室基准中进行数据结构上进行数据交换。