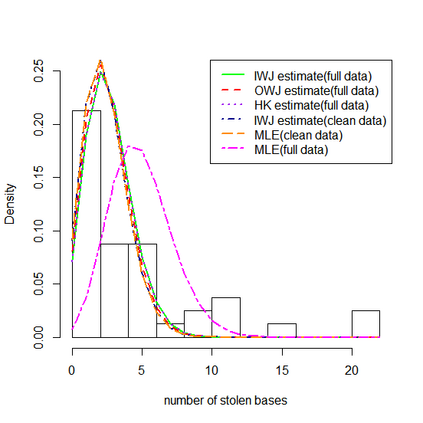

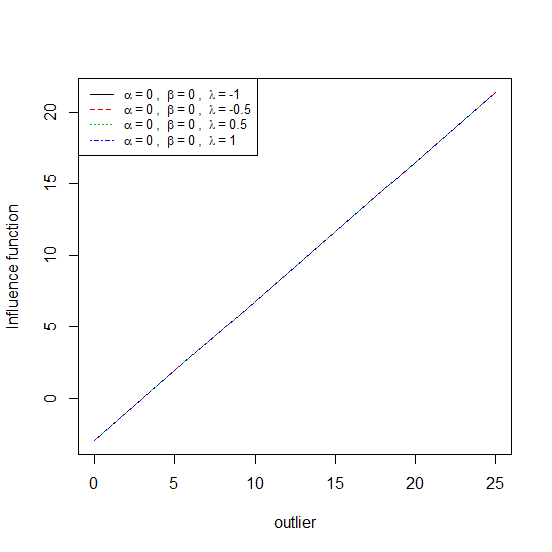

Minimization of suitable statistical distances~(between the data and model densities) has proved to be a very useful technique in the field of robust inference. Apart from the class of $\phi$-divergences of \cite{a} and \cite{b}, the Bregman divergence (\cite{c}) has been extensively used for this purpose. However, since the data density must have a linear presence in the cross product term of the Bregman divergence involving both the data and model densities, several useful divergences cannot be captured by the usual Bregman form. In this respect, we provide an extension of the ordinary Bregman divergence by considering an exponent of the density function as the argument rather than the density function itself. We demonstrate that many useful divergence families, which are not ordinarily Bregman divergences, can be accommodated within this extended description. Using this formulation, one can develop many new families of divergences which may be useful in robust inference. In particular, through an application of this extension, we propose the new class of the GSB divergence family. We explore the applicability of the minimum GSB divergence estimator in discrete parametric models. Simulation studies as well as conforming real data examples are given to demonstrate the performance of the estimator and to substantiate the theory developed.

翻译:适当统计距离的最小化 ~ (在数据和模型密度之间) 已证明是稳健推断领域的一个非常有用的技术。 除了 $\ phe$- divegences of\ cite{a} 和\ cite{b} 类外, Bregman 差异(\ cite{c}) 被广泛用于此目的。 但是,由于数据密度必须在涉及数据和模型密度的布雷格曼差异的跨产品术语中有一个线性存在,因此,通常的布雷格曼格式无法捕捉一些有用的差异。 在这方面,我们提供了普通布雷格曼差异的延伸,将密度函数的推举作为参数而不是密度函数本身。我们表明,许多有用的差异型号(通常不是布雷格曼差异)可以在这一较长的描述范围内得到适应。 使用这一表述,人们可以开发许多新的差异型新的差异型群,可能有益于稳健的引用。 特别是通过应用这一扩展,我们提议将新的GSB 差异类中的精确度分类作为精确度模型的精确度模型。 我们探索Simimimimimaleximalexal dislation 。