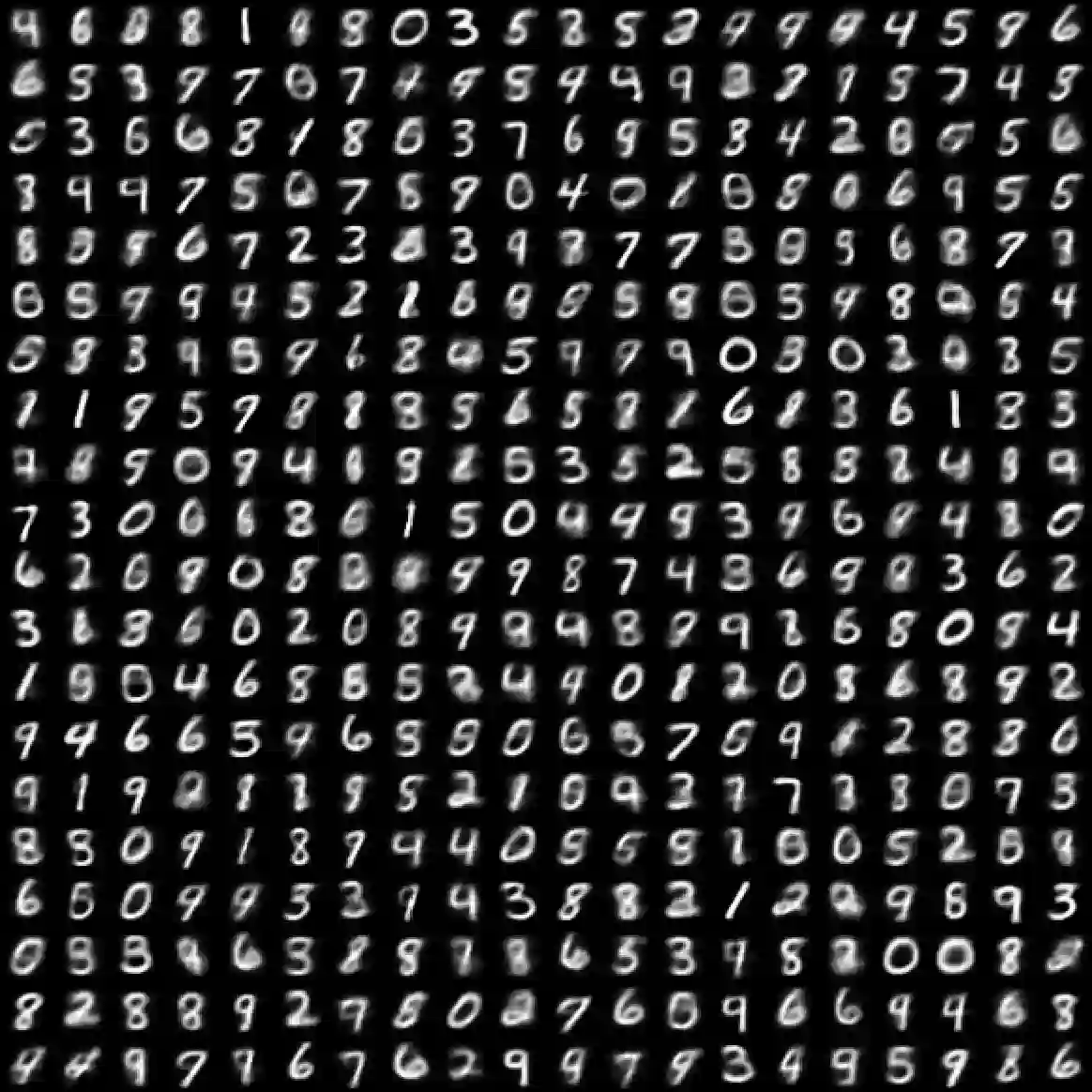

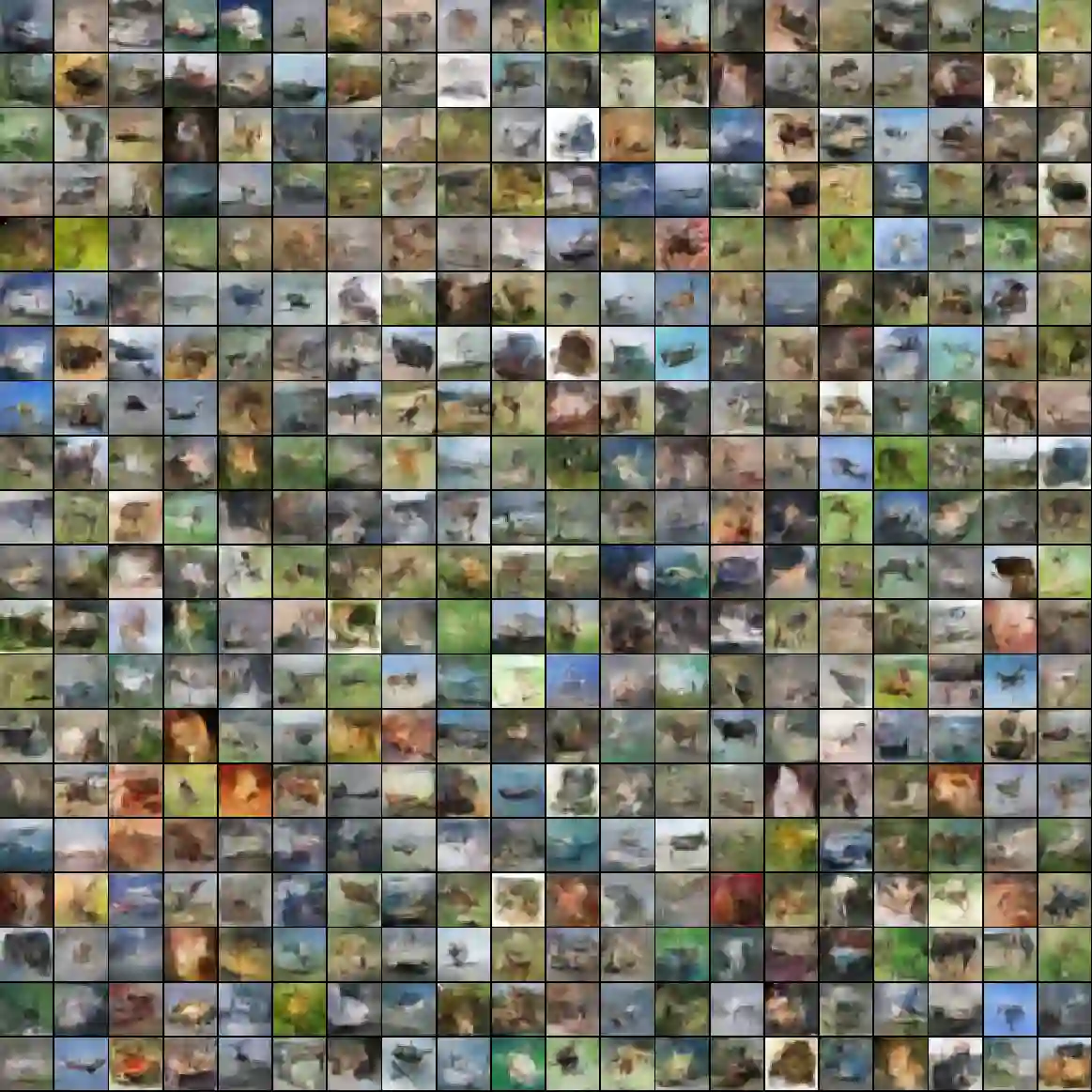

Implicit probabilistic models are models defined naturally in terms of a sampling procedure and often induces a likelihood function that cannot be expressed explicitly. We develop a simple method for estimating parameters in implicit models that does not require knowledge of the form of the likelihood function or any derived quantities, but can be shown to be equivalent to maximizing likelihood under some conditions. Our result holds in the non-asymptotic parametric setting, where both the capacity of the model and the number of data examples are finite. We also demonstrate encouraging experimental results.

翻译:隐性概率模型是按抽样程序自然界定的模型,往往产生无法明确表达的可能功能。我们开发了一种简单的方法来估计隐含模型中的参数,不要求了解概率函数的形式或任何衍生数量,但可以证明在某些条件下可以与最大可能性等同。我们的结果存在于非症状参数设置中,模型的能力和数据实例的数量都是有限的。我们还展示了令人鼓舞的实验结果。