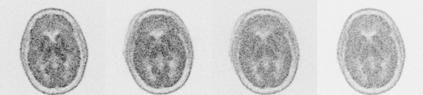

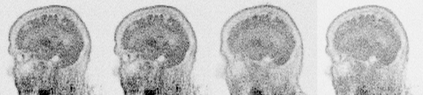

Due to various physical degradation factors and limited counts received, PET image quality needs further improvements. The denoising diffusion probabilistic models (DDPM) are distribution learning-based models, which try to transform a normal distribution into a specific data distribution based on iterative refinements. In this work, we proposed and evaluated different DDPM-based methods for PET image denoising. Under the DDPM framework, one way to perform PET image denoising is to provide the PET image and/or the prior image as the network input. Another way is to supply the prior image as the input with the PET image included in the refinement steps, which can fit for scenarios of different noise levels. 120 18F-FDG datasets and 140 18F-MK-6240 datasets were utilized to evaluate the proposed DDPM-based methods. Quantification show that the DDPM-based frameworks with PET information included can generate better results than the nonlocal mean and Unet-based denoising methods. Adding additional MR prior in the model can help achieve better performance and further reduce the uncertainty during image denoising. Solely relying on MR prior while ignoring the PET information can result in large bias. Regional and surface quantification shows that employing MR prior as the network input while embedding PET image as a data-consistency constraint during inference can achieve the best performance. In summary, DDPM-based PET image denoising is a flexible framework, which can efficiently utilize prior information and achieve better performance than the nonlocal mean and Unet-based denoising methods.

翻译:由于各种物理退化因素和收到的数量有限, PET 图像质量需要进一步改进; 去除扩散概率模型(DDPM)是分布式学习模型,试图将正常分布转换成基于迭代改进的具体数据分配; 在这项工作中,我们提出并评价了基于DDPM的不同PET图像拆离方法; 在DDPM框架下, 进行PET图像拆分的一种方法是提供PET图像和/或作为网络输入的先前图像; 另一种方法是提供先前图像,作为在改进步骤中包含的PET图像(DPPPPPM)的输入; 这些模型试图将正常分布转化为基于迭代改进的具体数据分配; 120 FDG 18 数据集和 140 F-MK-6240数据集用于评价基于DDPM 图像拆分解方法。 在DDPM 框架下,基于 DDPMM 图像拆分解方法的 DDPM 框架可以产生比基于非本地的和基于 Unet 的灵活解析方法更好的结果。 在图像解析过程中, 增加 MRM 能够实现不确定性, 在先前的图像解析中, 之前的Slodial- deliferal be 能够取得最佳的成绩, 。