在医疗、教育、交通运输和网络安全等高风险领域中,智能体需要做出一系列影响现实世界结果的决策。强化学习(Reinforcement Learning, RL)为通过经验训练此类智能体提供了一个自然且强大的框架。然而,尽管近年来取得了显著进展,RL 的部署与应用仍面临若干关键障碍。

首先,一个具备能力的 RL 智能体可能会以违背人类预期的方式行事。在协作或安全关键场景中,难以理解的行为可能会让用户感到困惑,甚至带来新的风险。例如,一辆自动驾驶汽车若突然急转以避免事故,即使它整体上比人类驾驶员更安全,也可能仍被认为不安全。这种感知风险会阻碍其被广泛采用。因此,开发表现出直观行为的智能体往往是实现人机协作与信任的前提。

其次,在安全关键和受监管的领域,解释与审计 AI 决策的能力正日益成为正式要求。然而,大多数 RL 智能体依赖深度神经网络做出决策,而这类模型对人类而言难以理解。因此,可解释性决策成为一个亟待解决的重要问题。

第三,设计者通常难以完全明确地指定智能体的全部期望行为。因此,往往采用固定且简化的奖励函数来作为代理目标。如果该代理目标存在错误或不足,智能体可能会表现出与人类真实期望不一致的行为。因此,如何确保智能体与人类意图、目标和价值观保持一致,成为一项重要挑战。

这些挑战都具有一个共同主题:它们源于 RL 智能体在人类环境中与人类互动或代表人类做出决策。因此,AI 未来的一个关键问题是如何开发能够与人良好协作的智能体。本论文提出了一种以人为中心的 RL 方法,旨在构建和探索具备可解释性、直观性和一致性的 AI 智能体。我们在智能体设计与评估上提出了若干技术进展,解决了由人类参与引出的关键研究问题。

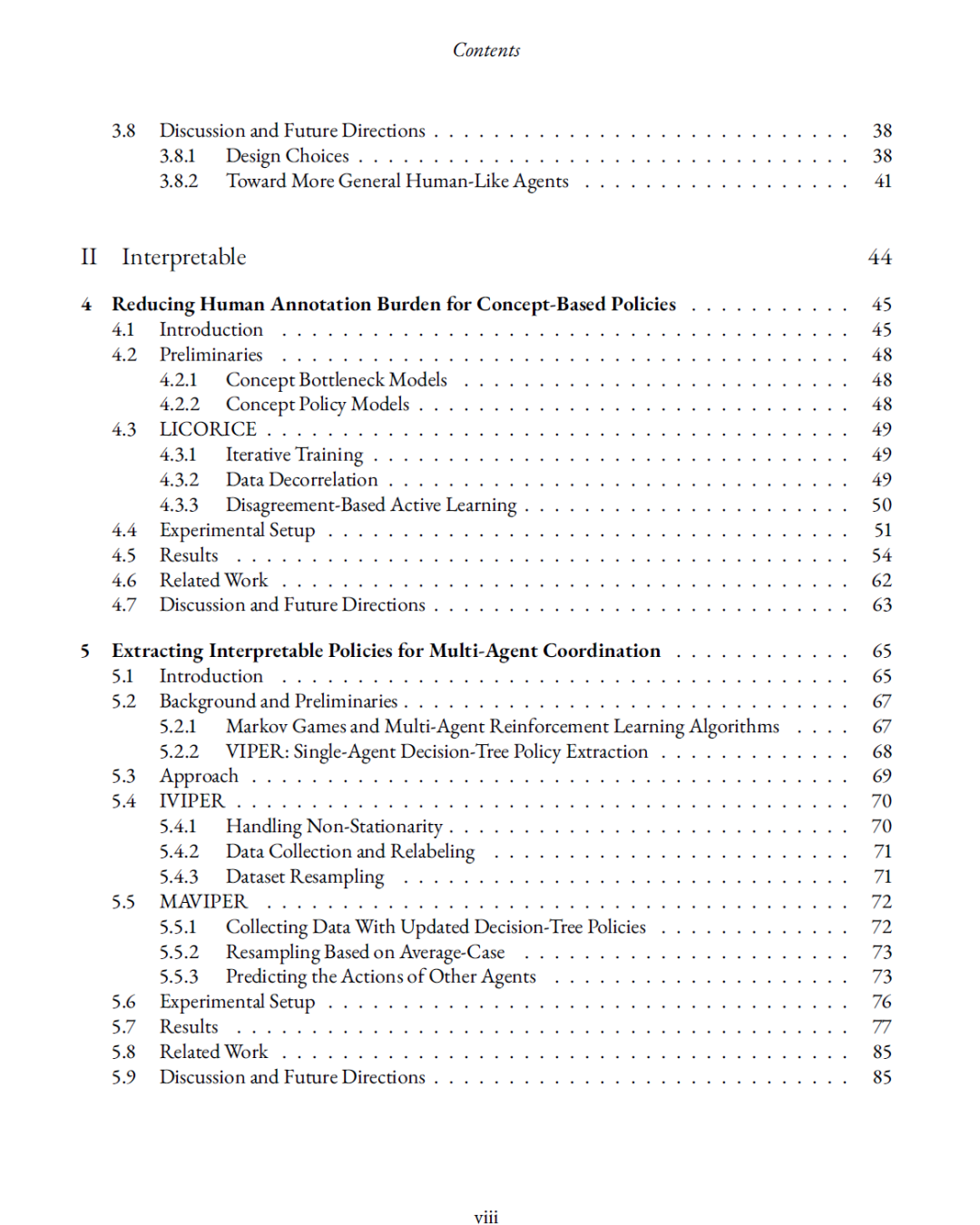

为实现直观行为,我们设计了第一个通过导航图灵测试(navigation Turing test)的 RL 智能体,并研究了人们为何将其行为视为“类人”的原因。为实现可解释性,我们提出并实现了针对 RL 的两种新维度的可解释性算法:在多智能体决策中保持透明性,以及减少对人工标注的依赖。围绕行为一致性,我们提出了一种新的对齐问题表述(基于决策的对齐),并引入了一种能够学习与人类偏好一致的决策策略的算法。同时,我们贡献了用于训练和评估智能体在模糊、不完全指定任务下行为一致性的基准与数据集。 最后,本论文讨论了未来研究如何在此基础上进一步推进,以实现能够支持人类繁荣发展的 AI 智能体。