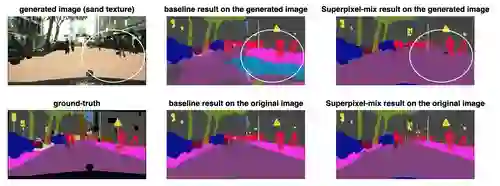

Along with predictive performance and runtime speed, reliability is a key requirement for real-world semantic segmentation. Reliability encompasses robustness, predictive uncertainty and reduced bias. To improve reliability, we introduce Superpixel-mix, a new superpixel-based data augmentation method with teacher-student consistency training. Unlike other mixing-based augmentation techniques, mixing superpixels between images is aware of object boundaries, while yielding consistent gains in segmentation accuracy. Our proposed technique achieves state-of-the-art results in semi-supervised semantic segmentation on the Cityscapes dataset. Moreover, Superpixel-mix improves the reliability of semantic segmentation by reducing network uncertainty and bias, as confirmed by competitive results under strong distributions shift (adverse weather, image corruptions) and when facing out-of-distribution data.

翻译:在预测性能和运行时间速度的同时,可靠性是真实世界的语义分解的关键要求。 可靠性包括稳健性、 预测性不确定性和减少偏差。 为了提高可靠性,我们引入了超级像素混合,这是以超像素为基础的数据增强方法,与师生一致性培训相配合。 与其他混合型增生技术不同,图像之间混合超级像素了解物体边界,同时在分解准确性方面产生一致的收益。 我们的拟议技术在城市景象数据集中实现了半超级语义分解的最新结果。 此外,超像素混合通过减少网络不确定性和偏差,提高了语义分解的可靠性,这在强劲的分布变化(不利的天气、图像腐败)下和在面临分配外的数据时的竞争性结果都证实了这一点。