题目: Supervised Contrastive Learning

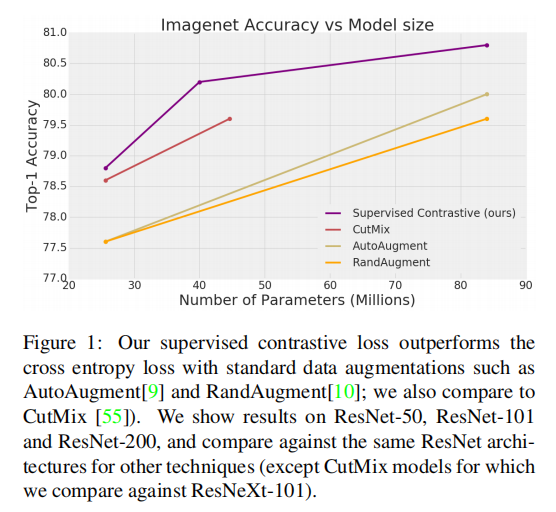

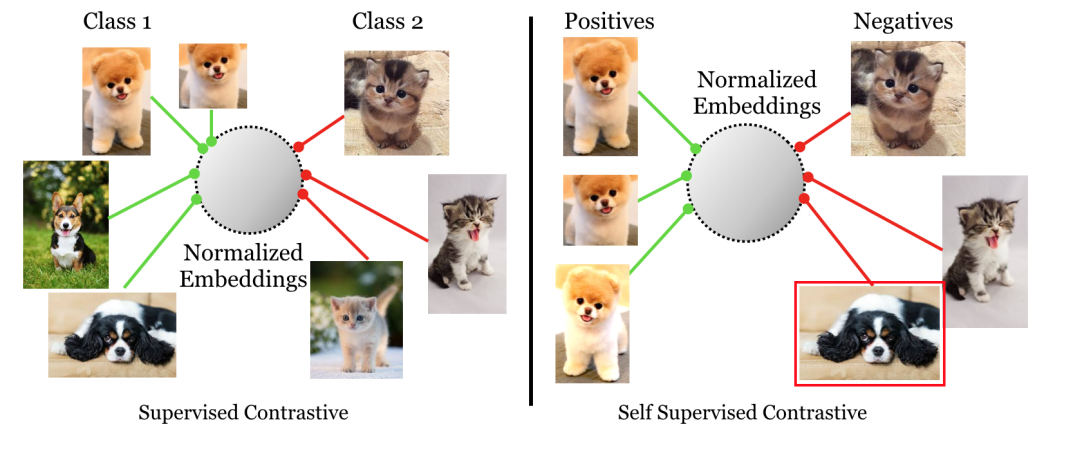

简介: 交叉熵是在图像分类模型的有监督训练中使用最广泛的损失函数。在本文中,我们提出了一种新颖的训练方法,该方法在跨不同体系结构和数据扩充的监督学习任务上始终优于交叉熵。我们修改了批处理的对比损失,最近已证明该方法对于在自我监督的情况下学习强大的表示非常有效。因此,我们能够比交叉熵更有效地利用标签信息。属于同一类别的点的群集在嵌入空间中聚在一起,同时将不同类别的样本群集推开。除此之外,我们还利用了关键成分,例如大批处理量和标准化的嵌入,这些成分已显示出对自我监督学习的好处。在ResNet-50和ResNet-200上,我们的交叉熵均超过1%,在使用AutoAugment数据增强的方法中,新的技术水平达到了78.8%。损失还显示出明显的好处,即可以在标准基准和准确性方面提高对自然基准的自然破坏的鲁棒性。与交叉熵相比,我们监督的对比损失对于诸如优化器或数据增强之类的超参数设置更稳定。

成为VIP会员查看完整内容

相关内容

专知会员服务

41+阅读 · 2020年4月11日

Arxiv

5+阅读 · 2018年4月5日