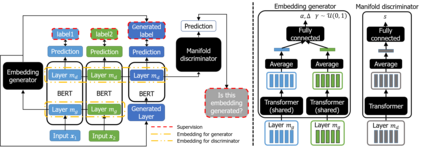

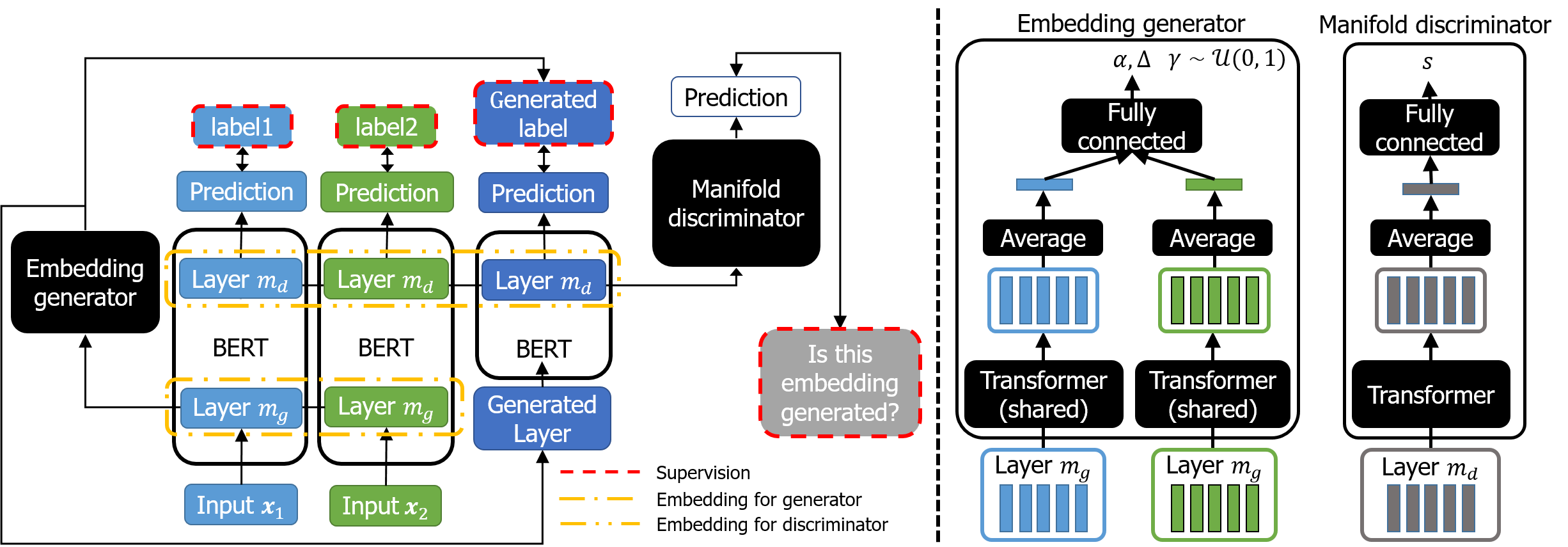

Recent studies on neural networks with pre-trained weights (i.e., BERT) have mainly focused on a low-dimensional subspace, where the embedding vectors computed from input words (or their contexts) are located. In this work, we propose a new approach to finding and regularizing the remainder of the space, referred to as out-of-manifold, which cannot be accessed through the words. Specifically, we synthesize the out-of-manifold embeddings based on two embeddings obtained from actually-observed words, to utilize them for fine-tuning the network. A discriminator is trained to detect whether an input embedding is located inside the manifold or not, and simultaneously, a generator is optimized to produce new embeddings that can be easily identified as out-of-manifold by the discriminator. These two modules successfully collaborate in a unified and end-to-end manner for regularizing the out-of-manifold. Our extensive evaluation on various text classification benchmarks demonstrates the effectiveness of our approach, as well as its good compatibility with existing data augmentation techniques which aim to enhance the manifold.

翻译:最近对具有预先训练重量的神经网络(即BERT)的研究主要侧重于一个低维子空间,即根据输入单词(或其背景)计算成的嵌入矢量的位置。在这项工作中,我们提出了寻找空间剩余部分并使之正规化的新方法,即所谓的自成一体的外侧,无法通过这些单词进入。具体地说,我们根据从实际观察的单词中获得的两个嵌入的嵌入物,综合了自成一体的嵌入物,以便利用它们来微调网络。我们培训了一名导师,以检测输入的嵌入物是否位于元体内,同时优化了发电机以产生新的嵌入物,很容易被歧视者确定为非自成一体的嵌入物。这两个模块成功地以统一和端到端的方式协作,使自成一体的嵌入物正规化。我们对各种文本分类基准的广泛评价表明了我们的方法的有效性,以及它与现有数据增强技术之间的良好兼容性,目的是增强多重性。