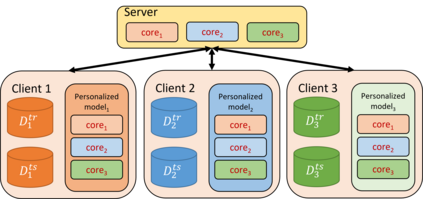

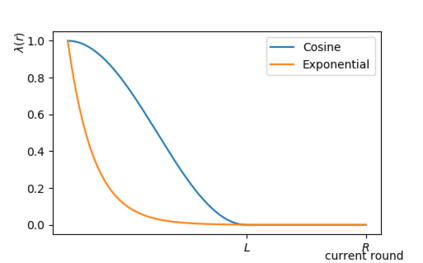

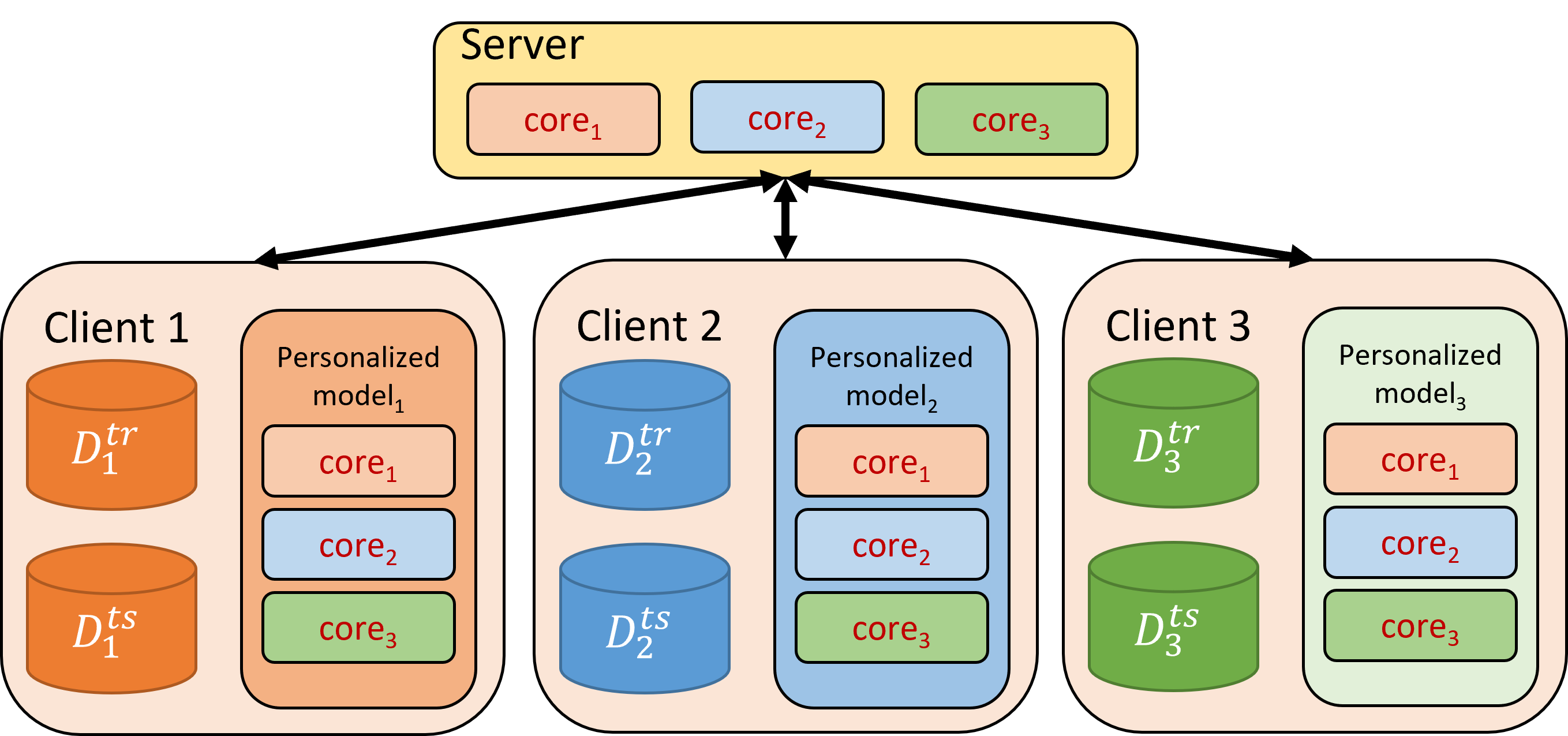

Conventional federated learning (FL) trains one global model for a federation of clients with decentralized data, reducing the privacy risk of centralized training. However, the distribution shift across non-IID datasets, often poses a challenge to this one-model-fits-all solution. Personalized FL aims to mitigate this issue systematically. In this work, we propose APPLE, a personalized cross-silo FL framework that adaptively learns how much each client can benefit from other clients' models. We also introduce a method to flexibly control the focus of training APPLE between global and local objectives. We empirically evaluate our method's convergence and generalization behaviors, and perform extensive experiments on two benchmark datasets and two medical imaging datasets under two non-IID settings. The results show that the proposed personalized FL framework, APPLE, achieves state-of-the-art performance compared to several other personalized FL approaches in the literature. The code is publicly available at https://github.com/ljaiverson/pFL-APPLE.

翻译:常规联邦学习(FL)为拥有分散数据的客户联合会培训一种全球模式,以减少集中培训的隐私风险。然而,在非IID数据集之间的分布转移往往对这个一模一样的全方位解决方案构成挑战。个性化FL旨在系统地缓解这一问题。在这项工作中,我们提出PAPLE,这是一个个性化的跨Sillo FL框架,适应性地了解每个客户可从其他客户模式中受益的程度。我们还引入了灵活控制全球和地方目标之间培训APLE重点的方法。我们实证地评估了我们方法的趋同和一般化行为,并在两个非IID设置下对两个基准数据集和两个医疗成像数据集进行了广泛的实验。结果显示,拟议的个性化FL框架APPLE与文献中其他个个性化FL方法相比,实现了最先进的业绩。该代码公布在https://github.com/ljaiverson/pFL-APPLLE。