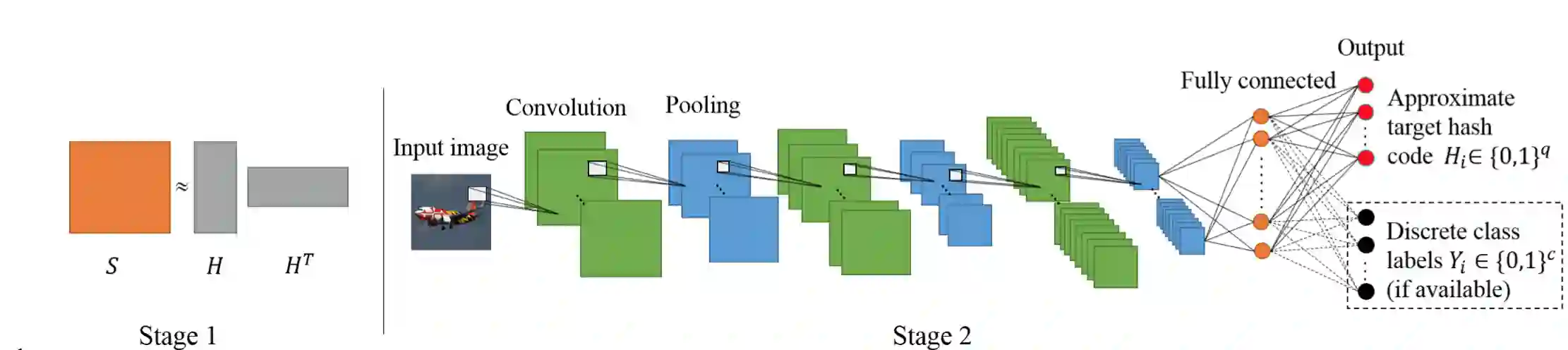

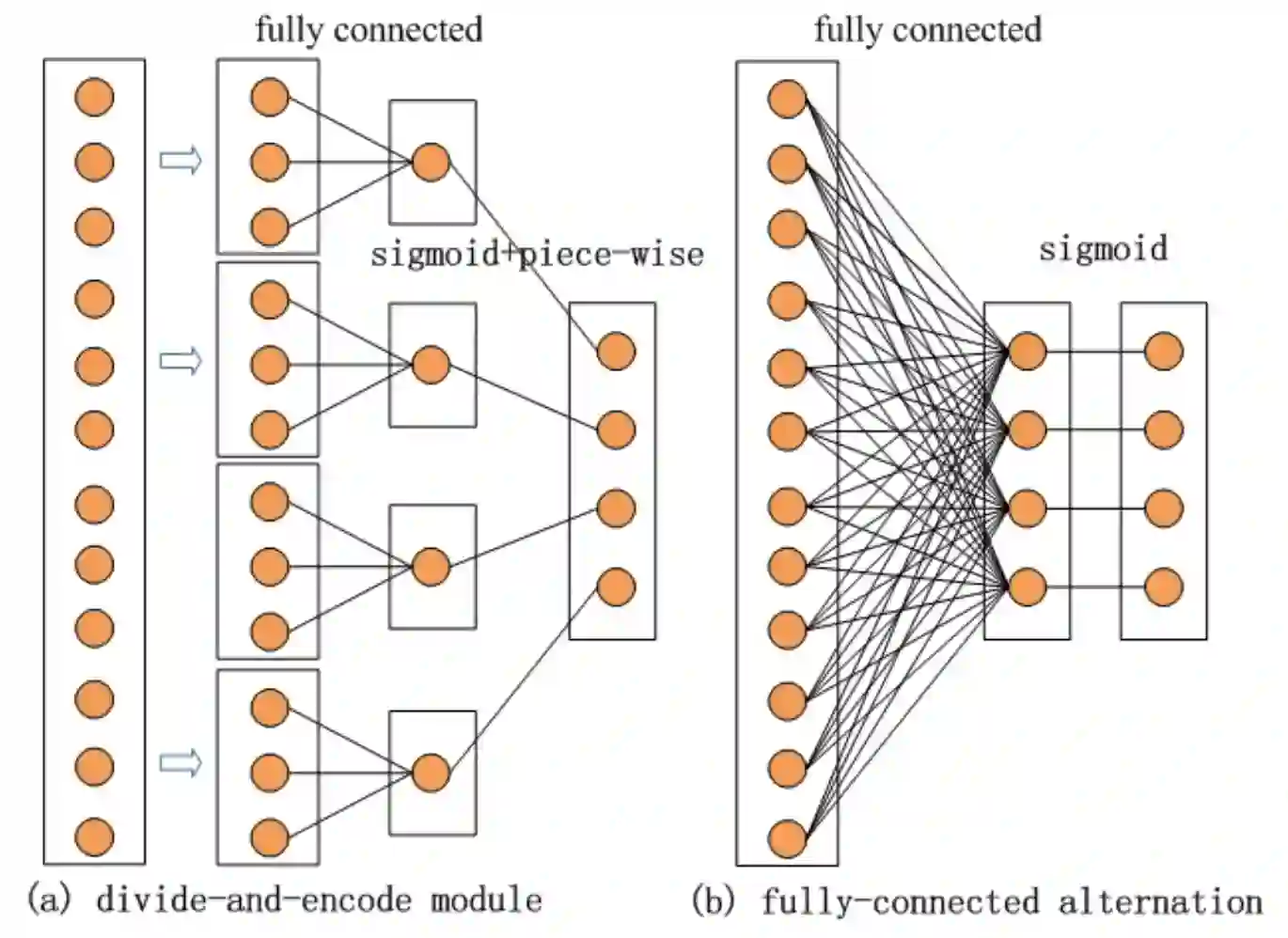

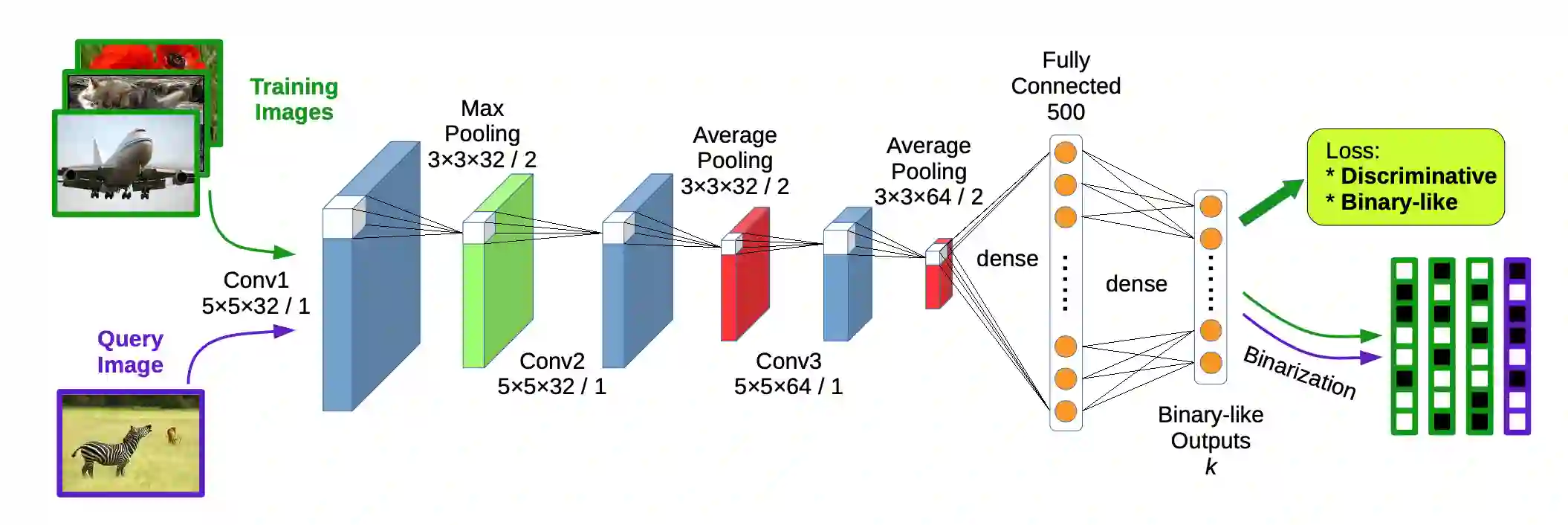

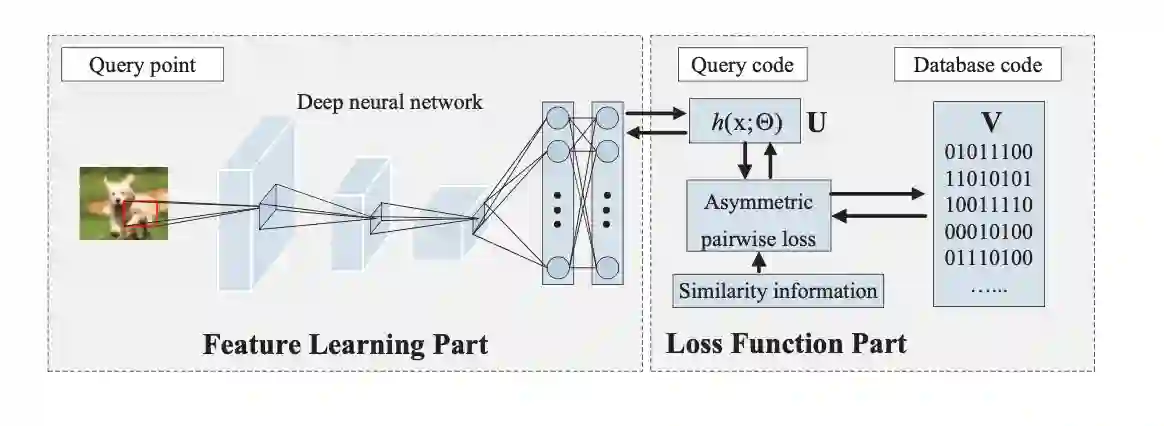

Hashing has been widely used in approximate nearest search for large-scale database retrieval for its computation and storage efficiency. Deep hashing, which devises convolutional neural network architecture to exploit and extract the semantic information or feature of images, has received increasing attention recently. In this survey, several deep supervised hashing methods for image retrieval are evaluated and I conclude three main different directions for deep supervised hashing methods. Several comments are made at the end. Moreover, to break through the bottleneck of the existing hashing methods, I propose a Shadow Recurrent Hashing(SRH) method as a try. Specifically, I devise a CNN architecture to extract the semantic features of images and design a loss function to encourage similar images projected close. To this end, I propose a concept: shadow of the CNN output. During optimization process, the CNN output and its shadow are guiding each other so as to achieve the optimal solution as much as possible. Several experiments on dataset CIFAR-10 show the satisfying performance of SRH.

翻译:大量散列被广泛用于近近距离的大规模数据库检索的计算和储存效率。深散列(深散列)设计了革命性神经网络结构,以利用和提取图像的语义信息或特征。深散列(深散列)最近受到越来越多的关注。在这次调查中,对几处深度监督的图像检索散列方法进行了评估,我得出了对深层监督散列方法的三个主要不同方向。在最后提出了若干评论意见。此外,为了打破现有散列方法的瓶颈,我提议了一种暗影常态散列(SRH)方法作为尝试。具体地说,我设计了一个CNN(CN)结构,以提取图像的语义特征,设计一种损失功能,鼓励近似预测的图像。为此,我提出了一个概念:CNN的影子。在优化过程中,CNN输出及其影子相互引导,以便尽可能实现最佳的解决方案。关于CFAR-10数据设置的若干实验显示了SRH的令人满意的表现。