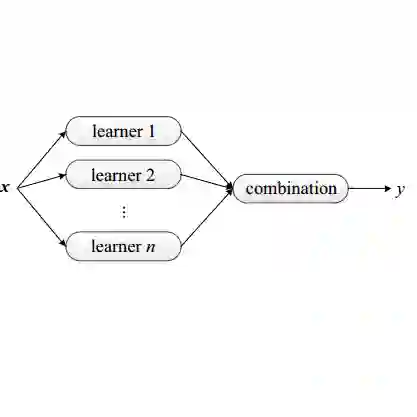

Domain adaptation is an attractive approach given the availability of a large amount of labeled data with similar properties but different domains. It is effective in image classification tasks where obtaining sufficient label data is challenging. We propose a novel method, named SELDA, for stacking ensemble learning via extending three domain adaptation methods for effectively solving real-world problems. The major assumption is that when base domain adaptation models are combined, we can obtain a more accurate and robust model by exploiting the ability of each of the base models. We extend Maximum Mean Discrepancy (MMD), Low-rank coding, and Correlation Alignment (CORAL) to compute the adaptation loss in three base models. Also, we utilize a two-fully connected layer network as a meta-model to stack the output predictions of these three well-performing domain adaptation models to obtain high accuracy in ophthalmic image classification tasks. The experimental results using Age-Related Eye Disease Study (AREDS) benchmark ophthalmic dataset demonstrate the effectiveness of the proposed model.

翻译:鉴于有大量具有类似性质但不同域的标签数据,域适应是一种有吸引力的方法。在获得足够的标签数据具有挑战性的情况下,域适应在图像分类任务中是有效的。我们提出了一个名为 SELDA的新颖方法,通过扩展三个领域适应方法堆叠共性学习,以有效解决现实世界问题。主要假设是,当基础域适应模型合并起来时,我们可以通过利用每个基模型的能力获得更准确和健全的模型。我们扩展了最大平均值差异(MMD)、低级别编码和校正对齐(CORAL),以计算三个基模型中的适应损失。此外,我们利用一个双维连接层网络作为元模型,堆叠这三种良好领域适应模型的产出预测,以获得眼科图像分类任务的高度精确性。使用年龄相关眼病研究基准眼科数据集的实验结果证明了拟议模型的有效性。