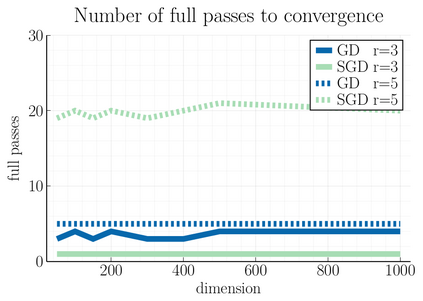

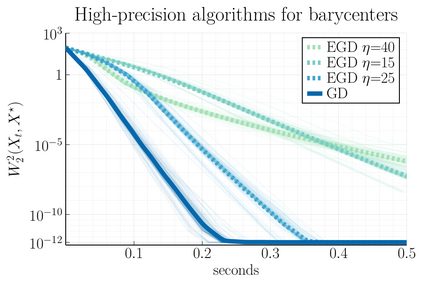

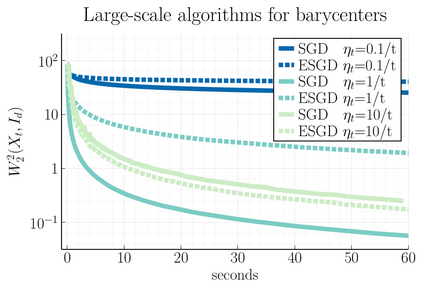

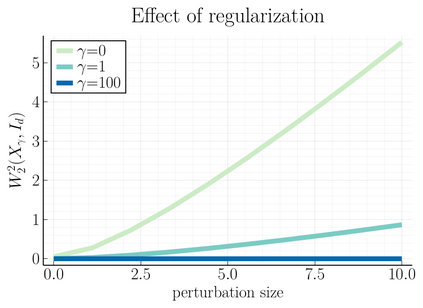

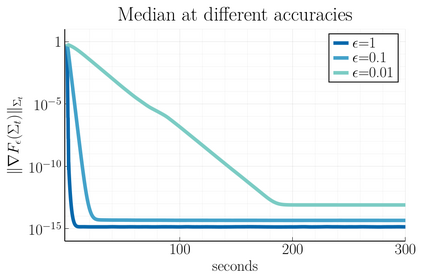

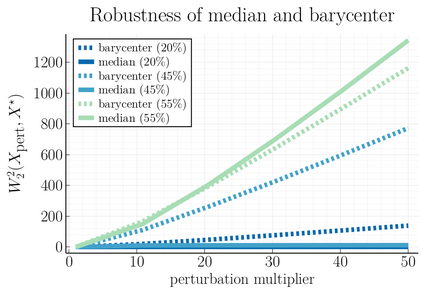

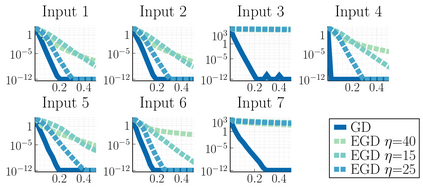

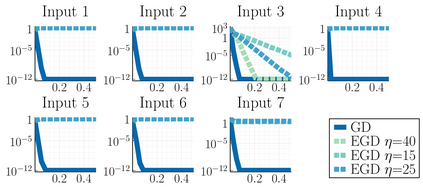

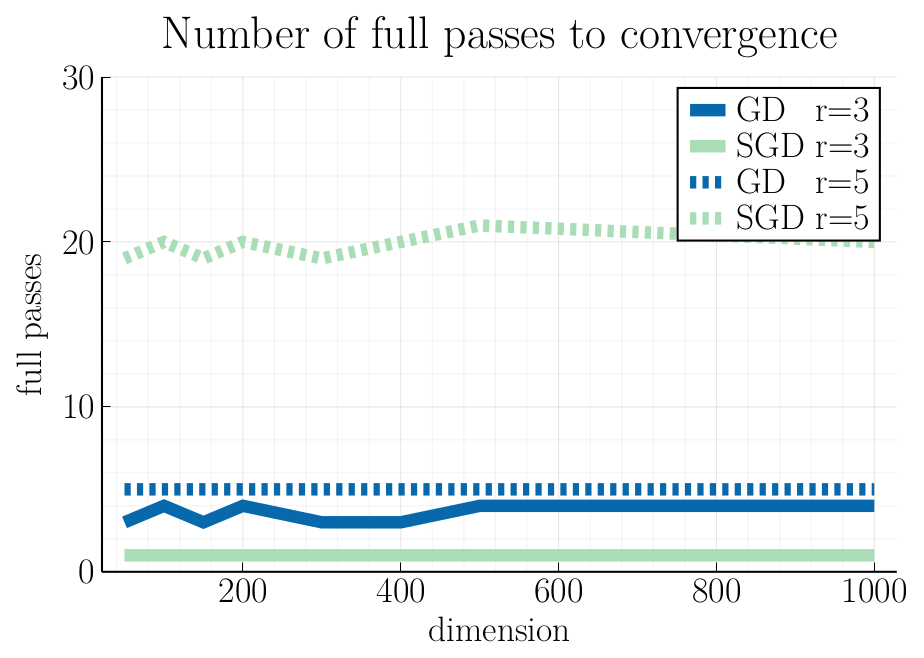

We study first-order optimization algorithms for computing the barycenter of Gaussian distributions with respect to the optimal transport metric. Although the objective is geodesically non-convex, Riemannian GD empirically converges rapidly, in fact faster than off-the-shelf methods such as Euclidean GD and SDP solvers. This stands in stark contrast to the best-known theoretical results for Riemannian GD, which depend exponentially on the dimension. In this work, we prove new geodesic convexity results which provide stronger control of the iterates, yielding a dimension-free convergence rate. Our techniques also enable the analysis of two related notions of averaging, the entropically-regularized barycenter and the geometric median, providing the first convergence guarantees for Riemannian GD for these problems.

翻译:我们研究了用于计算高斯分布的重心的一阶优化算法,其中度量采用最优传输度量。虽然目标在测地意义下是非凸的,但实践表明Riemannian GD的收敛速度比Euclidean GD和SDP求解器等现成的方法更快。这与Riemannian GD的最佳已知理论结果形成了鲜明对比,后者在维数上有着指数级的依赖关系。在本文中,我们证明了新的测地凸性结果,提供了更强的控制迭代的方式,从而获得了无维收敛率。我们的技术还使得能够分析两个相关的平均值概念,即熵正则化的重心和几何中位数,为Riemannian GD首次提供了这些问题的收敛保证。