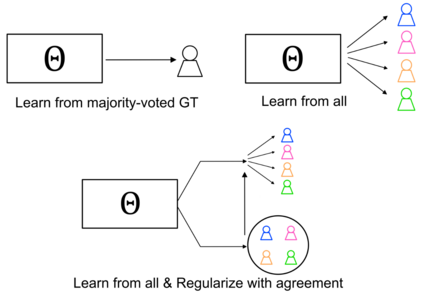

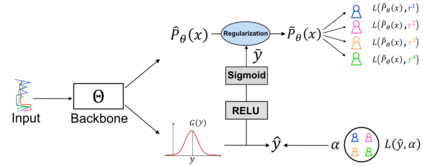

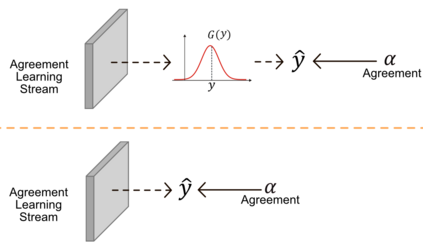

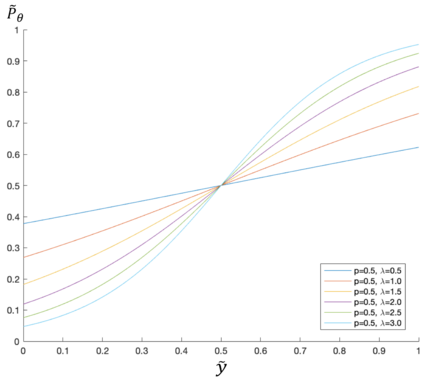

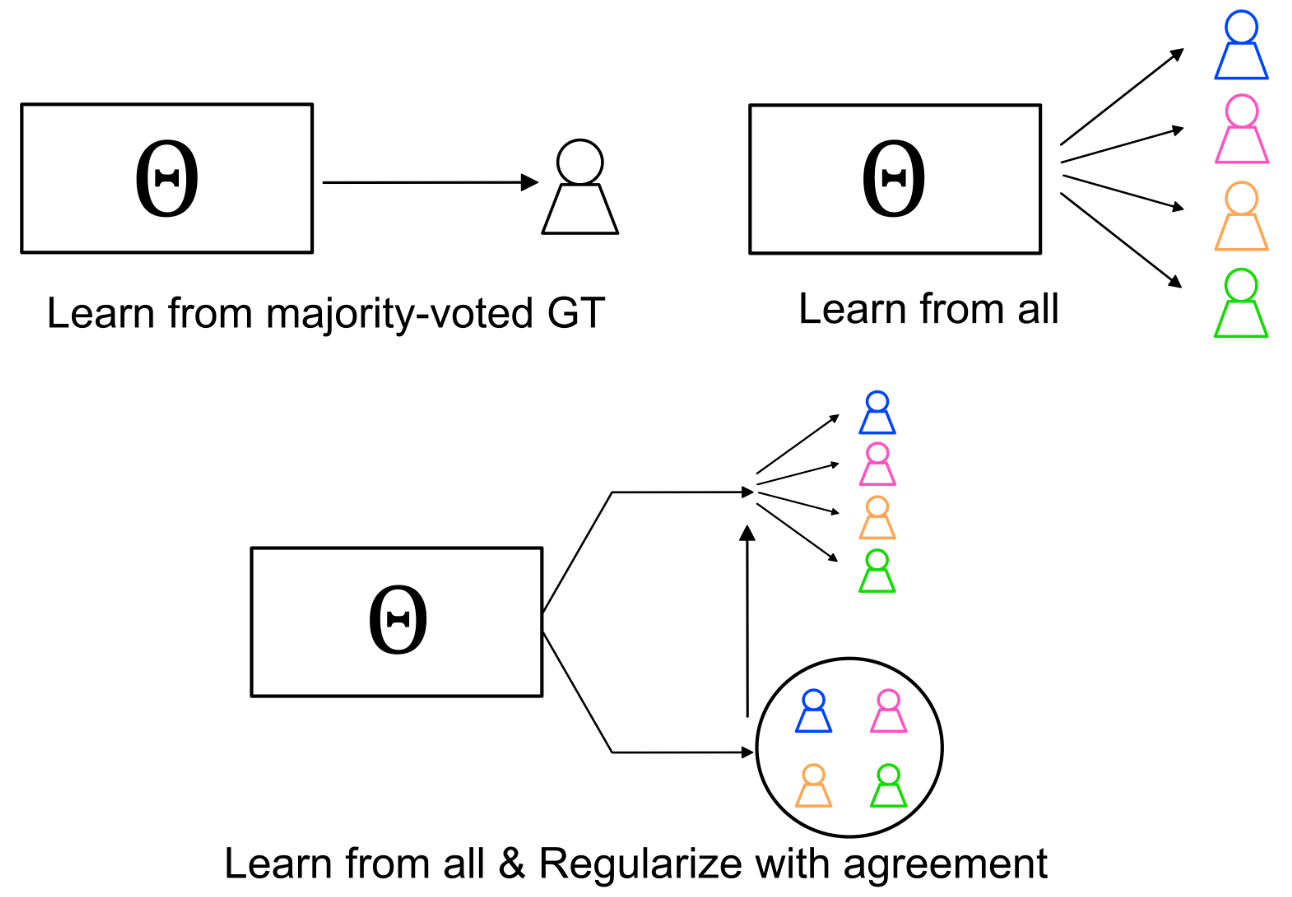

The annotation of domain experts is important for some medical applications where the objective groundtruth is ambiguous to define, e.g., the rehabilitation for some chronic diseases, and the prescreening of some musculoskeletal abnormalities without further medical examinations. However, improper uses of the annotations may hinder developing reliable models. On one hand, forcing the use of a single groundtruth generated from multiple annotations is less informative for the modeling. On the other hand, feeding the model with all the annotations without proper regularization is noisy given existing disagreements. For such issues, we propose a novel agreement learning framework to tackle the challenge of learning from multiple annotators without objective groundtruth. The framework has two streams, with one stream fitting with the multiple annotators and the other stream learning agreement information between the annotators. In particular, the agreement learning stream produces regularization information to the classifier stream, tuning its decision to be better in line with the agreement between the annotators. The proposed method can be easily plugged to existing backbones developed with majority-voted groundtruth or multiple annotations. Thereon, experiments on two medical datasets demonstrate improved agreement levels with annotators.

翻译:在一些医疗应用中,如果客观的地貌真相模糊不清,无法界定某些慢性疾病的康复和预先筛选某些肌肉骨骼异常而不进行进一步体检,则对域专家的说明很重要;然而,对说明的不当使用可能妨碍开发可靠的模型;一方面,强迫使用从多个注解产生的单一地貌真相对于建模而言没有多少信息;另一方面,由于现有的分歧,在没有适当正规化的情况下以所有说明的方式向模型提供模型是吵闹的。对于这些问题,我们提议一个新的协议学习框架,以解决从多个没有客观地貌的注解者那里学习的挑战。这个框架有两个流,其中一条流与多个注解者相适应,另一条流学习信息则会妨碍设计可靠的模型。特别是,协议学习流会为分类者提供正规化信息,使其决定与说明者之间的协议更加一致。所提议的方法可以很容易地插到现有骨架上,由多数票的地貌或多个注解。因此,关于两个医学数据平台的实验展示了协议的改进程度。