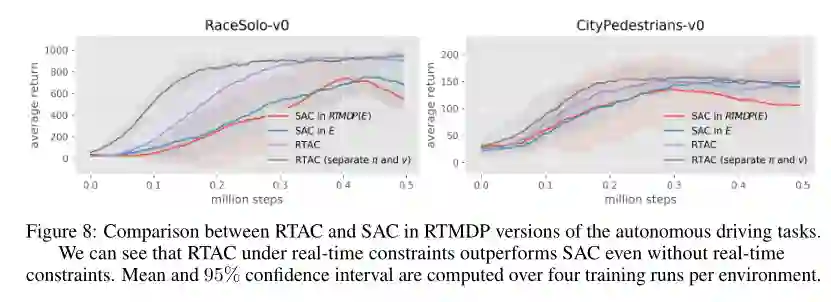

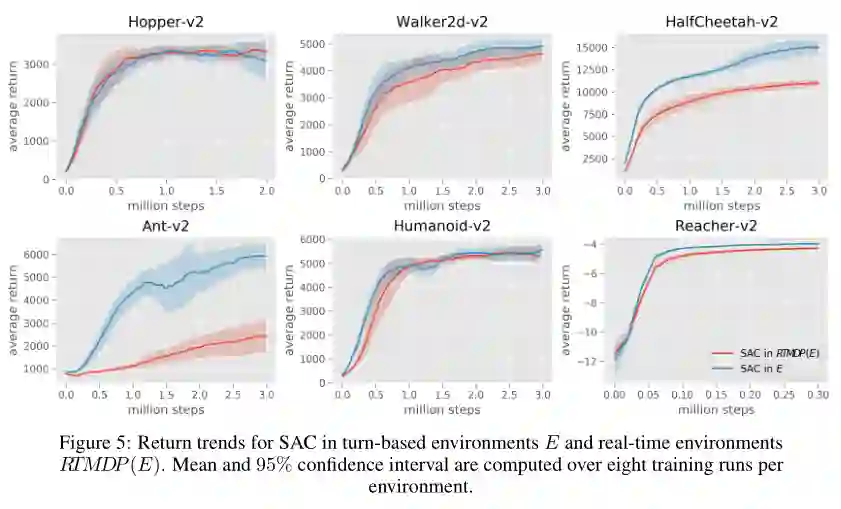

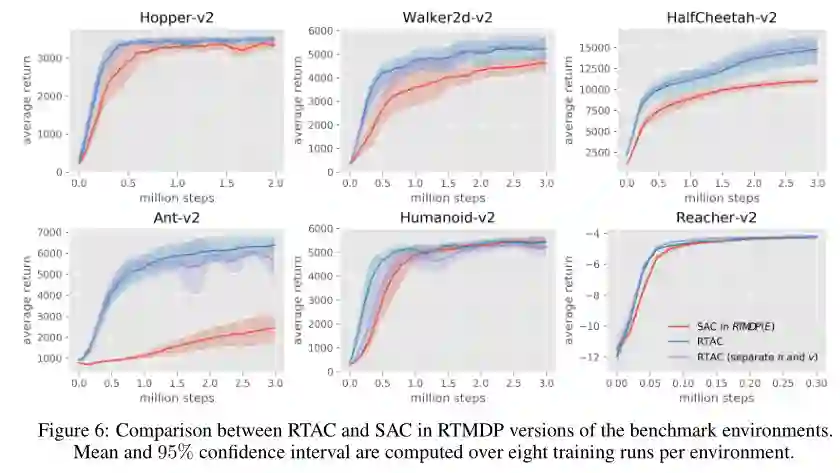

摘要: 马尔可夫决策过程(MDPs)是大多数强化学习(RL)算法的数学框架,它经常被错误地假设在操作选择过程中代理环境的状态不变。当基于MDPs的RL系统开始在现实世界的安全临界情况下得到应用时,这种经典MDPs假设与实时计算现实之间的不匹配可能会导致不希望的结果。在这篇论文中,我们介绍了一个新的框架,在这个框架中状态和动作同时演化,并展示了它是如何与经典的MDP公式相联系的。我们分析了现有的算法在新的实时公式和显示为什么他们是次优时,在实时使用。然后,我们利用这些见解来创建一个新的算法实时角色评价(RTAC),它在实时和非实时设置方面都优于现有的最先进的连续控制算法软角色评价。代码和视频可以在<github.com/rmst/rtrl>找到。

作者介绍:

Simon Ramstedt,他是蒙特利尔Mila的Chris Pal的计算机科学专业研究生。以前,他曾在Redmond的Microsoft Research实习,并在TU Darmstadt 的Intelligent Autonomous Systems Group上大学。他的主要兴趣是深度强化学习和机器人技术。

Christopher Pal,蒙特利尔大学(Université de Montréal)教授,他的研究方向是人工智能,计算机视觉和模式识别,计算摄影,自然语言处理,统计机器学习及其在人机交互中的应用。

成为VIP会员查看完整内容

相关内容

Christopher Pal,蒙特利尔大学(Université de Montréal)教授,他的研究方向是人工智能,计算机视觉和模式识别,计算摄影,自然语言处理,统计机器学习及其在人机交互中的应用。

专知会员服务

24+阅读 · 2019年11月11日

专知会员服务

13+阅读 · 2019年10月3日