题目: Gradient Surgery for Multi-Task Learning

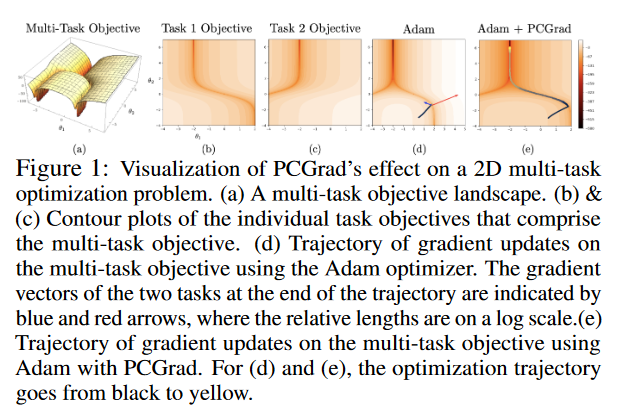

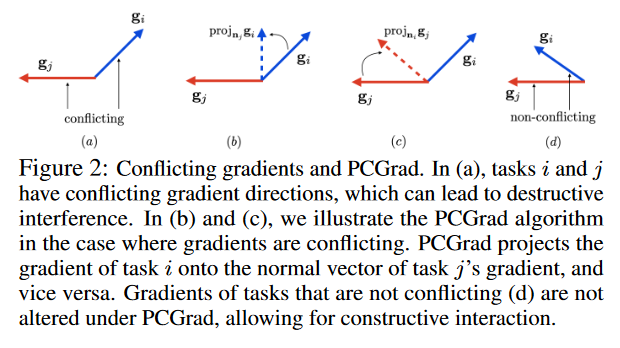

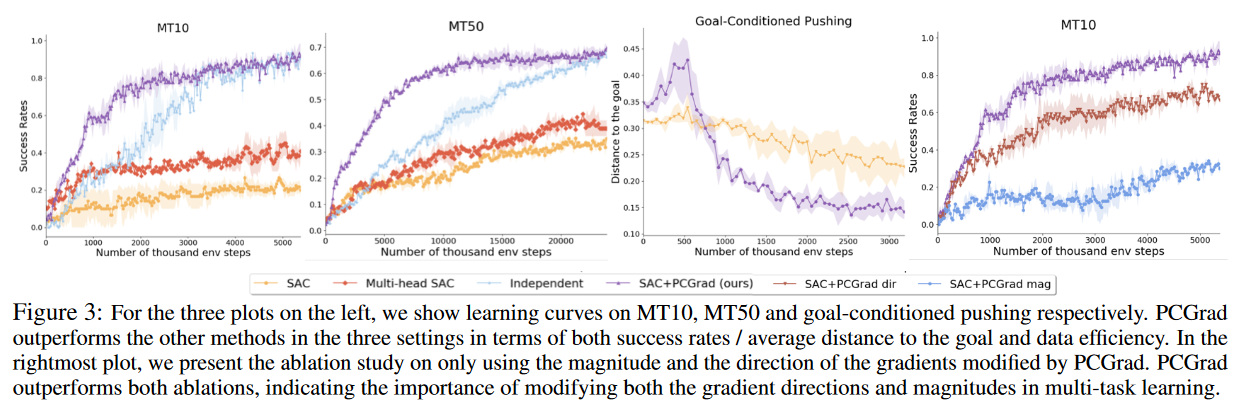

摘要: 虽然深度学习和深度强化学习(RL)系统在图像分类、游戏和机器人控制等领域取得了令人印象深刻的成果,但数据效率仍然是一个重大挑战。多任务学习是一种很有前途的跨任务共享结构的学习方法。然而,多任务设置带来了许多优化挑战,与独立学习任务相比,很难实现大的效率提升。与单任务学习相比,多任务学习之所以具有如此大的挑战性,其原因还不完全清楚。在这项工作中,我们确定了多任务优化环境中导致有害梯度干扰的三个条件,并开发了一种简单而通用的方法来避免任务梯度之间的这种干扰。我们提出一种梯度手术的形式,将一个任务的梯度投影到任何其他具有冲突梯度的任务的梯度的法平面上。在一系列具有挑战性的多任务监督和多任务RL问题上,该方法在效率和性能上都有显著提高。此外,它与模型无关,可以与先前提出的多任务体系结构相结合以提高性能。

作者简介: Tianhe Yu,加州大学伯克利分校研究助理。官方主页:https://tianheyu927.github.io/等

成为VIP会员查看完整内容

相关内容

专知会员服务

131+阅读 · 2020年4月19日