输入梯度惩罚与参数梯度惩罚的一个不等式

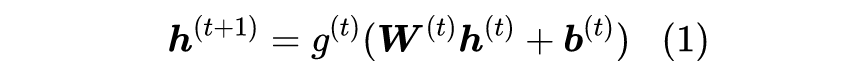

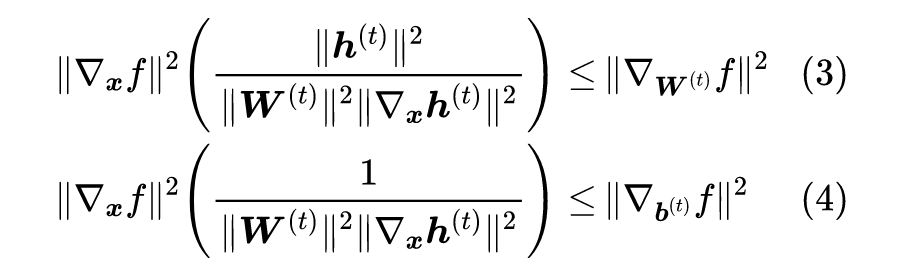

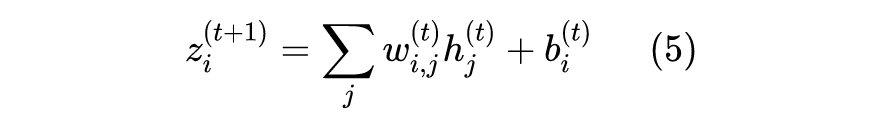

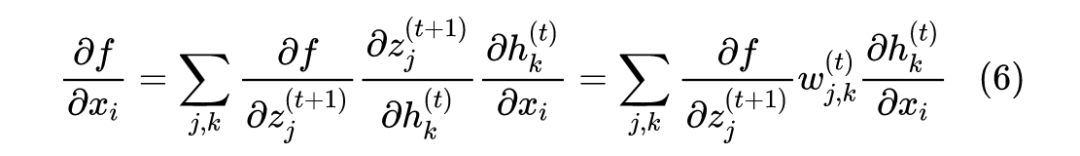

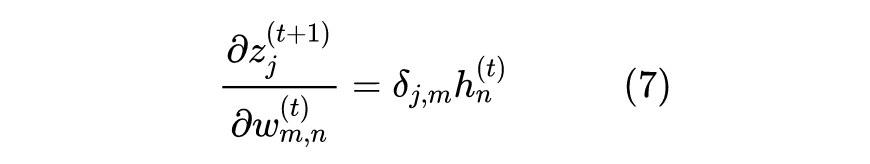

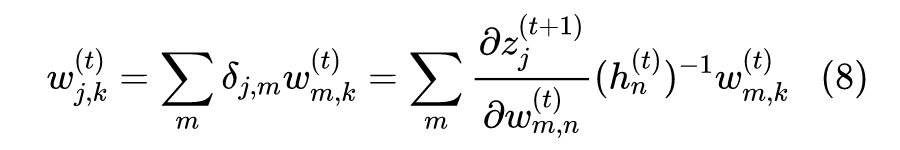

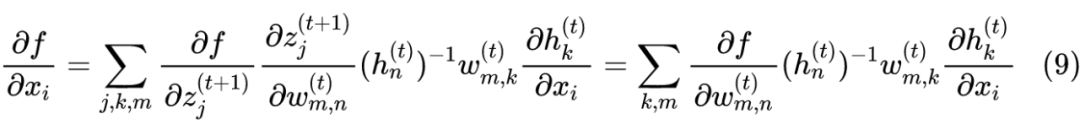

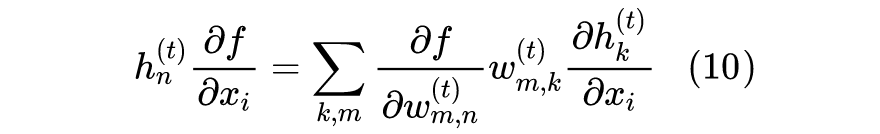

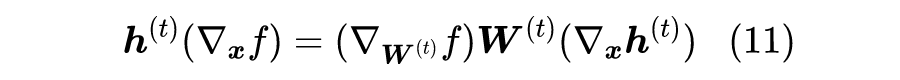

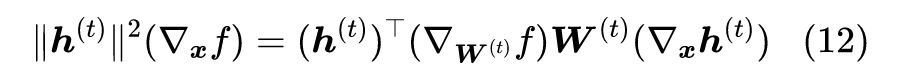

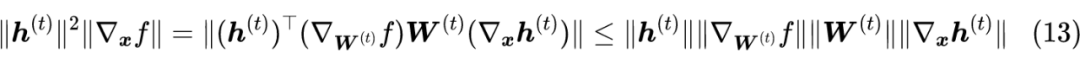

推导过程

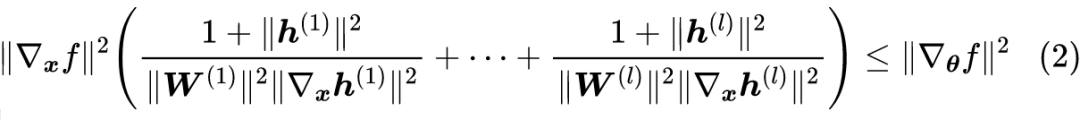

可能有读者会想问具体该如何理解式(2)?事实上,笔者主要觉得式(2)本身有点意思,以后说不准在某个场景用得上,所以本文主要是对此做个“笔记”,但对它并没有很好的解读结果。

至于原论文的逻辑顺序是这样的:在《从动力学角度看优化算法(五):为什么学习率不宜过小?》中我们介绍了《Implicit Gradient Regularization》(跟本篇论文同一作者),里边指出 SGD 隐式地包含了对参数的梯度惩罚项,而式(2)则说明对参数的梯度惩罚隐式地包含了对输入的梯度惩罚,而对输入的梯度惩罚又跟 Dirichlet 能量有关,Dirichlet 能量则可以作为模型复杂度的表征。所以总的一串推理下来,结论就是:SGD 本身会倾向于选择复杂度比较小的模型。

文章小结

参考文献

特别鸣谢

感谢 TCCI 天桥脑科学研究院对于 PaperWeekly 的支持。TCCI 关注大脑探知、大脑功能和大脑健康。

更多阅读

#投 稿 通 道#

让你的文字被更多人看到

如何才能让更多的优质内容以更短路径到达读者群体,缩短读者寻找优质内容的成本呢?答案就是:你不认识的人。

总有一些你不认识的人,知道你想知道的东西。PaperWeekly 或许可以成为一座桥梁,促使不同背景、不同方向的学者和学术灵感相互碰撞,迸发出更多的可能性。

PaperWeekly 鼓励高校实验室或个人,在我们的平台上分享各类优质内容,可以是最新论文解读,也可以是学术热点剖析、科研心得或竞赛经验讲解等。我们的目的只有一个,让知识真正流动起来。

📝 稿件基本要求:

• 文章确系个人原创作品,未曾在公开渠道发表,如为其他平台已发表或待发表的文章,请明确标注

• 稿件建议以 markdown 格式撰写,文中配图以附件形式发送,要求图片清晰,无版权问题

• PaperWeekly 尊重原作者署名权,并将为每篇被采纳的原创首发稿件,提供业内具有竞争力稿酬,具体依据文章阅读量和文章质量阶梯制结算

📬 投稿通道:

• 投稿邮箱:hr@paperweekly.site

• 来稿请备注即时联系方式(微信),以便我们在稿件选用的第一时间联系作者

• 您也可以直接添加小编微信(pwbot02)快速投稿,备注:姓名-投稿

△长按添加PaperWeekly小编

🔍

现在,在「知乎」也能找到我们了

进入知乎首页搜索「PaperWeekly」

点击「关注」订阅我们的专栏吧