【泡泡一分钟】基于云服务实现FastSLAM 2.0中的定位与建图

每天一分钟,带你读遍机器人顶级会议文章

标题:FastSLAM 2.0 tracking and mapping as a Cloud Roboticsservice

作者:Shimaa S. Ali, Abdallah Hammad, Adly S. Tag Eldien

来源:Computers and Electrical Engineering 2017

播音员:申影

编译:鲁涛

欢迎个人转发朋友圈;其他机构或自媒体如需转载,后台留言申请授权

摘要

大家好,今天为大家带来的文章是——基于云服务实现FastSLAM 2.0中的定位与建图,该文章发表于CEE2017。

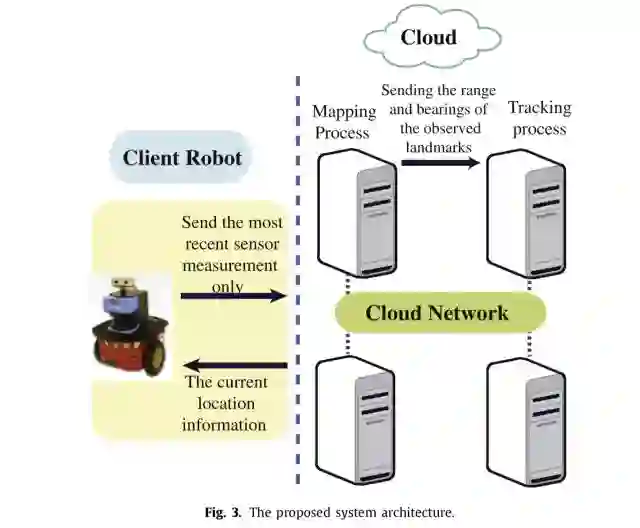

同时定位与构建地图(SLAM)任务的计算量非常大,十分耗时。位姿跟踪阶段的实时性是一个比较棘手的问题。若想获得机器人精准的位置信息,系统需要在可接受的延迟时间内估计出位姿变化。原始的FastSLAM2.0是个基于粒子滤波器设计的系统,每个粒子都包含了机器人定位问题以及地标物位置估计问题。本文的系统基于分布式的架构,将FastSLAM2.0设计成在云端执行的Map/Reduce过程,每个Map任务处理一个粒子,然后用一个Reduce任务挑选出最好的粒子,从而实现了跟踪和建图同时作为云端的服务进行操作。因此,机器人的板上系统不需要进行密集的运算。作者在公共数据集上与当前最好的系统进行了比对。结果表明,与单个机器人的执行结果相比,云端对跟踪任务的计算代价降低了83.6%。系统框图如下:

文章最后,作者列举了三个实验,分别是节点数量不同时的计算代价分析、跟踪延迟分析以及在公共数据集上的效率测试,本文的分布式系统展示了良好的性能。笔者认为,对于本文的分布式FastSLAM系统,时间不光耗费在SLAM任务本身,主从节点之间的数据传输、分布式系统的任务调度及存储器读写等过程在真实场景中花费的时间也具有一定的不可控性,对于跟踪这样的、对实时性要求较高的任务,本文的方法是否可以直接落地,仍值得进一步探讨。欢迎大家在留言区留言讨论。

Abstract

The Simultaneous Localization and Mapping (SLAM) by an autonomous robot is an intensive computational problem and is considered to be time consuming process. A majorlimitation of the pose tracking is the real-time constraint. The pose estimation should bedone at an acceptable latency to get accurate position information. In this paper, Fast-SLAM 2.0 approach is proposed, where the computational process is divided into two par-allel tasks, the pose tracking and the map optimization. The presented work depends ona distributed architecture where the tracking and mapping tasks concurrently operate asa service in the Cloud. Therefore, the robot onboard system is freed from all the heavycomputations. The experiments are performed on public dataset comparable to state-of-the-art techniques. The results show that the computational cost of the tracking process inthe Cloud is reduced by 83.6% as compared to its execution on a single robot platform.

如果你对本文感兴趣,想要下载完整文章进行阅读,可以关注【泡泡机器人SLAM】公众号(paopaorobot_slam)。

点击阅读原文,即可获取本文下载链接。

泡泡机器人SLAM的原创内容均由泡泡机器人的成员花费大量心血制作而成,希望大家珍惜我们的劳动成果,转载请务必注明出自【泡泡机器人SLAM】微信公众号,否则侵权必究!同时,我们也欢迎各位转载到自己的朋友圈,让更多的人能进入到SLAM这个领域中,让我们共同为推进中国的SLAM事业而努力!

商业合作及转载请联系liufuqiang_robot@hotmail.com