7 Papers & Radios | 用神经网络推开数学推理大门;世界首个宏基因组蛋白质图谱

机器之心 & ArXiv Weekly Radiostation

参与:杜伟、楚航、罗若天

本周重要论文包括中山大学人机物智能融合实验室(HCP Lab)在数学解题领域的一系列研究,以及 Meta AI 用 150 亿参数语言模型预测 6 亿+宏基因组蛋白质结构图谱。

目录:

Semantically-Aligned Universal Tree-Structured Solver for Math Word Problems

GeoQA: A Geometric Question Answering Benchmark Towards Multimodal Numerical Reasoning

A Policy-Guided Imitation Approach for Offline Reinforcement Learning

Evolutionary-scale rediction of atomic level protein structure with a language model

Data-Free Neural Architecture Search via Recursive Label Calibration

Transformers in Remote Sensing: A Survey

Superconducting Optoelectronic Single-photon Synapses

ArXiv Weekly Radiostation:NLP、CV、ML 更多精选论文(附音频)

论文 1:Semantically-Aligned Universal Tree-Structured Solver for Math Word Problems

作者:Jinghui Qin 等

论文地址:https://aclanthology.org/2020.emnlp-main.309.pdf

摘要:一个实用的数学应用题求解器应该能够解决各种类型的数学应用题,如一元一次方程,二元一次方程组,一元二次方程等类型。然而大多数的数学应用题求解工作只针对四则运算类题目进行设计,而这类设计往往难以扩展到更多题型,无法使用一个统一的数学应用题求解器同时求解各种类型表达式的应用题。此外,当下的大部分数学应用题求解器缺乏对题目文本和求解表达式之间的语义约束。

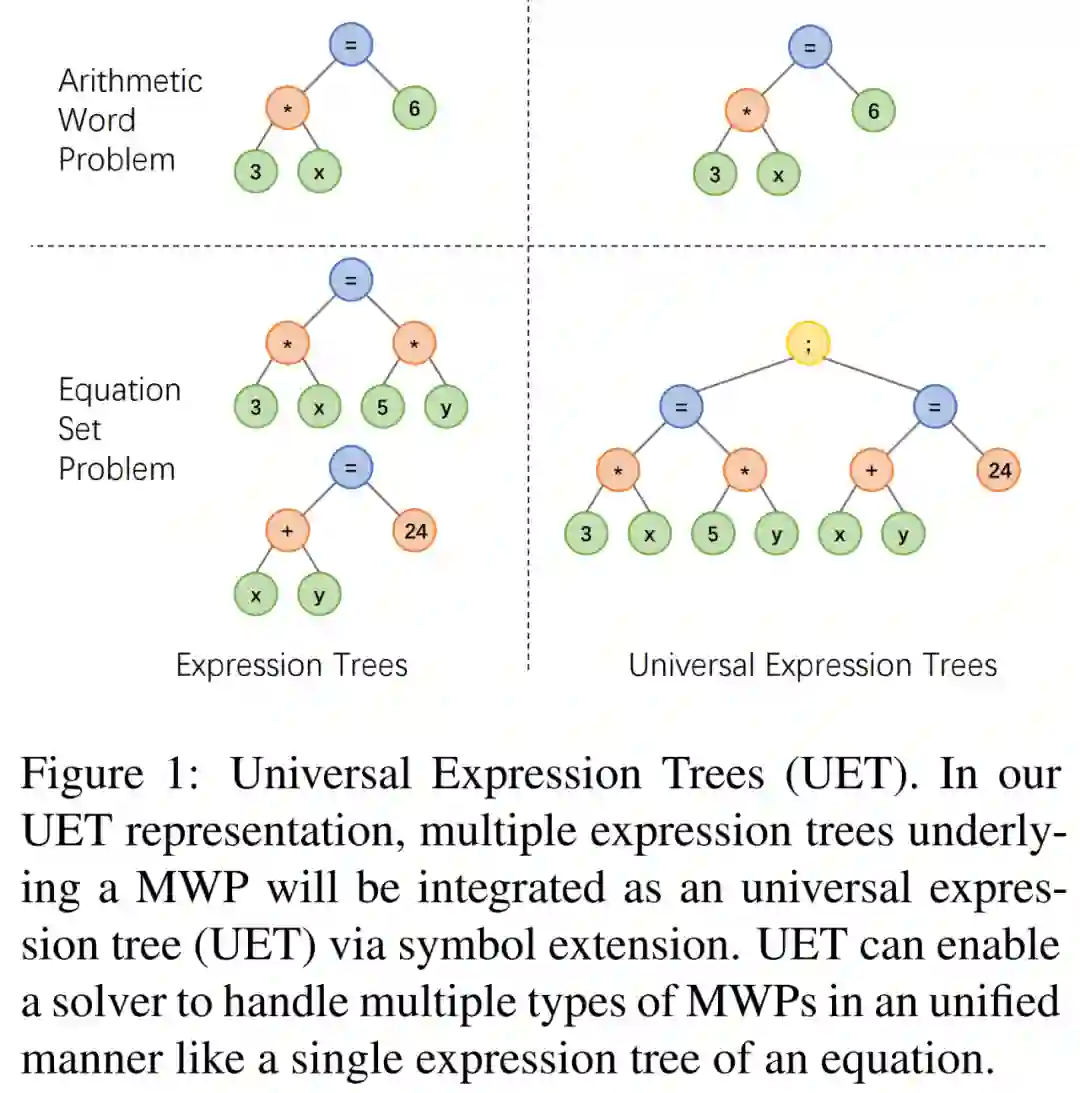

针对上述问题,中山大学人机物智能融合实验室团队提出一种统一表达式树表示方案,通过引入额外的运算符连结多个表达式,将一元一次方程,二元一次方程组,一元二次方程等类型的表达式进行统一表示,从而可以简化求解器的设计的同时也可以求解多种类型的应用题,如下图所示。

推荐:中山大学 HCP Lab 团队:AI 解题新突破,神经网络推开数学推理大门(1)。

论文 2:GeoQA: A Geometric Question Answering Benchmark Towards Multimodal Numerical Reasoning

作者:Jiaqi Chen 等

论文地址:https://arxiv.org/pdf/2105.14517.pdf

摘要:自动数学解题最近获得了越来越多的关注,大多数工作关注数学应用题自动求解。然而很少工作关注几何题。相比较于数学应用题,几何题需要同时对文本描述、图形图表进行理解,因为在几何题目中,题目文本和图形图表通常是相辅相成,缺一不可的。现有的几何题自动求解方法高度依赖规则并只在小数据集上进行评估。

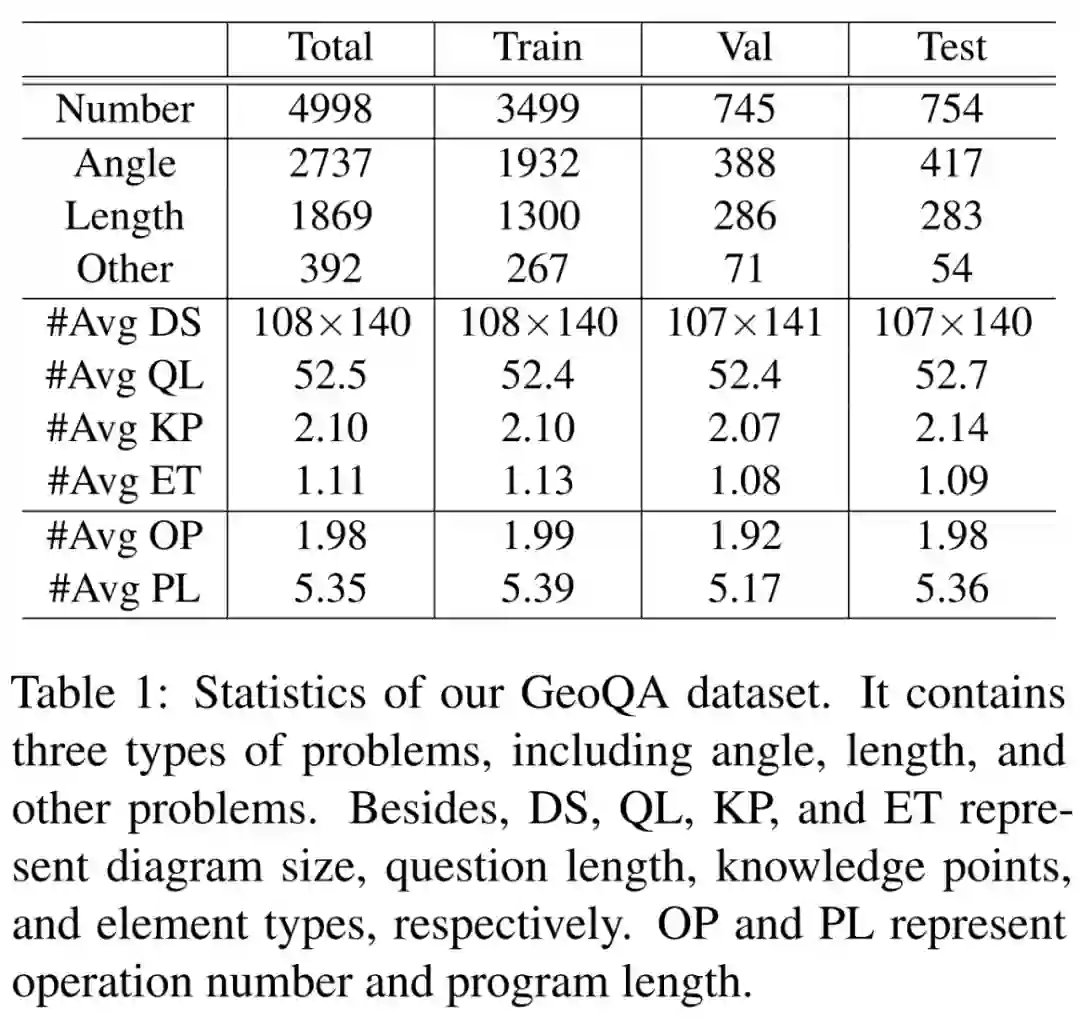

为了推动几何题自动求解的研究,中山大学人机物智能融合实验室团队构建了一个由 5010 道几何选择题组成的问答数据集 GeoQA。如图所示,GeoQA 数据集中的每一个样本具有题目描述、几何图像、问题选项、答案、问题类型、知识点、解答解析,以及按解题步骤标注的形式程序。在题目规模上,该数据集是前人工作常用的 GeoS 数据集的 25 倍。

推荐:中山大学 HCP Lab 团队:AI 解题新突破,神经网络推开数学推理大门(2)。

论文 3:A Policy-Guided Imitation Approach for Offline Reinforcement Learning

作者:Haoran Xu 等

论文地址:https://arxiv.org/pdf/2210.08323.pdf

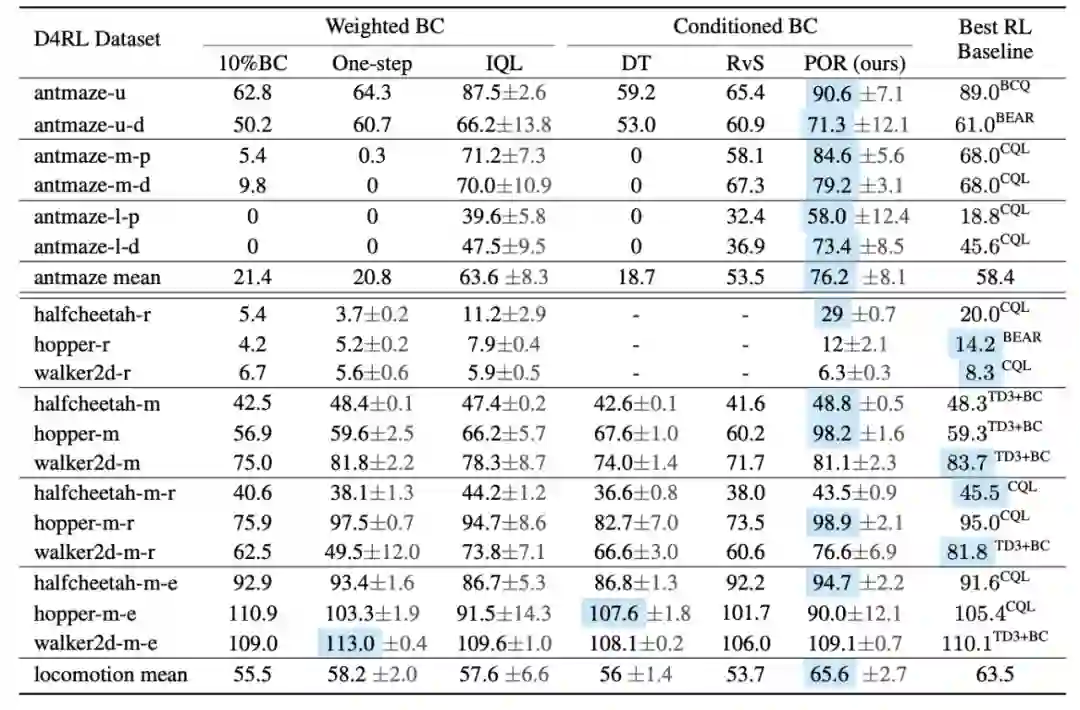

摘要:本文中,新方法 POR 对离线强化学习算法的策略评估和策略提升过程进行解耦式学习,完成了状态连接的思想。POR 既拥有了训练的稳定性,也拥有了稳定的逻辑范围内的数据外的泛化能力,在基准上表现惊人,并提出了该解耦式学习范式的潜在好处。

推荐:NeurIPS 2022 Oral | 离线强化学习新范式!京东科技 & 清华提出解耦式学习算法。

论文 4:Evolutionary-scale Rediction of Atomic Level Protein Structure with a Language Model

作者:Zeming Lin 等

论文地址:https://www.biorxiv.org/content/10.1101/2022.07.20.500902v2

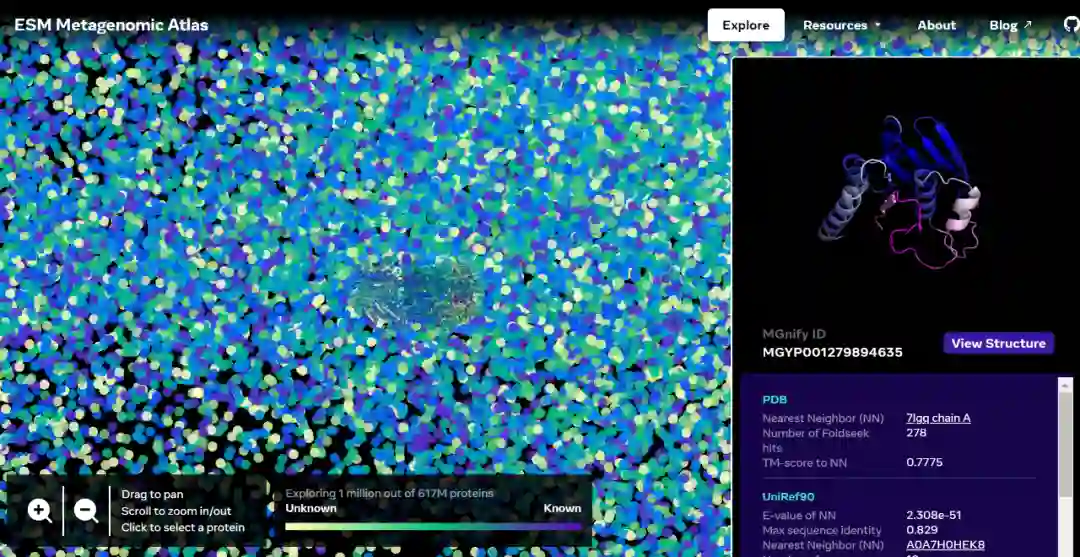

摘要:Meta AI 宣布推出包含 6 亿多个蛋白质的 ESM 宏基因组图谱(ESM Metagenomic Atlas),它是首个蛋白质宇宙「暗物质」的综合视图。这还是最大的高分辨率预测结构数据库,比任何现有的蛋白质结构数据库都要大 3 倍,并且是第一个全面、大规模地涵盖宏基因组蛋白质的数据库。

推荐:世界首个!Meta AI 开放 6 亿 + 宏基因组蛋白质结构图谱,150 亿参数语言模型用两周完成。

论文 5:Data-Free Neural Architecture Search via Recursive Label Calibration

作者:Zechun Liu 等

论文地址:https://arxiv.org/abs/2112.02086

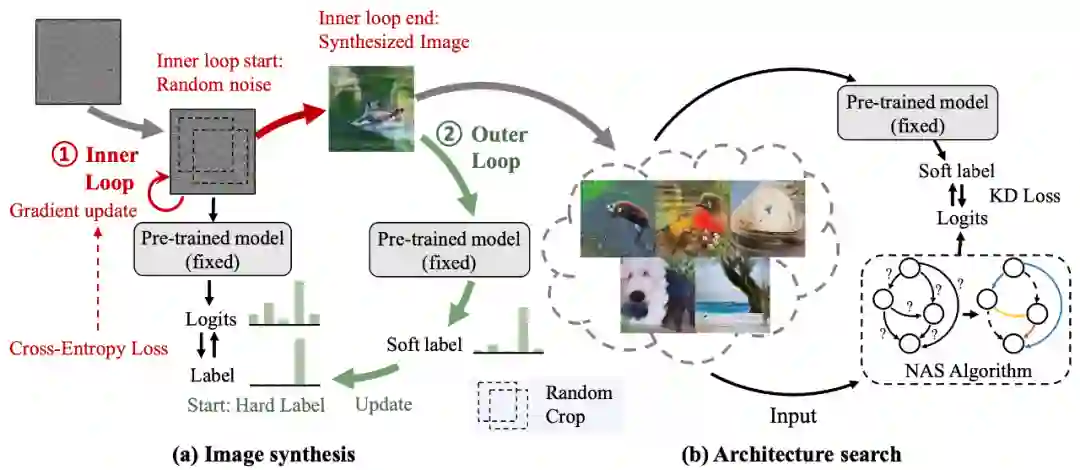

摘要:神经网络架构搜索 (NAS) 自 2016 年提出以来就广受关注,很多工作通过设计搜索空间,提升搜索算法等提升 NAS 的精度。今天这篇文章主要研究如何将 NAS 用于数据缺失的情况,文中提出 data-free NAS,该架构仅需要一个预训练模型,就可以自动进行网络搜索。目前该方法主要研究图片领域。

推荐:ECCV 2022 | 谷歌提出 Data-free NAS,网络搜索仅需一个预训练模型。

论文 6:Transformers in Remote Sensing: A Survey

作者:Abdulaziz Amer Aleissaee 等

论文地址:https://arxiv.org/pdf/2209.01206.pdf

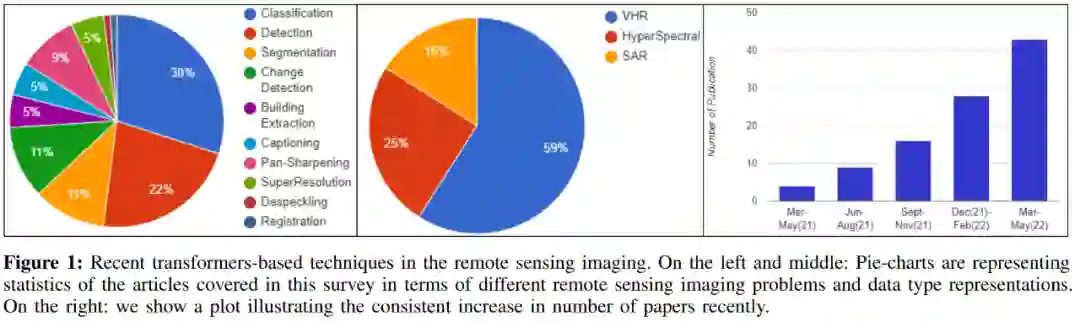

摘要:过去十年,深度学习算法在遥感图像分析中得到广泛应用。最初引入到 NLP 领域的 transformer 已经渗透到计算机视觉领域。遥感社区也是如此,他们见证了视觉 transformer 用于各种任务的增加。不过到目前为止许多调查都集中在计算机视觉中的 transformer,而关于遥感方面的调查却很少。

本文系统回顾了遥感中使用基于 transformer 的最新进展,多达 60 多种方法,这些方法可用于解决遥感子领域中不同的遥感问题:超高分辨率 (VHR)、高光谱 (HSI) 和合成孔径雷达 (SAR) 图像。

推荐:回顾 60 多种 transformer 研究,一文总结遥感领域最新进展。

论文 7:Superconducting Optoelectronic Single-photon Synapses

作者:Saeed Khan 等

论文地址:https://www.nature.com/articles/s41928-022-00840-9

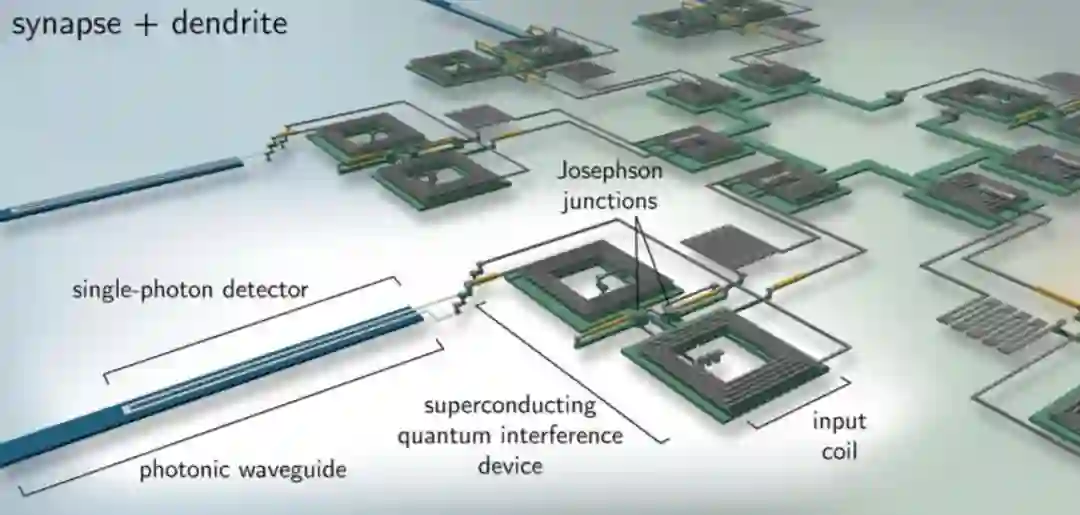

摘要:AI 系统越来越受限于为实现其功能的硬件。现在,一种新的超导光子电路问世,它可模拟脑细胞之间的连接。这仅需消耗人类具有同类功能细胞能量的 0.3% ,而运行速度却可提高约 30000 倍。相关论文在《自然 · 电子学》上发表。

推荐:超高效人工光电神经元成真?速度比自然神经元快 3 万倍,研究登 Nature 子刊。

本周 10 篇 NLP 精选论文是:

1. Open-Vocabulary Argument Role Prediction for Event Extraction. (from Jiawei Han)

2. Topic Taxonomy Expansion via Hierarchy-Aware Topic Phrase Generation. (from Jiawei Han)

3. Characterizing Intrinsic Compositionality In Transformers With Tree Projections. (from Christopher D. Manning)

4. You can't pick your neighbors, or can you? When and how to rely on retrieval in the $k$NN-LM. (from Andrew McCallum)

5. When Life Gives You Lemons, Make Cherryade: Converting Feedback from Bad Responses into Good Labels. (from Jason Weston)

6. Inverse scaling can become U-shaped. (from Quoc V. Le)

7. Beyond prompting: Making Pre-trained Language Models Better Zero-shot Learners by Clustering Representations. (from Roger Wattenhofer)

8. Knowledge-in-Context: Towards Knowledgeable Semi-Parametric Language Models. (from Hongming Zhang)

9. Fine-Tuning Pre-Trained Language Models Effectively by Optimizing Subnetworks Adaptively. (from Jia Li)

10. Learning to Decompose: Hypothetical Question Decomposition Based on Comparable Texts. (from Dan Roth)

本周 10 篇 CV 精选论文是:

1. Breaking the Symmetry: Resolving Symmetry Ambiguities in Equivariant Neural Networks. (from Leonidas Guibas)

2. SufrinNet: Toward Sufficient Cross-View Interaction for Stereo Image Enhancement in The Dark. (from Yi Yang, Shuicheng Yan)

3. Video Event Extraction via Tracking Visual States of Arguments. (from Jiajie Zhang, Shih-Fu Chang)

4. Contextual Learning in Fourier Complex Field for VHR Remote Sensing Images. (from Yan Zhang, Xinbo Gao)

5. Rethinking Hierarchicies in Pre-trained Plain Vision Transformer. (from Dacheng Tao)

6. CircleSnake: Instance Segmentation with Circle Representation. (from Agnes B. Fogo)

7. DyAnNet: A Scene Dynamicity Guided Self-Trained Video Anomaly Detection Network. (from Ig-Jae Kim)

8. Recovering Sign Bits of DCT Coefficients in Digital Images as an Optimization Problem. (from C.-C. Jay Kuo)

9. Saliency Can Be All You Need In Contrastive Self-Supervised Learning. (from Thomas Bäck)

10. UmeTrack: Unified multi-view end-to-end hand tracking for VR. (from Zheng Wang)

本周 10 篇 ML 精选论文是:

1. Can Current Explainability Help Provide References in Clinical Notes to Support Humans Annotate Medical Codes?. (from Philip S. Yu)

2. Adversarial Policies Beat Professional-Level Go AIs. (from Sergey Levine, Stuart Russell)

3. Optimal Conservative Offline RL with General Function Approximation via Augmented Lagrangian. (from Stuart Russell)

4. Learning to Navigate Wikipedia by Taking Random Walks. (from Rob Fergus)

5. Knowledge-Guided Exploration in Deep Reinforcement Learning. (from Bing Liu)

6. Efficient Automatic Machine Learning via Design Graphs. (from Jure Leskovec)

7. Improving Lipschitz-Constrained Neural Networks by Learning Activation Functions. (from Michael Unser)

8. Large Language Models Are Human-Level Prompt Engineers. (from Jimmy Ba)

9. LE3D: A Lightweight Ensemble Framework of Data Drift Detectors for Resource-Constrained Devices. (from Vijay Kumar)

10. Adversarial Auto-Augment with Label Preservation: A Representation Learning Principle Guided Approach. (from Dacheng Tao)

© THE END

转载请联系本公众号获得授权

投稿或寻求报道:content@jiqizhixin.com