【泡泡一分钟】ScanNet:一个室内场景三维重建标注数据集(CVPR-22)

每天一分钟,带你读遍机器人顶级会议文章

标题:ScanNet: Richly-annotated 3D Reconstructions of Indoor Scenes

作者:Angela Dai, Angel X. Chang, Manolis Savva, Maciej Halber, Thomas Funkhouser, Matthias Nießner

来源:CVPR 2017

编译:李仕杰

播音员:王肃

欢迎个人转发朋友圈;其他机构或自媒体如需转载,后台留言申请授权

摘要

今天介绍的文章是“ScanNet: Richly-annotated 3D Reconstructions of Indoor Scenes ”——ScanNet:一个室内场景三维重建标注数据集,该文章发表在CVPR 2017。

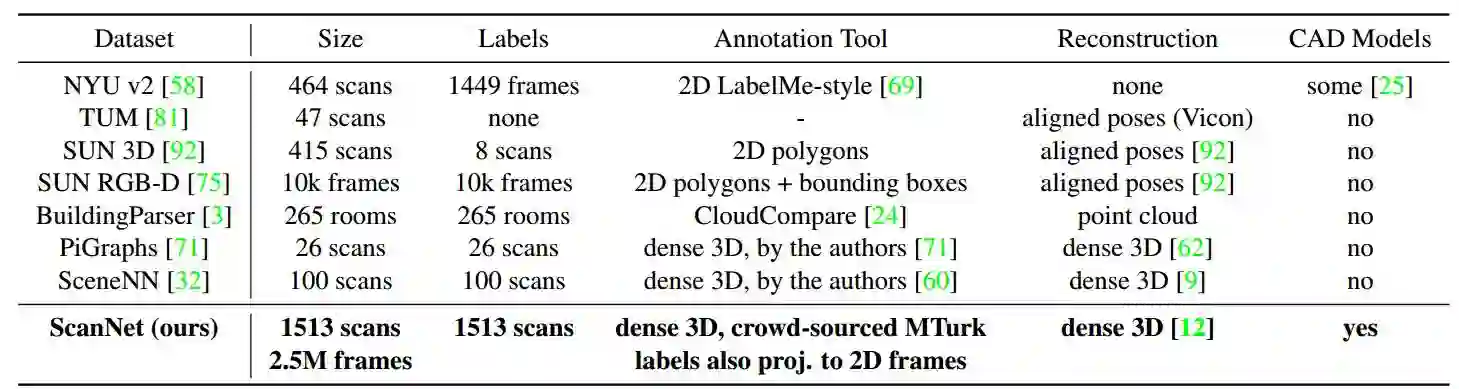

影响有监督深度学习方法的一个关键因素是大量标注的数据集。然而,在RGB-D场景理解这一问题上,现今的数据集只包含了一小部分场景和非常有限的标注。

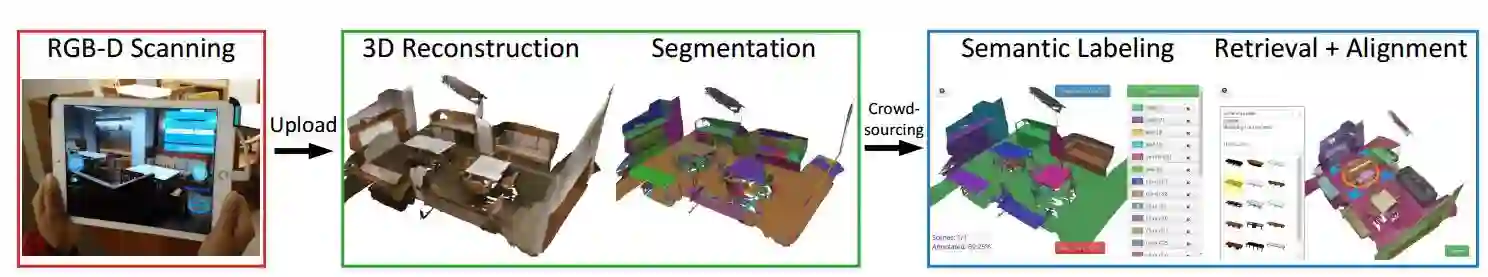

为了解决这一问题,我们引入了一个RGB-D视频数据集ScanNet。ScanNet包含1513个场景中的2.5M张图片。与此同时ScanNet还提供了相机位姿,平面重建和语义分割的标注。为了获得这些数据,我们设计了一个易于使用的RGB-D采集系统来进行平面重建和语义分割标注的工作。

我们的结果表明使用ScanNet在一些3D场景理解的任务上取得了非常好的结果。包括3D物体分类,voxel的语义分割和CAD模型的搜索

如果你对本文感兴趣,想要下载完整文章进行阅读,可以关注【泡泡机器人SLAM】公众号(paopaorobot_slam)。

回复关键字“ScanNet”,即可获取本文下载链接。

泡泡机器人SLAM的原创内容均由泡泡机器人的成员花费大量心血制作而成,希望大家珍惜我们的劳动成果,转载请务必注明出自【泡泡机器人SLAM】微信公众号,否则侵权必究!同时,我们也欢迎各位转载到自己的朋友圈,让更多的人能进入到SLAM这个领域中,让我们共同为推进中国的SLAM事业而努力!

商业合作及转载请联系liufuqiang_robot@hotmail.com