50.1%AP!D2Det:高质量目标检测和实例分割(已开源)

点击上方“CVer”,选择加"星标"置顶

重磅干货,第一时间送达

本文转载自:AI深度视线 | 论文已上传,文末附下载方式

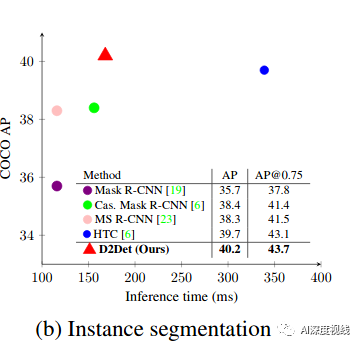

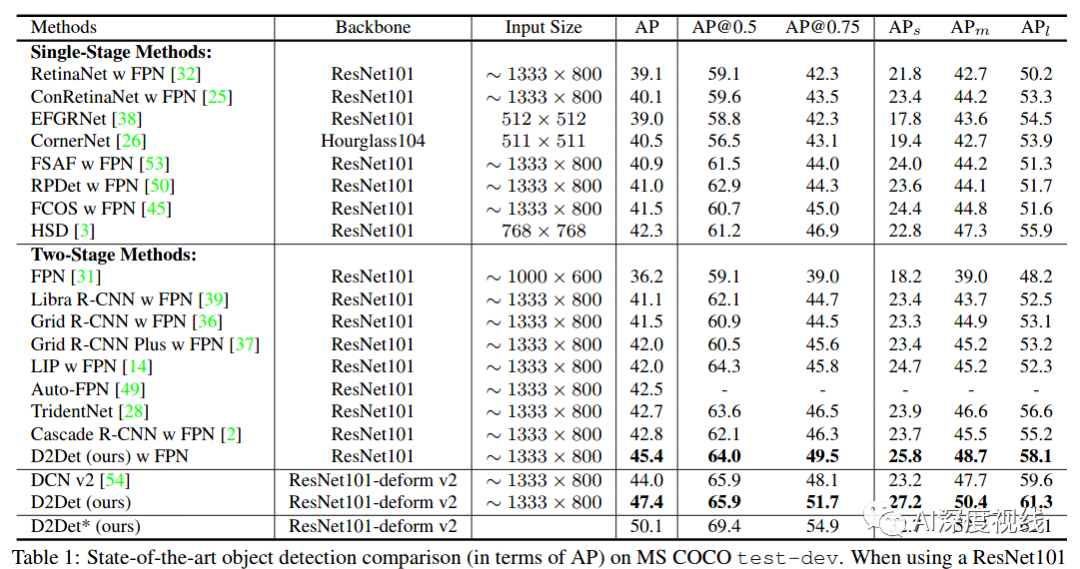

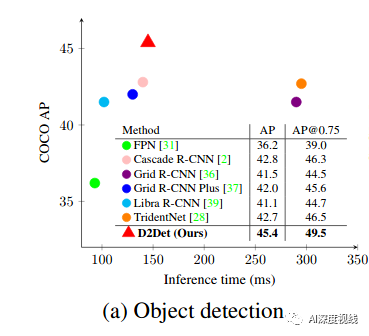

D2Det:致力于高质量的目标检测和实例分割 在COCO上可达50.1 AP!(多尺度训练)、47.4 AP(单尺度训练),性能优于Auto-FPN、TridentNet等网络。

文章链接:

后台回复关键字:D2Det

代码刚刚开源!

https://github.com/JialeCao001/D2Det

作者团队:天津大学&IIAI

1

摘要

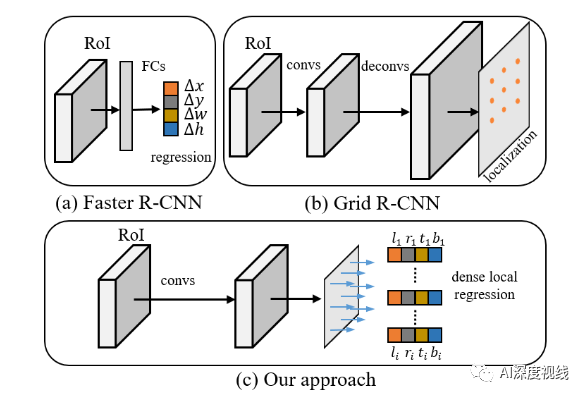

我们提出了一种新颖的两阶段检测方法D2Det,它可以同时解决精确定位和精确分类的问题。

为了精确定位:

-

引入了 密集局部回归 ,该回归可以预测object proposal的多个密集框偏移。 与两阶段检测器中使用的传统回归和基于关键点的定位不同,我们的密集局部回归不限于固定区域内的一组量化的关键点,并且具有回归位置敏感实数密集偏移的能力,从而导致更多精确的定位。通过减少背景区域对最终盒回归的影响的二进制重叠预测策略,进一步改善了密集局部回归。

为了进行准确的分类:

-

引入了 判别式RoI合并方案 ,该方案可从proposal的各个子区域进行采样,并执行自适应加权以获得判别式特征。

2

主要思路

大多数两级检测器基于预定义的anchor box在图像中表示每个对象。另外,一些单阶段方法提出了一个anchor free策略,消除了对anchor的需求。这通常涉及使用成对的关键点和关键点估计来检测目标边界框。这些方法都是自底向上的,因为关键点直接从整个图像生成,而不需要定义目标个体。

Grid RCNN的问题

目标定位问题

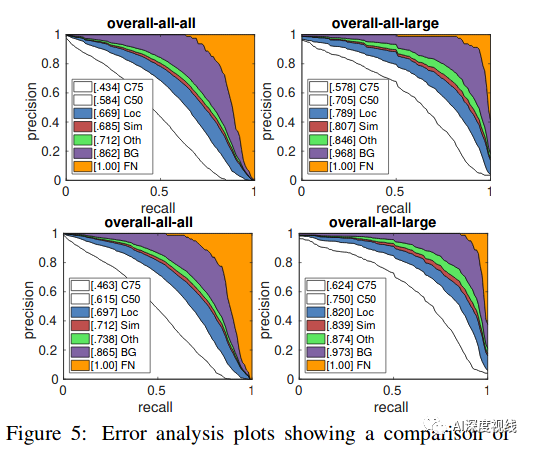

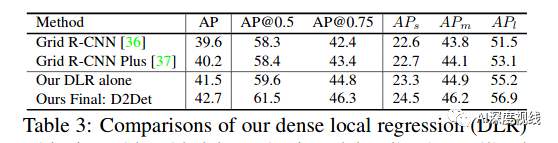

MS COCO上,与Grid R-CNN相比,我们单一的稠密局部回归(没有分类分支的改进)在大目标检测获得了3.7%的增益。

目标分类问题

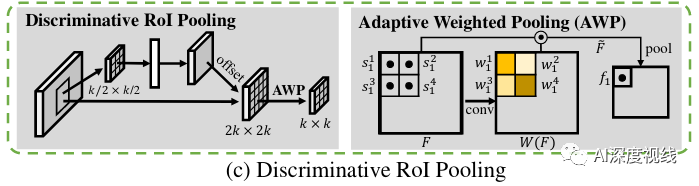

Grid R-CNN只注重于提高定位能力,与原始Faster-RCNN相比,并没有做大的改进,时保持了相似的原始分类分支。原来Faster-RCNN使用了RoIPool 对候选提案进行特征池,最近,RoIAlign在一些工作中取代了RoIPool。RoIAlign将候选方案划分为大小相同的空间子区域,并考虑方案内部子区域的特征。在每个子区域内得到4个采样点,并对所有采样点分配相等的权值进行平均。这可能会降低分类性能,因为区分区域可能不会出现在等距的子区域中。

本文介绍一种新方法,执行自适应加权,以增强区分特征分类。

3

具体实现

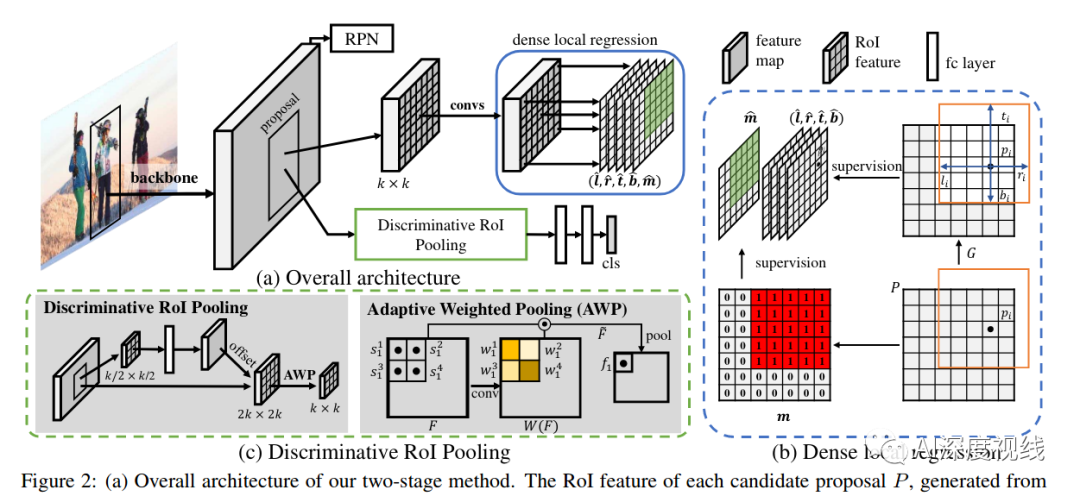

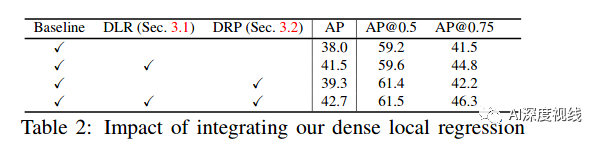

本文方法基于标准的Faster-R-CNN框架。在我们的方法中,提出的密集局部回归(第3.1节)代替了传统的更快的R-CNN的盒偏移回归,同时通过区分的RoI池来改进分类(第3.2节)。我们的两阶段检测框架的总体架构如图2(a)所示。

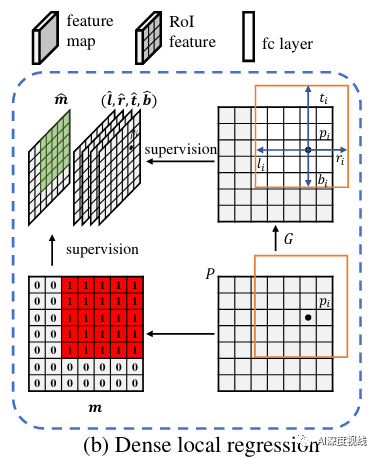

第一阶段采用区域建议网络(RPN),稠密的局部回归分支(图2(b))旨在对目标进行精确定位。

第二阶段采用独立的分类和回归分支。而基于区分RoI pooling的分类分支(图2(c))旨在改进候选方案的分类。

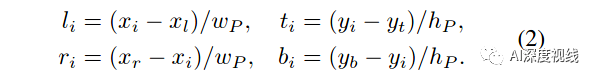

3.1 Dense Local Regression

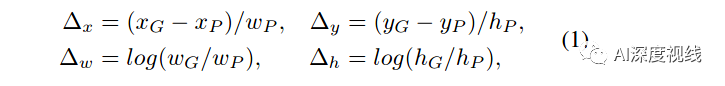

在两阶段的检测框架中,边界盒回归分支的目标是找到一个围绕对象的紧密边界盒。让P(xP, yP, wP, hP)作为候选目标,G(xG, yG, wG, hG)作为Ground Truth。FasterR-CNN中传统回归预测的边界盒偏移量(∆x,∆y,∆w,∆h)为:

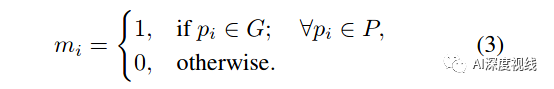

局部特征的数量取决于候选目标和GT的重合度,但是即使重合度高的时候,也会有非目标特征(例如背景特征)出现在这K2个局部特征中。为了处理这种情况,采用二元重合度预测来对每个局部特征进行分类:

-

与传统FasterR-CNN相比:

-

与GridR-CNN中使用的基于关键点的定位策略(图3(b))相比:

3.2 Discriminative RoI Pooling

首先,我们使用一种轻量级的偏移量预测,它需要大约四分之一的参数,与可变形RoIpooling中的标准偏移量预测相比。

标准偏移量预测采用RoIAlign操作从k×k子区域中获取特征,并将这些特征通过三个完全连通的层。相反,轻量级偏移预测只需要一个k/2 * k/2大小的RoIAlign,然后是完全连接的层(轻量级是因为更小的输入向量)。

其次在偏移量预测之后,标准的deformable RoIpooling使用一个RoIAlign,在每个子区域内获得的四个采样点都被平均分配相等的权值。与此相反,本文提出的加权pooling的目的是自适应地分配更高的权值给discriminative的采样点。例如下图中的右图,不同的采样点s1~s4被赋予不同的权值w1~w4。

注意:落在discriminative RoI pooling中的预测偏移量样本。所提取的特征很可能包含与目标及其上下文相关的识别信息,有望进一步提高分类性能。

3.3 Instance Segmentation

4

实验结果

4.1 COCO结果比较

基准比较

量化分析

消融实验

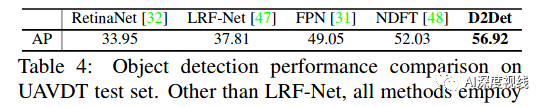

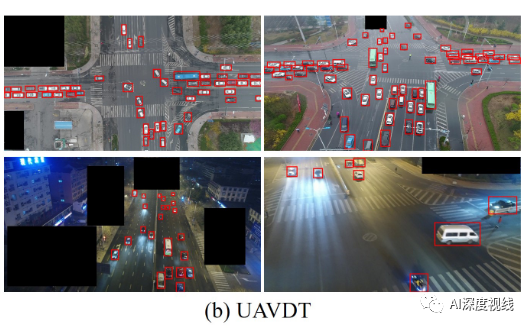

4.2 UAVDT结果比较

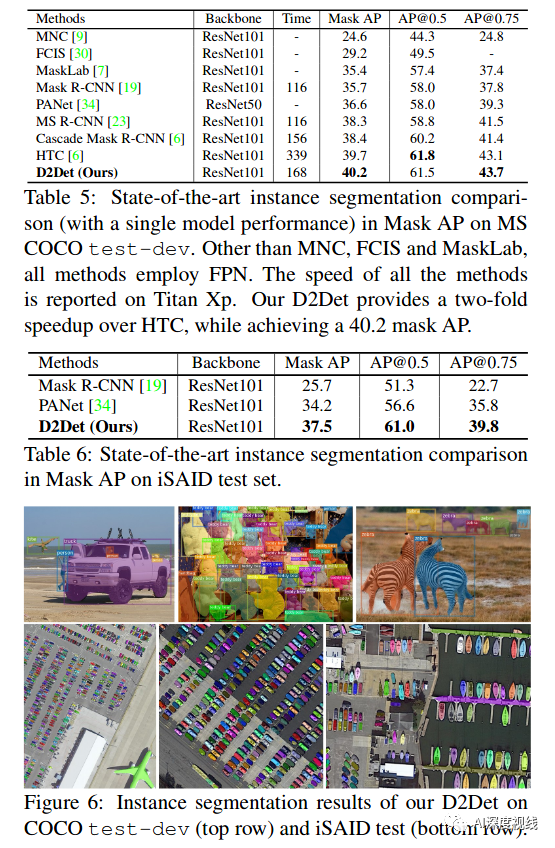

4.3 实例分割结果比较

论文下载

在CVer公众号后台回复:D2Det,即可下载本论文

重磅!CVer-目标检测 微信交流群已成立

扫码添加CVer助手,可申请加入CVer-目标检测 微信交流群,目前已汇集4000人!涵盖2D/3D目标检测、小目标检测、遥感目标检测等。互相交流,一起进步!

同时也可申请加入CVer大群和细分方向技术群,细分方向已涵盖:目标检测、图像分割、目标跟踪、人脸检测&识别、OCR、姿态估计、超分辨率、SLAM、医疗影像、Re-ID、GAN、NAS、深度估计、自动驾驶、强化学习、车道线检测、模型剪枝&压缩、去噪、去雾、去雨、风格迁移、遥感图像、行为识别、视频理解、图像融合、图像检索、论文投稿&交流、PyTorch和TensorFlow等群。

一定要备注:研究方向+地点+学校/公司+昵称(如目标检测+上海+上交+卡卡),根据格式备注,可更快被通过且邀请进群

▲长按加群

▲长按关注我们

麻烦给我一个在看