眼见为实?其实是“脑补”!华人数学家解开视觉奥秘:一切都是大脑假装让人看见

边策 鱼羊 发自 凹非寺

量子位 报道 | 公众号 QbitAI

眼见为实?不不,你以为你“看见”的世界,其实是大脑创造的。

这就是数学家带来的最新研究结论。

在我们错误的认知中,人的眼睛就像一台相机,可以直接拍下这个美丽的世界。

但事实并非如此,眼睛和大脑神经元相连数量太少,对于传输图像来说是远远不够的。

来自纽约大学的华人女数学家杨丽笙,与神经科学家Robert Shapley认为,数学才是破译人类视觉秘密的关键。

他们提出了一种单一的数学模型,解释了大脑如何根据少数神经元的数据生成绚烂多彩的图像。

这个模型,解释了视觉皮层中的神经元如何检测物体边缘和对比度的变化。现在,他们正在研究如何解释大脑如何感知物体移动的方向。

而且, 这一研究带来的影响,并不仅仅限于理解视觉, 对于研究神经网络,也多有裨益。

要理解他们的研究成果,首先要从人类的视觉神经构造说起。

眼睛如何看见世界

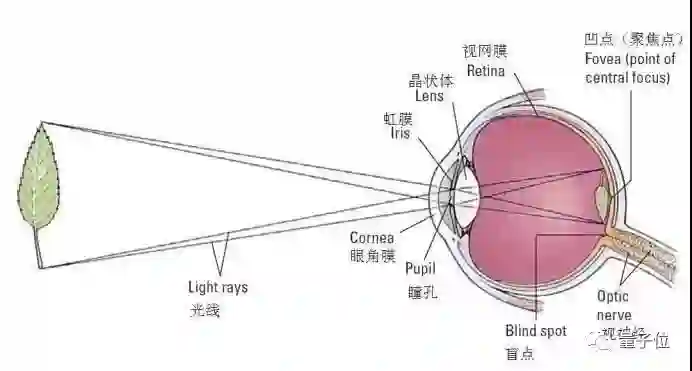

从构造上来看,人眼是一台照相机,但晶状体是镜头,视网膜是CMOS感光元件,而大脑是相机的图像处理器。

物体发出的光线经过晶状体的聚焦后,在视网膜上形成了一个倒立且缩小的图像。

在通常的认知中,人们一直认为,视网膜与大脑的连接就像就像CMOS与图像处理器的连接一样,视网膜将逐点扫描后的完整数据传输给大脑。

然而事实并非如此。解剖学的结果告诉我们,大约只有10个LGN神经细胞将视网膜连接到大脑的视觉皮层,从视网膜传递到视觉皮层的信息非常少。

这些神经细胞构成外侧膝状体(LGN),是视觉信息从外界传播到大脑的唯一途径。LGN不仅数量稀少,而且功能有限,它只能在检测到明暗的变化,然后将脉冲信号发送给视觉皮层。

大脑必须要做的是处理由LGN细胞传来的微弱信号。用如此少的信息来看清世界,就像是用餐巾纸上的简短笔记写出一部长篇小说。

“你可能会认为大脑正在拍摄你在视野中看到的东西,”杨丽笙说,“但大脑没有拍照,视网膜确实如此,从视网膜传递到视觉皮层的信息很少。”

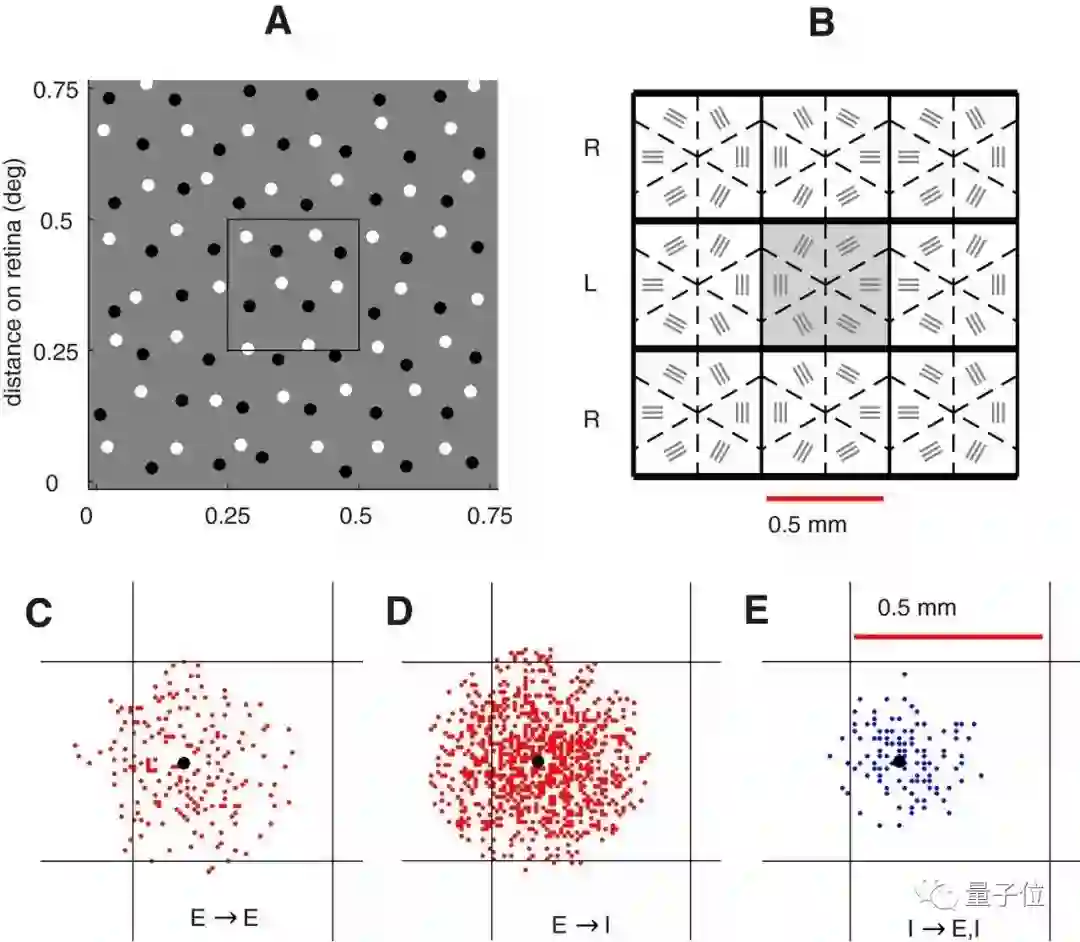

虽然视觉皮层和视网膜由相对较少的神经元连接,视网膜蜿蜒过来LGN神经元只有10个。但视觉皮层本身的神经细胞密度却很大,初始“输入层”中就有4000个神经元,其他部分则更多。

巨大的差异表明大脑会深度处理它收到的数量极少的视觉数据。

揭秘真相的数学模型

杨丽笙和Robert Shapley试图在大脑解剖学的基础之上,创建一个数学模型,解密大脑是如何根据有限的视觉信息生成人们所看到的美好世界的。

早期的视觉皮层模型认为信息仅以一种方式传递:从眼睛的前部到视网膜,再到皮层,最后形成视觉。这样的“前馈”模型易于构建,但忽略了皮质解剖学揭示的重要一点——视觉皮层中反馈回路扮演着重要的角色。

杨丽笙指出:

反馈回路很难处理,因为信息会不断回归并导致改变。

而它在大脑中又是无处不在的。

杨丽笙和合作者Robert Shapley,Logan Chariker从一开始就非常重视反馈回路。2016年他们合作发表的第一篇论文,他们在模型中引入了一个类似蝴蝶效应的反馈回路:

来自LGN(外侧膝状体核)的信号的微小变化在经过一个又一个反馈回路时被放大,这会最终导致模型产生的视觉表示发生比较大的变化。

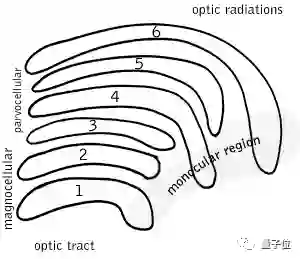

模型的主要组成部分是位于约5°偏心率的猕猴初级视皮层(V1)的一小块4Cα层。研究人员们将两片投射到4Cα区域的LGN细胞,以及第6层输出和4Cα的反馈层都进行了建模。

灵长类动物的LGN有六层,其中第1、4、6层接收一只眼的信息,第2、3、5层接收另一只眼的信息。

早前的研究表明,V1层的4Cα皮质输入层中可以观察到方向选择性和空间频率(SF)选择性。4Cα层接收来自大细胞LGN层的输入。

输入V1层的大细胞LGN非常稀疏,每个V1皮层柱中的4Cα层仅直接接收10个左右的大细胞输入。

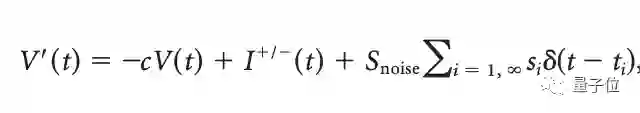

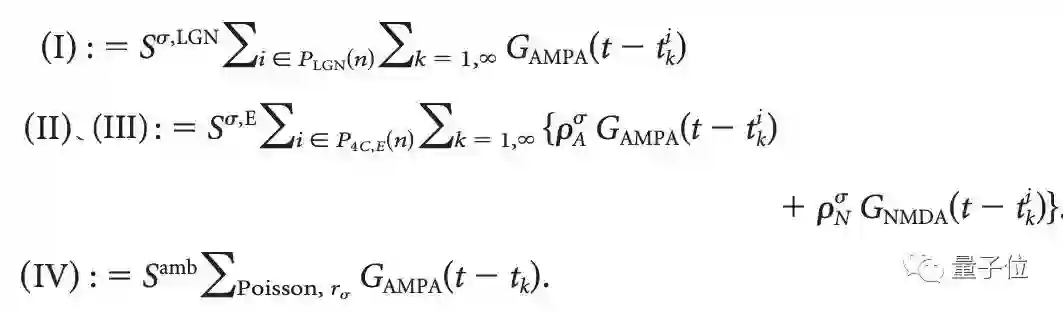

各个LGN细胞的动态可以用一个integrate-and-fire方程表示:

V表示膜电位,c=100,I+和I- 分别代表ON状态和OFF状态的LGN细胞,Snoise是泊松噪声项的耦合系数,ti是泊松噪声输入的达到时。

当V达到1左右,电位重置为0,并且尖峰被发送到4Cα层中的所有突触后细胞。

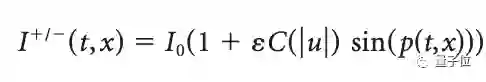

进入LGN细胞的电流I(t, x)则可以表示为:

LGN细胞的背景激发速率约20 spikes/s,被驱动时,峰值激发速率约100 spikes/s。被驱动时的LGN模型产生的激发模式更接近真实的LGN细胞,也就能更有效地激发V1细胞。

为了模拟神经元膜电位的时间演变规律,这里采用了归一化电压单位,其中静息电位Vrest=0,尖峰阈值Vth=1。

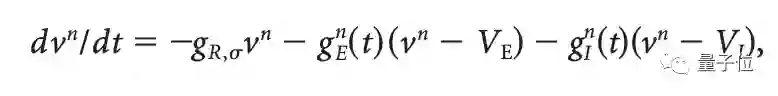

而通过下面这个LIF(leaky integrate-and-fire)方程,第n个神经元vn的膜电位会趋向标准化尖峰阈值Vth:

当vn达到Vth时,峰值被激发,并且vn被重置为0,这个过程中会有一段2ms的不应期。

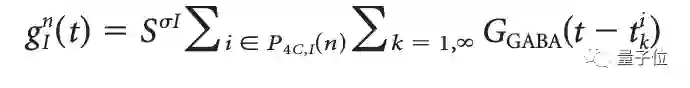

神经元n的I电导率gI^n(t)随时间变化如下:

而E电导率gE^n(t)是四个突触传导的总和,分别来自LGN,4Cα层,第6层和大脑或身体其他部位的神经调节的影响。

这个模型重要的新特性在于,它考虑了对V1层稀疏的LGN输入,这跟解剖学的结论是相匹配的。

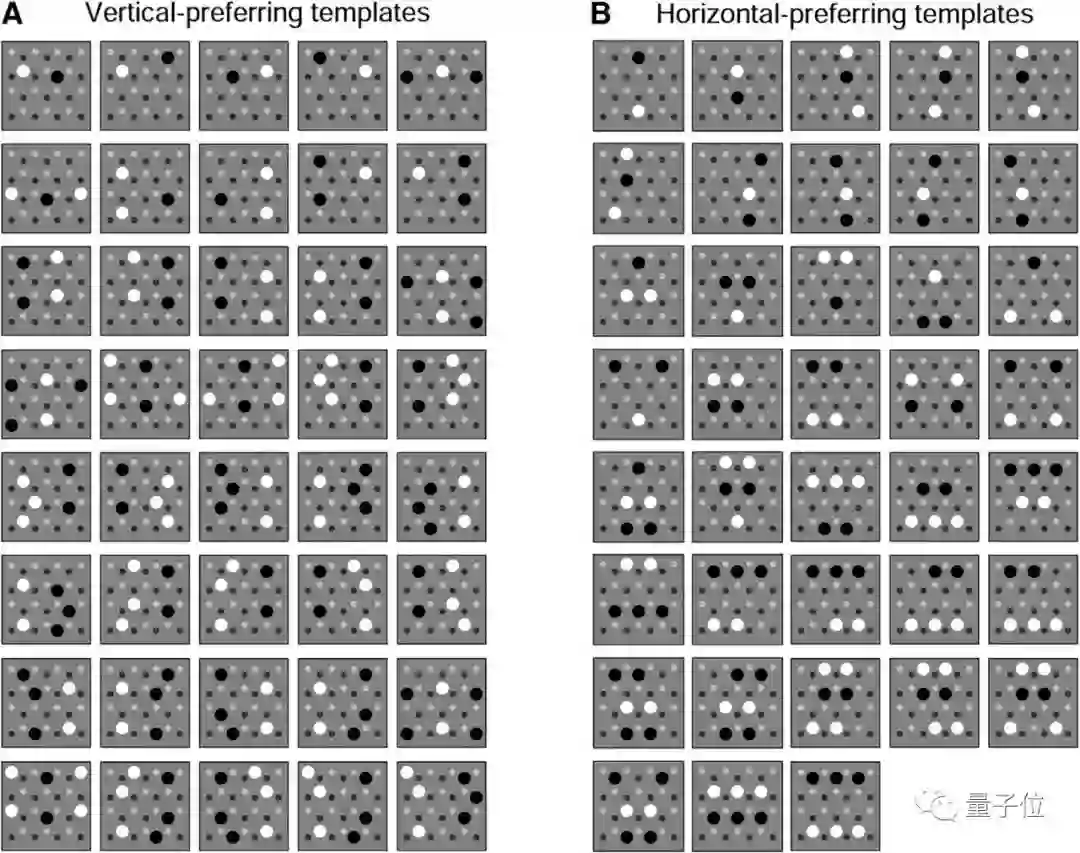

结果表明,他们这一反馈丰富的模型能够重现物体边缘的方向,无论是垂直,水平还是介于两者之间,而这些,都仅基于进入模型的少数LGN输入的微小变化。

这也就意味着,人们可以使用连接到其他神经元的少数神经元在视觉世界中生成所有的方向。

但视觉并不仅仅是边缘检测。

2018年,三位科学家发表了第二篇论文,他们用进行边缘检测的视觉模型再现了大脑皮质中伽马神经振荡的整体模式,从而证明了这一数学模型的合理性。

而在尚未发表的第三篇论文当中,科学家们还将解释视觉皮层是如何感知对比度变化的。这涉及兴奋神经元加强彼此活动的机制。

CNN

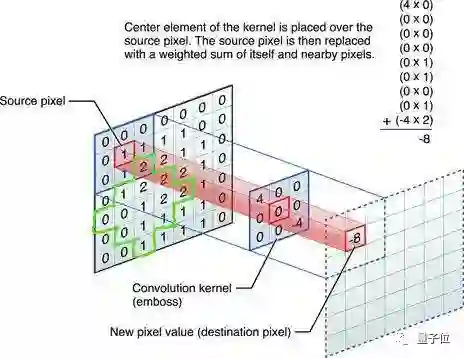

如果你觉得神经科学的理论太难理解,不妨看一下CNN的工作原理。CNN和人眼处理图像数据有很多相似之处,二者同样简化了图像与处理过程之间的连接。

对人工神经网络而言,如果对图像逐点处理,数据量将是巨大的。即使是最简单的MNIST数据集为例,图像分辨率只有28×28,直接用神经网络来处理,也有784个权重之多。

为此,CNN会先对图像做卷积处理,用卷积核找到图像的边缘,这部分才是处理MNIST所关心的信息。

在图像处理中有一个著名的“索伯滤波器”,可以分别检测到物体垂直和水平的边缘,与视觉神经何其相似。

经过卷积运算后,我们会发现图像中的相邻像素一般又具有相似的值,卷积层的输出也会产生相似的值,输出中包含的大部分信息都是冗余的。

引入池化层可以解决这个问题。所谓池化就是将卷积层输出的结果进一步压缩,取近邻之间的平均值或者最大值,减少输出数据的数量。

作者简介

杨丽笙(Lai-Sang Young)1952年出生于香港,现在是美国纽约大学科朗数学研究所的教授。她的研究方向包括动力系统、遍历理论、混沌理论、概率论、统计力学和神经科学。

虽然杨丽笙在香港出生和长大,但她接受的高等教育都是在美国:1973年获得威斯康星大学麦迪逊分校的学士学位,1976年和1978年分别获得了加州大学伯克利分校的数学硕士和博士学位。

1985年获得斯隆奖,1997年获得古根海姆奖,1993年获得美国数学学会颁发的Ruth Lyttle Satter奖,2004年当选为美国文理科学院院士。

她在1998年在Annals of Mathematics(注:数学类期刊影响因子排名前三)上发表的论文已经被引用718次。

Robert Shapley是纽约大学神经科学中心教授,本科毕业于哈佛大学,之后再洛克菲勒大学获得了神经生理学和生物物理学博士学位。

他的主要研究方向就是动物的视觉神经,在获得博士学位后,Shapley赴西北大学研究猫视网膜神经节细胞,之后又去剑桥大学研究人类视觉如何探测边缘。目前Shapley还在研究关于人类视觉皮层中的色彩感知和颜色表示。

论文传送门:

https://www.jneurosci.org/content/36/49/12368#F4

https://www.jneurosci.org/content/38/40/8621

参考链接:

https://www.quantamagazine.org/a-mathematical-model-unlocks-the-secrets-of-vision-20190821/

— 完 —

AI社群 | 与优秀的人交流

AI内参 | 关注行业发展

量子位 QbitAI · 头条号签约作者

վ'ᴗ' ի 追踪AI技术和产品新动态

喜欢就点「在看」吧 !