Adobe用机器学习“反PS”,修没修图一眼就看出来

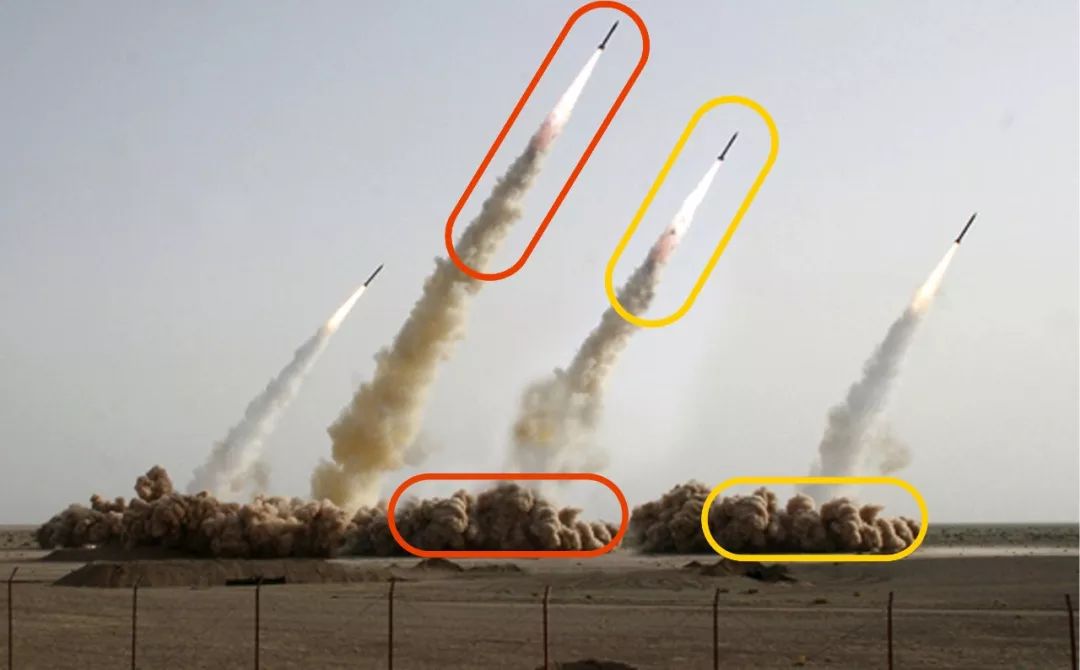

这是一张著名的PS照片,2008年伊朗政府在媒体上公布了他们成功发射导弹的照片,但是紧接着就有人出来打脸,证明了这张图是伪造的,可以看到底部的烟雾连形状都一毛一样。随着技术的发展,近几年人工智能也参与到“PS大战”中,譬如此前风靡reddit的deepfakes,以及将奥巴马换到某视频上做出一条假新闻等等。

自从AI可以轻松“换脸”,全球许多专家表示很担心,因为这种以假乱真的伪装术在社交媒体的推动下往往会产生难以控制的后果。著名的图形图像生产商Adobe公司也利用AI技术创造了许多相关技术,比如“一键换景”的工具。不过该公司同样也在开发“反伪装”工具,即利用机器学习自动发现经过编辑的照片。

上周,Adobe公司在CVPR 2018上展示了机器是如何在更短时间内自动识别出照片的修改痕迹的。这篇论文并不能看作计算机视觉领域的一大突破,并且还未投入商用,但是看到Adobe这个“PS专业户”发明“反PS工具”还是很有趣的。

在接受采访时,Adobe公司的发言人表示这个项目还处于早期,但是在未来,公司将着力于“开发能帮助检测和验证数字媒体真实性的工具”。这一技术具体是什么还不知道,因为Adobe从未发布过用于发现假照片的工具。但是该公司曾利用数字取证帮助找到失踪儿童的行为,也表明他们对自己技术的负责态度。

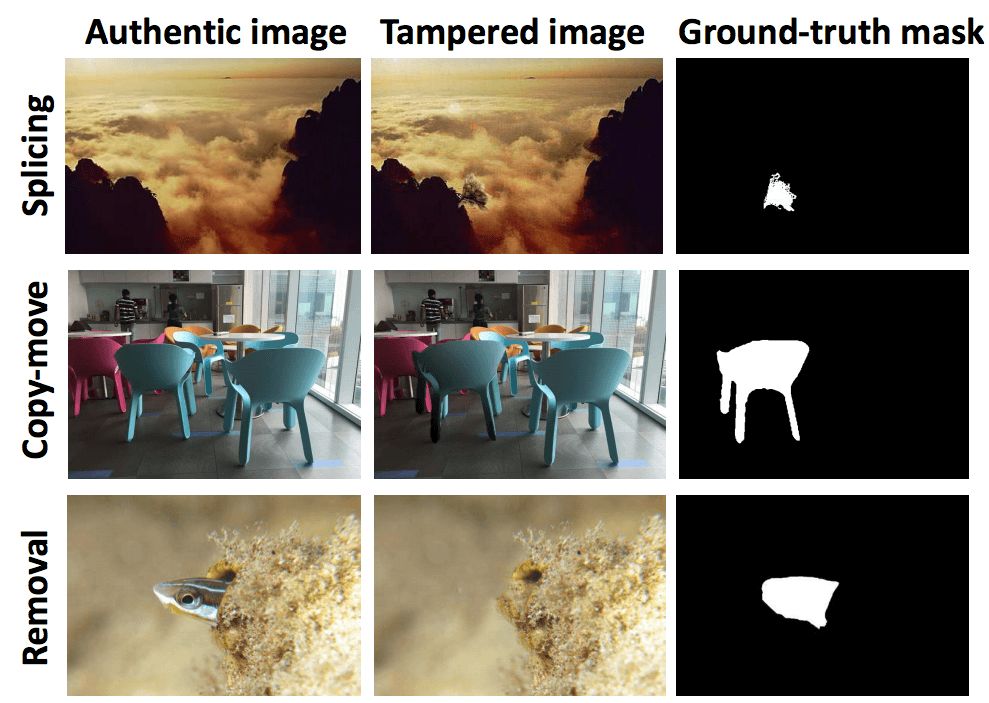

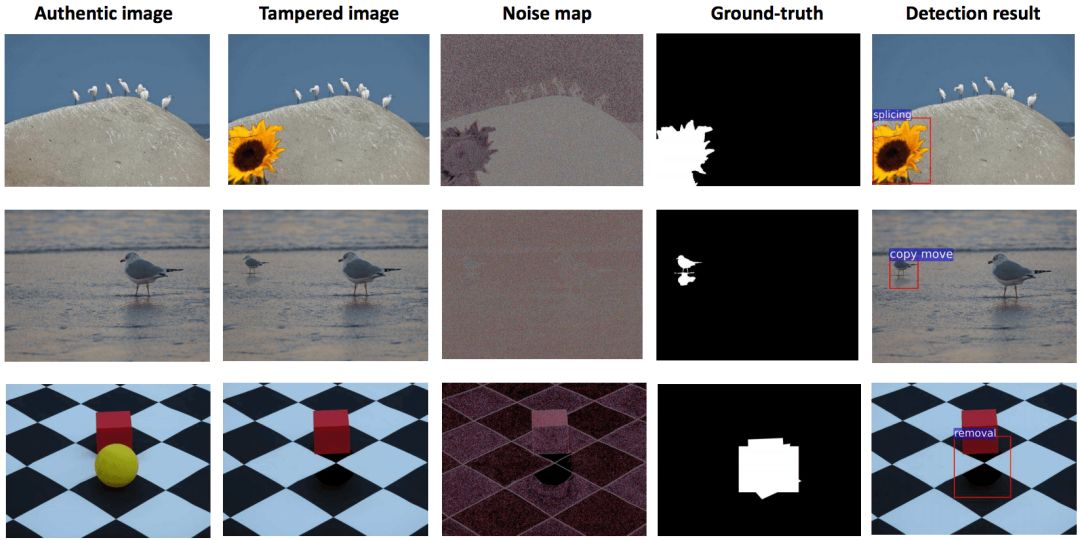

这次的新论文展示了如何用机器学习发现图像的三种改变:拼接(即将不同图像的两部分合在一张图上)、复制(一张图像中出现了两处相同的地方)、删除(某一对象从图中被移除了)。

为了发现这些特点,科学家们通常会在图像的隐藏层中寻找线索。当图像经过这些编辑时,它们会留下数字化痕迹,例如图像传感器产生的颜色和亮度的不一致性(也被称为图像噪声)。当你将两张不同的照片拼在一起,或者从另一张图中复制粘贴其中一部分,背景噪声是不匹配的,就像用有些许色差的油漆掩盖墙壁上的污渍。

和其他许多机器学习系统一样,Adobe的新成果也是在大量数据上训练的结果。从这之中,它学会了辨认图像经过处理后的一般特征。

下面让我们来看看论文具体讲了什么:

随着各种图像编辑技术和软件的层出不穷,几乎人人都能掌握一些P图技巧,如下所示就是三种常见的PS手段:

从上至下依次是拼接(山上多出了一棵树)、复制(原图中左边的蓝色椅子被换成了和右边一样的椅子)、删除(小鱼被抹掉了)

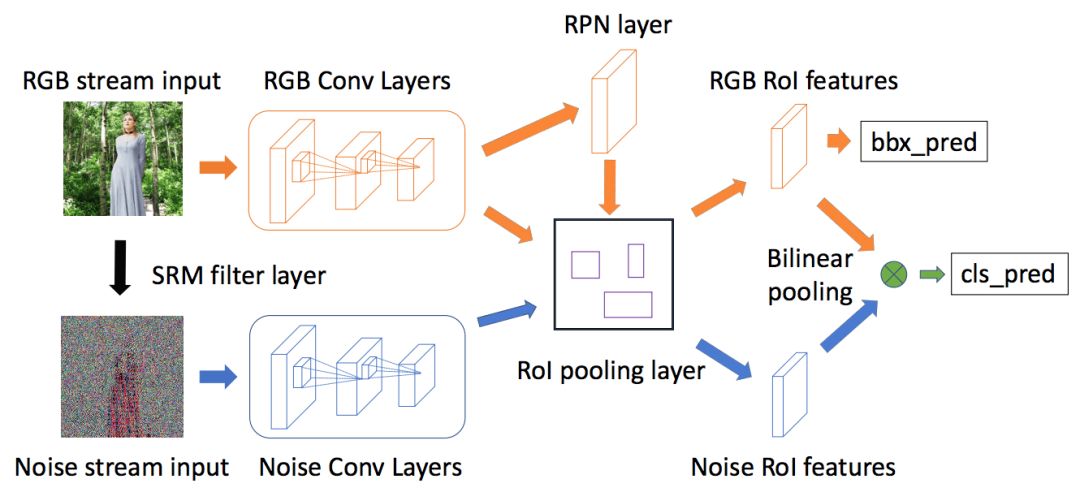

所以想要区分真实照片和经过处理的照片就非常困难。而在本次CVPR 2018上,Adobe的研究者带来了一种多任务框架,既能对图片的人工处理进行辨认和分类,同时还能进行边框回归(bounding box regression)。这一项目的网络架构如图所示:

这是有两条通道的Faster R-CNN网络,上面一层是输入RGB图像的通道,下面是输入SRM图像的噪音通道。研究人员通过双线性池化,将两种通道结合在一起。

其中RGB通道是单一的Faster R-CNN网络,它既可以用来执行边框回归,也可以进行图像伪造辨认。我们用ResNet 101网络去学习输入的RGB图像特征,最后卷积层输出的特征就用来辨别图像经过何种处理。

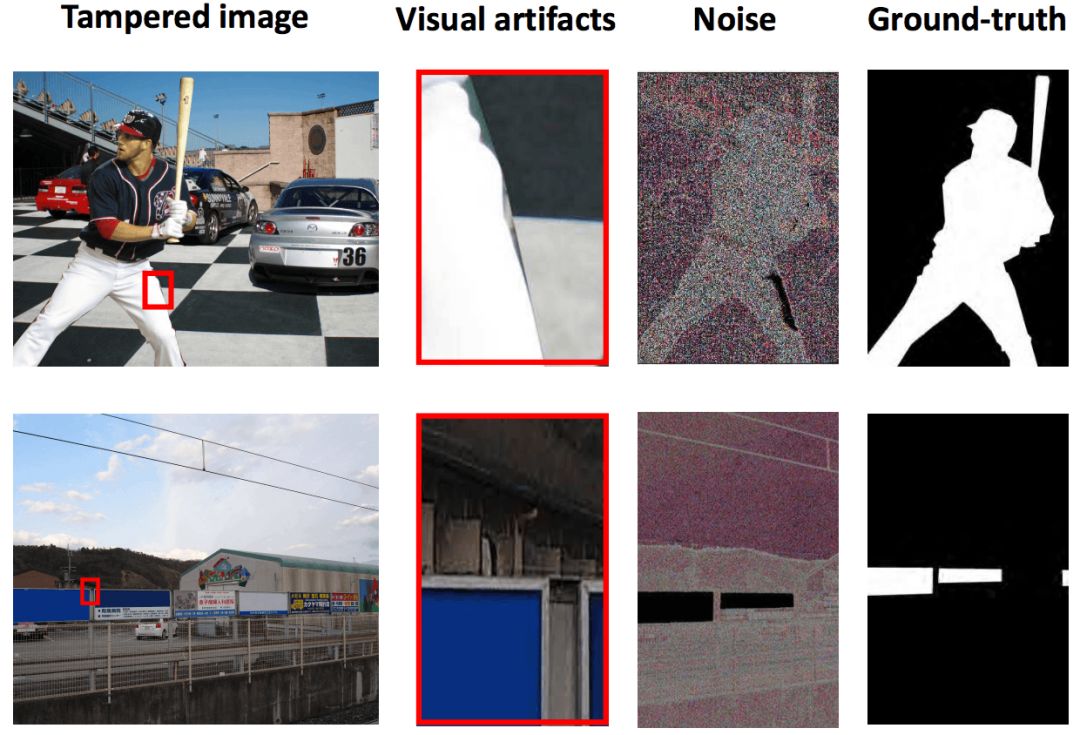

但是只有RGB通道还不足以处理所有的P图手段,尤其是经过后期精心处理的,掩盖住了拼接边缘的图像,这对RGB通道来说是个挑战。于是我们将图片中的局部噪声分布当做额外的考虑因素。与RGB通道不同,噪声通道关注更多的是图中的噪声而不是语义内容。如下图所示:

上图中,将红色边框放大后可以看到在边界处有明显的不自然线条。另外,第三列图片还显示了拼接图片和原始图片之间噪声的不一致性。

两个通道处理完毕后,网络会将二者在图像检测上的结果结合起来。在众多融合方案中,他们选择了双线性池化,这一方法最初是用于对分类进行微调的。

最终结果

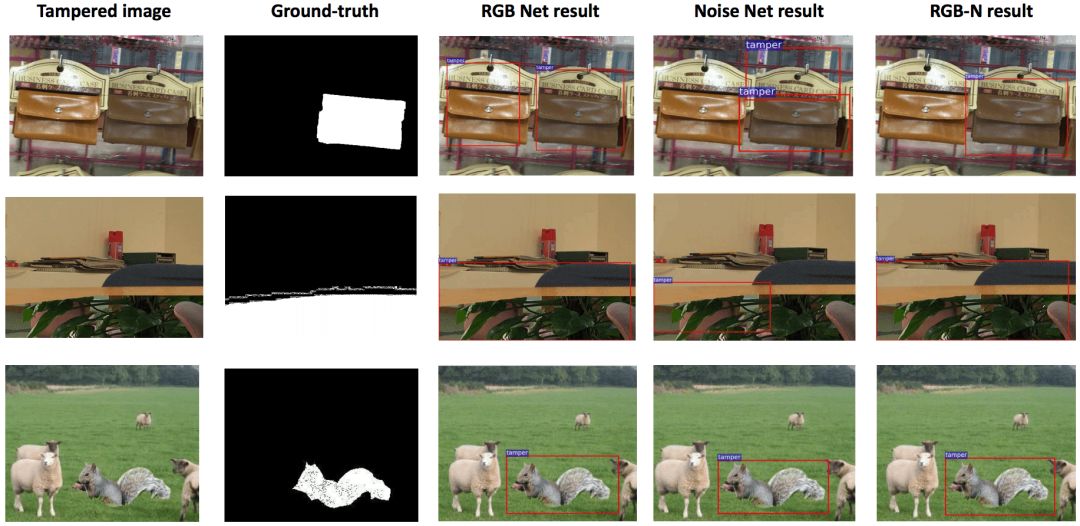

以上是网络进行P图检测的几个例子,第一行的例子来自COVER数据集,在单独的RGB和噪声检测结果中,系统的检测结果都不准确,但是在本次提出的模型上(RGB-N),系统成功地标出右边的皮包是“伪造”的。

另外,网络还能识别出P图所用的技术,上图就是拼接、复制和删除的三个不同示例。

结语

通过论文,研究人员将两种通道结合,毫无疑问地提高了对图像修改痕迹的辨认程度。在数据集上的测试也证明了这种方法不仅能看出“人工痕迹”,还能对此进行分类。图像识别专家Hany Farid在接受The Verge采访时表示:“这些机器学习新工具的好处在于,它们能发现不明显甚至从未被发现的人工痕迹。但是缺陷在于,它们只在被输入到网络中的训练数据上表现良好,而且至少目前为止,它们不太能学习更高级的伪造痕迹,例如发现阴影或倒影的不规则之处。”

除了这些不足之处,我们仍然很高兴看到这些能帮我们发现虚假信息的技术的出现。虽然人工智能可能会带来危害,但它也能帮助我们。

论文地址:openaccess.thecvf.com/contentcvpr2018/papers/ZhouLearningRichFeaturesCVPR2018paper.pdf